2024年11月,莱斯特德蒙福特大学网络安全教授Eerke Boiten发表了一篇警示文章,题为「当前的AI是一条死胡同吗」。

在这篇文章中,Boiten教授从软件工程的角度出发,分析了当前AI技术在管理和控制方面的重大缺陷。

他表示,AI系统的本质问题在于它们无法与已有的软件工程实践有效结合,尤其是在复杂性管理和规模控制方面。尽管AI在诸如自动化、医疗、金融等领域取得了显著成就,但其核心问题在于无法确保系统在规模化应用中的可控性与可靠性。

AI的复杂性管理问题

Boiten指出,目前的AI系统与传统软件开发标准存在严重的不匹配。

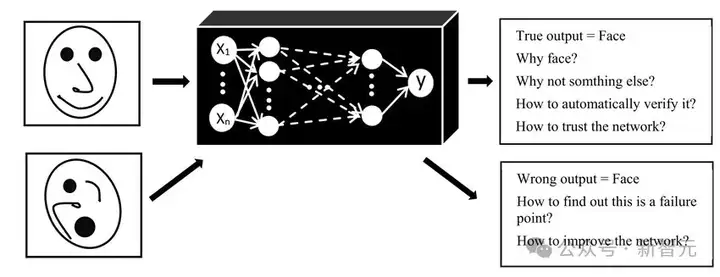

软件工程的基本原则之一是,关键系统必须具备可管理性、透明性和问责制,而AI技术恰恰在这些方面存在缺陷。

例如,许多现代AI系统,尤其是基于深度学习的模型,在训练和应用过程中缺乏透明的决策过程,且很难追溯和解释其决策依据。

这种「黑箱」性质让AI系统在关键任务中的应用充满风险。尤其是在涉及人类生命健康、金融交易、网络安全等领域时,无法控制的系统可能带来灾难性的后果。

正因如此,Boiten认为,当前AI的不可管理性本质上让它无法在这些领域担任核心角色。

缺少可靠性

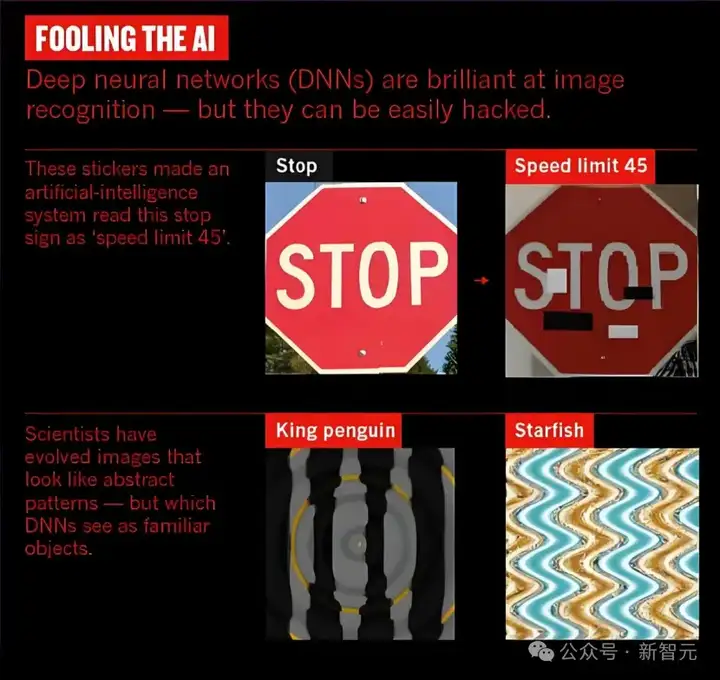

此外,Boiten还强调了AI系统在可靠性方面的不足。

虽然AI的表现常常令人惊叹,但其本身的可靠性依然远未达到理想的水平。在进行高风险决策时,尤其是在医疗、司法、金融等领域,AI的错误率仍然不可忽视。

例如,AI在图像识别中的误差率可能较低,但在医学诊断中,哪怕是极小的错误也可能带来致命后果。

AI的在可靠性上的缺陷不仅仅体现在其技术能力上,更体现在其系统架构的可管理性上。

由于缺乏有效的监管和透明的设计,AI系统往往难以在严格的工程标准下工作。在面对不断变化的现实情况时,AI的决策过程可能会出现不稳定和不可预测的情况,这就增加了在关键领域应用它们的风险。

「可解释AI」并非终极答案

为了应对AI的复杂性问题,业界提出了「可解释AI」的概念,试图使AI的决策过程更加透明和易于理解。

这种方法看似解决了长久以来被诟病的「黑箱」问题,但Boiten指出,这一解决方案并不能根除问题。

他认为,「可解释AI」并没有改变AI在复杂应用场景中的根本缺陷,它只是尝试解释现有模型的内部工作方式来减少不确定性。然而,这并不意味着AI能够在所有领域都能高效且可靠地运行。

因此,AI技术的进一步发展不能单纯依赖于「可解释性」,而应该更多地关注如何提升AI系统的可控性和安全性。对于AI的监管和标准化,目前还没有形成统一且有效的行业规范,而这一缺失将导致其在未来面临更大的挑战。

数据责任:难以跨越的障碍

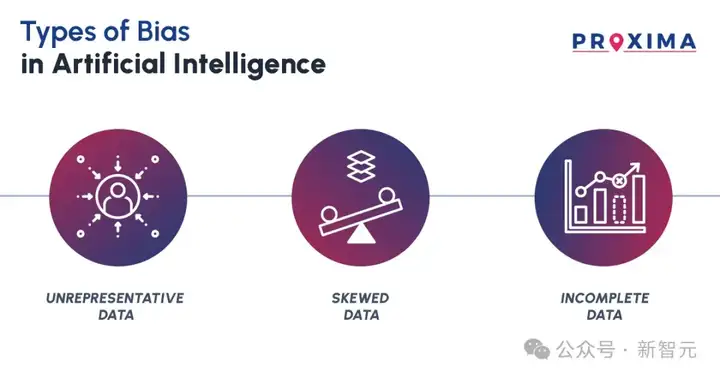

除了「可解释性」和「可靠性」,Boiten还指出,AI技术面临的另一个巨大挑战是数据责任问题。

AI系统的决策质量,高度依赖于训练数据的质量,但目前很难有效保证数据的公正性、完整性和代表性。

由于数据存在偏差,AI模型可能会产生带有偏见的判断,这在一些敏感领域尤为严重,如司法审判、招聘决策等。

尽管业界推出了多种方案来减少数据偏见,但Boiten称,这些方案仅仅是隔靴搔痒,并未触及问题的根本。

随着AI技术的发展和应用场景的扩大,数据偏见和隐私问题将变得更加严重。如果得不到有效解决,我们将不可避免地面临伦理和法律风险。

未来展望:潜力与挑战并存

Boiten教授的警示并不是对AI技术的全盘否定,而是对其在关键应用中的风险进行了深刻反思。

他承认,AI在许多领域已经展现出了巨大的潜力,尤其是自动化和数据处理等方面。然而,更广泛的应用必须在更加严格的工程标准下进行。对于那些影响人类安全和生活质量的领域,AI的使用需要更加谨慎和透明。

文章的最后,Boiten回答了开头抛出的问题——AI的未来并非一条死路,但当前的技术瓶颈和管理难题确实需要引起足够的重视。

如果业界能在提升可控性、透明度和可靠性方面取得突破,AI将能在更广泛的领域内发挥其潜力。否则,上述这些挑战足以限制AI在关键领域的落地,甚至让我们走进「死胡同」。

参考资料:

https://www.bcs.org/articles-opinion-and-research/does-current-ai-represent-a-dead-end/

文章来自微信公众号 “ 新智元 ”