近年来,大语言模型(LLM)的性能提升逐渐从训练时规模扩展转向推理阶段的优化,这一趋势催生了「测试时扩展(test-time scaling)」的研究热潮。

OpenAI 的 o1 系列与 DeepSeek 的 R1 模型已展示出显著的推理能力提升。

然而,在实现高性能的同时,复杂的训练策略、冗长的提示工程和对外部评分系统的依赖仍是现实挑战。

近日,由 a-m-team 团队提出的一项新研究提出了一个更简洁直观的思路:三思而后行(Think Twice)。

它不依赖新的训练,不引入复杂机制,仅通过一种非常人类式的思维策略 ——“再想一轮”—— 在多个基准任务中带来显著性能提升。

- 论文标题:Think Twice: Enhancing LLM Reasoning by Scaling Multi-round Test-time Thinking

- 论文连接:https://arxiv.org/abs/2503.19855

- 项目地址:https://github.com/a-m-team/a-m-models

“Multi-round Thinking”

一轮不够,那就两轮、三轮

该方法的核心思想类似于人类在做题时的反思机制:

模型先基于原始问题生成第一次答案,再将该答案(而非推理过程)作为新的提示,促使模型独立 “重答” 一次,并在每一轮中不断修正先前的偏误。

这个过程中,模型不会受限于上一次的推理轨迹,而是以一个「结果驱动」的方式自我反思与纠错,逐步逼近更合理的答案。

研究人员指出,这种策略有效缓解了大模型推理中常见的 “认知惯性”,即模型过度依赖初始推理路径而难以跳脱错误逻辑。

不靠训练,也能提升多个基准性能

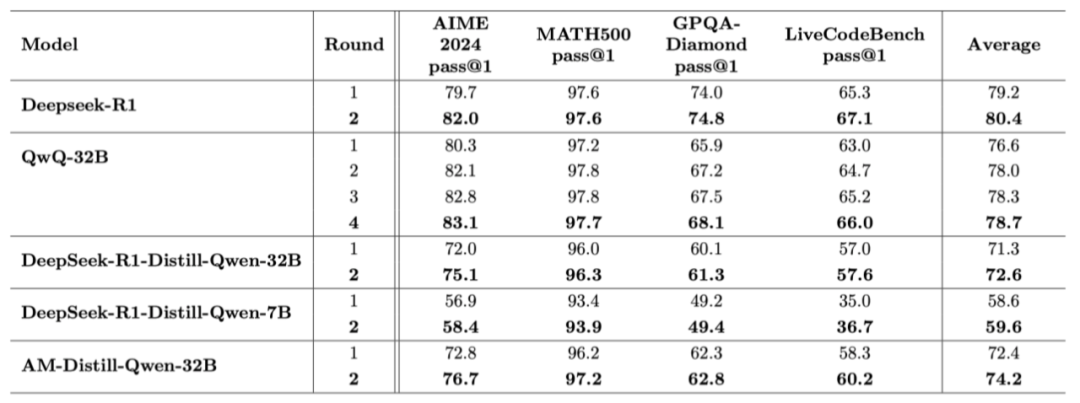

研究团队在四个权威数据集上验证了该方法,包括:

- AIME 2024(美国数学邀请赛)

- MATH-500(由 OpenAI 从原始 MATH 数据集中精选出 500 个最具挑战性的问题)

- GPQA-Diamond(研究生级别问答)

- LiveCodeBench(编程任务)

在不改变模型结构、无额外训练的前提下,DeepSeek-R1 和 QwQ-32B 等主流模型在所有测试集上均表现出不同程度的提升。例如:

- DeepSeek-R1 在 AIME 上从 79.7% 提升至 82.0%

- QwQ-32B 在 AIME 上从 80.3% 提升至 83.1%

更值得注意的是,在进行 2 轮、3 轮甚至 4 轮的 “再思考” 后,准确率稳步上升,模型表现出更强的稳定性和反思能力。

更短的答案、更少的犹豫

模型开始 “自信发言”

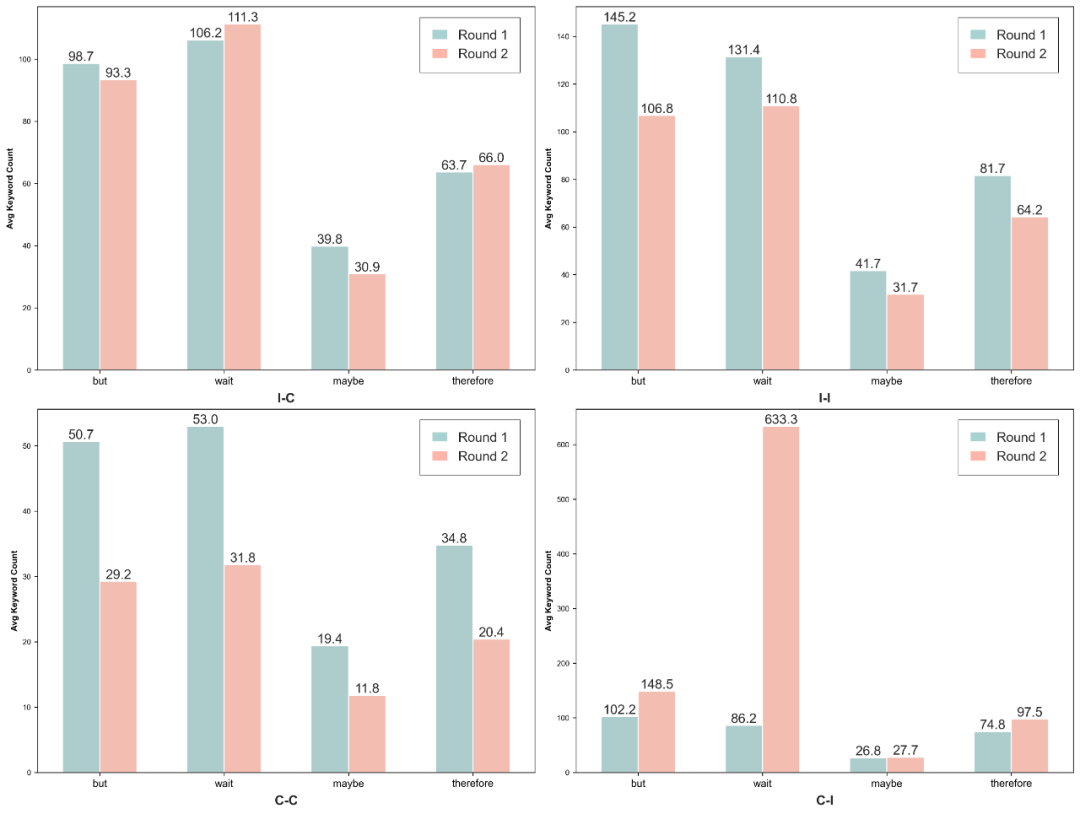

除了准确率的提升,研究团队还观察到了语言风格的变化。通过分析模型生成内容中 “but”、“wait”、“maybe”、“therefore” 等语气词的使用频率,他们发现:

- 模型在第二轮中使用 “but”、“wait” 等不确定词的频率明显减少;

- 即使在多轮中仍答错,模型的表达也趋向更加简洁、自信;

- 当模型成功从错误中修正时,常伴随着更慎重的过渡语,例如 “wait”、“therefore” 增多。

这种变化表明,多轮推理不仅提升了结果准确性,也改变了模型的表达风格,使其在回答时更加 “像人类”,且逻辑清晰。

不同推理路径中平均词频的变化。每个子图展示了四个具有代表性的词语 —— “but”(但是)、“wait”(等等)、“maybe”(也许)和 “therefore”(因此)——

在第 1 轮与第 2 轮中的平均词频,对回答类型进行分组:I-C(错误 → 正确)、I-I(错误 → 错误)、C-C(正确 → 正确)和 C-I(正确 → 错误)。

多做题同时多思考

可能是更好路径

这项研究的一个关键优势在于:它完全作用于推理阶段,不需要额外的训练资源,即插即用。

这种方法对于模型部署阶段的优化具有高度实用性,同时也为后续研究提供了可拓展的思路 —— 如何结合监督微调,或构建更智能的多轮判断机制。

目前研究团队已尝试使用基于多轮推理结果的监督微调数据对模型进一步训练,初步结果显示尚未显著突破,但为 “训练 + 推理” 的结合方向奠定了基础。

结语

“Think Twice” 展示了一种简单有效的思路:鼓励大模型主动 “反思”,用多轮推理激发更强的认知能力。

它不仅提升了准确率,更令模型在语言表达上变得更加理性、紧凑、自信。

在训练成本不断攀升的今天,这种无需再训练的 “轻量级优化” 无疑具有极强的现实吸引力。

未来,多轮推理或许能成为一种标准机制,帮助模型更接近真正意义上的 “会思考”。

文章来自于微信公众号 “机器之心”,作者 :机器之心

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner