字节Seed团队视频生成基础模型,来了。

Seaweed海藻,“Seed-Video”的缩写(真是好一个谐音梗!)。

首发仅70亿参数,却能实现超越同类140亿参数视频模型的效果——

它能根据文本描述创建各种分辨率(原生支持1280x720分辨率)、任意宽高比和时长的视频。

比如直接来个20秒的Driving长镜头。

它是使用665000 H100 GPU小时完成训练,而同类模型通常需要超百万GPU小时,其相当于是1000个H100训练27.7天完成。

而且中小团队可部署,仅需40GB显存单GPU就可生成分辨率达1280x720的视频。

来看看短片展现出来的基础实力,整个视频唯一需要手动添加的是背景音乐和片尾字幕。

字节最新视频生成模型

作为基础模型,其标志性功能一定得具备。

比如像开头小短片这种人/动物、景观生成已经属于是洒洒水。

它支持图像生成模型,控制功能也增强,并支持首尾帧调节

并且支持微调,根据「参考主体」图像生成视频,单幅多幅都可以,将其合成为动态视频序列。

而结合字节多模态数字人方案Omnihuman——一张图、一段音频,就可以生成一段人物视频。它可以创建人声更为匹配人物角色,唇部、肢体动作都跟着音频一起同步。

此外,它还支持用视频生成音频,来配合视频的叙事场景、风格。

来感受一下~

在这些基础功能之上,Seaweed还技术大放送,结合过往技术成果展现了新的体验。

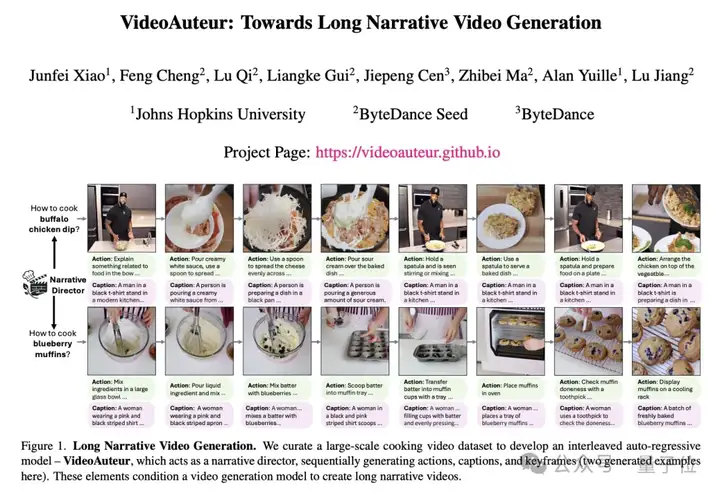

长篇故事叙述,用户既可以为整体叙事提供全局文本描述,也可以为每个镜头提供细粒度的文本描述。

这背后结合「长上下文调优」、面向长篇叙述生成「VideoAuteur」等技术。

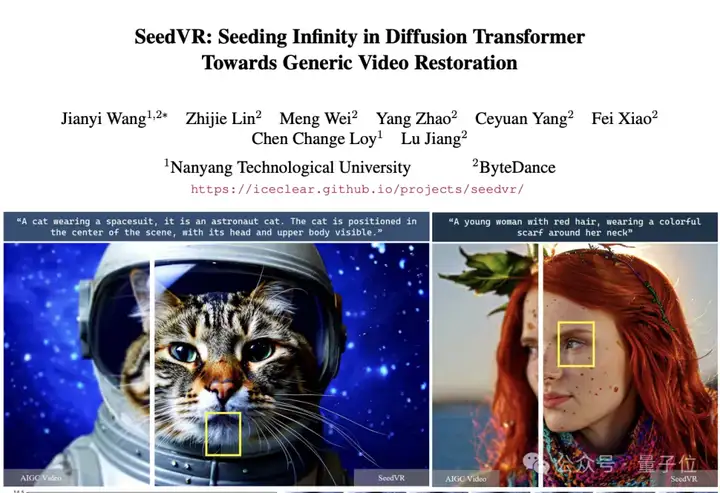

- 高分辨率

除了原生支持1280x720分辨率,还支持进一步采样至2K(2560x1440)。

背后是基于SeedVR,基于Diffusion Transformer实现通用视频修复。

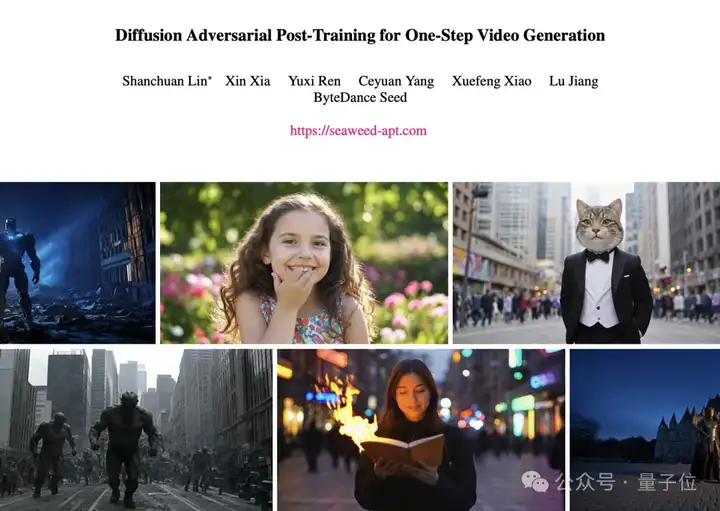

- 实时生成

可实时生成分辨率为1280x720、帧率为24fps的视频。

此外,还支持「摄影机」控制生成、物理一致性生成,背后分别有CameraCtrl II、SimDrop技术加持。

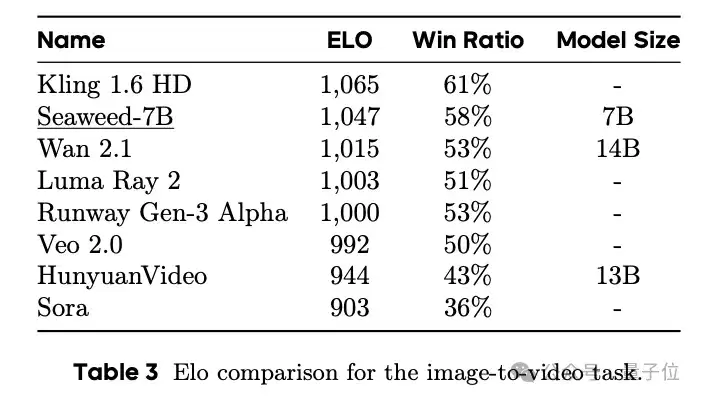

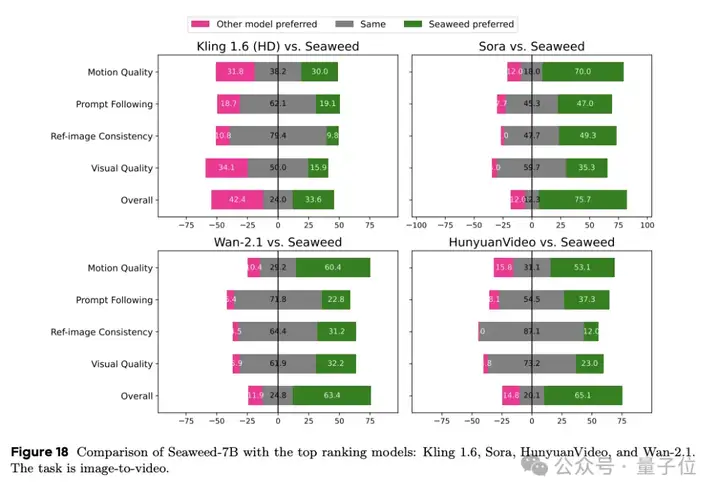

与其他模型对比情况。

图像到视频任务。

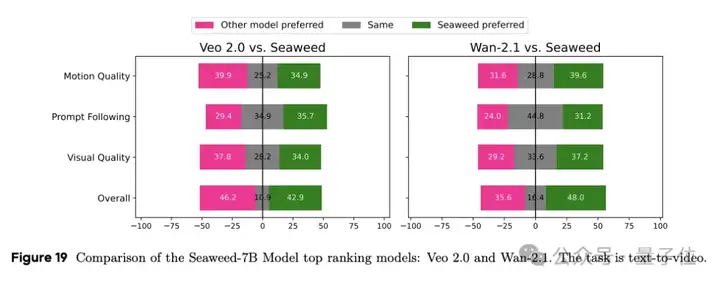

文本到视频的任务。

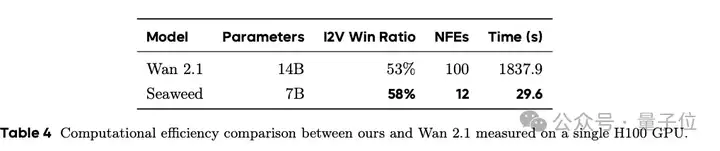

在单个H100 GPU运行中,Seaweed响应速度是Wan-2.1(参数量是前者两倍)的62分之一。

技术报告:三大技术创新

不过更详细的技术细节,还是集中在技术报告里。

整篇技术报告核心讨论的就是一个问题:在视频生成基础模型的训练上,如何实现低成本高效益。

他们选择训练一个中等规模的模型——约70亿个参数的DiT模型,使用665000个H100 GPU Hours从头开始训练该模型,相当于在1000个H100 GPU上训练27.7天。

具体在数据处理、模型架构设计、以及训练策略和优化方面三个方面的技术创新。

首先是数据这块。

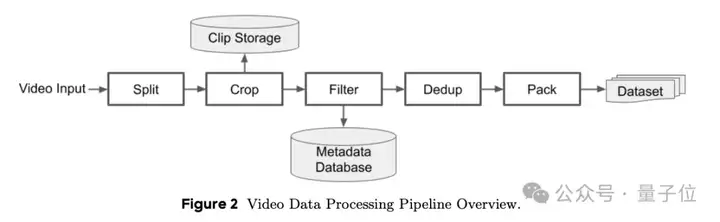

他们有一套全面的数据处理管道,其中包括但不限于时间分割、空间裁剪、质量过滤、多视角数据平衡、重复数据删除和视频字幕。

每一个步骤都有他们详细的处理细节。

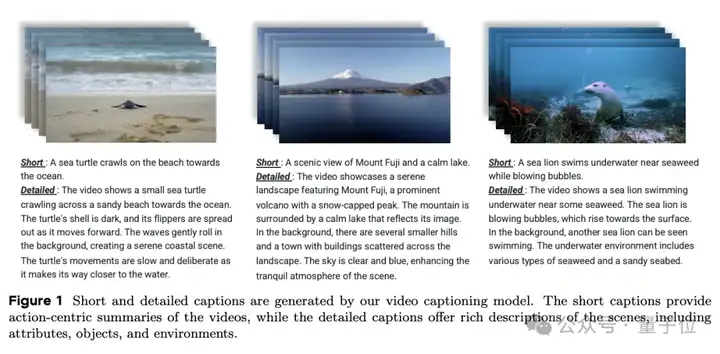

以字幕任务为例,他们发现使用更大的72B LLM可以减少幻觉。但是,使用72B模型为数百万个视频生成视频字幕的计算成本要高得多。

于是他们选择将72B作为教师模型然后蒸馏出7B的学生模型,节约成本的同时还提高了准确率。此外他们还将详细字幕「推导」成简短字幕,类似于思维链过程,结果进一步提高简短字幕的准确率——从84.81%到90.84%。

利用这一基础设施,他们每天可以处理超过500000小时的视频数据。

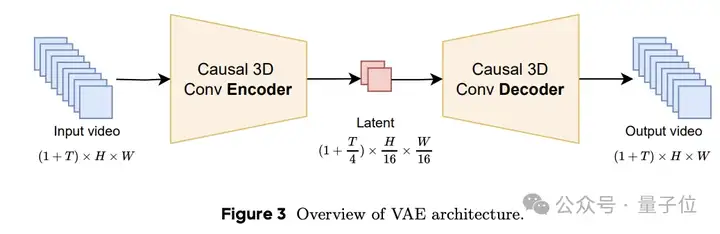

然后再是模型架构设计上面,由64x压缩比 VAE与Diffusion Transformer结合组成 Seaweed 。

VAE这边,由一个编码器和一个解码器组成,编码器将原始像素数据压缩到一个紧凑的潜在空间,解码器则根据这些潜在特征重建原始输入像素。理想的VAE应在保持较高重建质量的同时实现较高的压缩比。

这种设计为视频生成提供了两个优势,首先,它统一了图像和视频编码,使第一帧条件图像视频生成任务变得自然。其次,它消除了两个推断片段之间边界的闪烁,并允许编码和解码任意长的视频,而无需人工拼接。

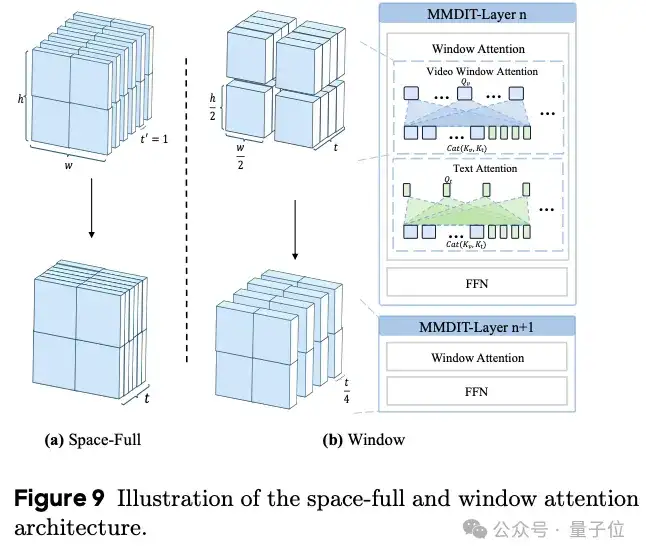

而在Diffusion Transformer这边,他们用图像和视频的原始分辨率和持续时间对它们进行混合训练。为了平衡运行时间的计算,较短的序列被打包在一起。

最后就是多阶段多任务学习训练策略。

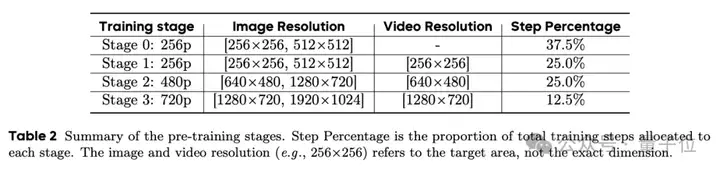

他们采用了从低分辨率到高分辨率的多阶段渐进式的训练策略。这一设计侧重于在训练过程中战略性地分配 GPU 资源,以提高整体质量。

Pre-Training阶段,他们只通过低分辨率图像对模型进行预训练,这样就能建立文本摘要与常见视觉概念之间的对齐关系。

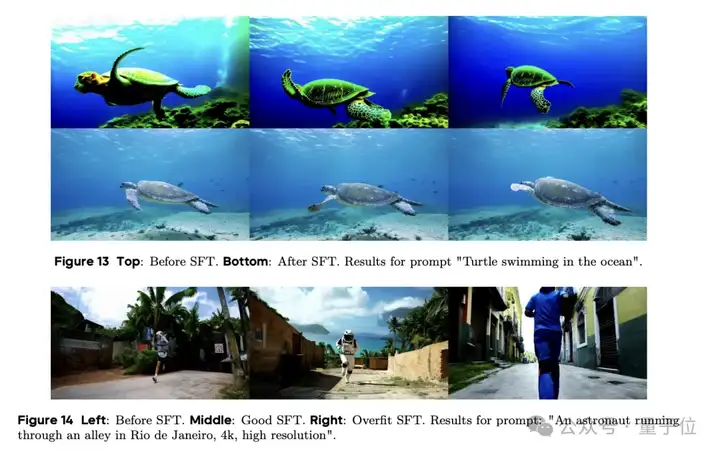

Post-training阶段。我们会应用监督微调(SFT),然后是人类反馈强化学习(RLHF),以进一步提高输出结果的美学质量、动作一致性和结构连贯性。

Just Like This~

这一阶段分别针对文本到视频和图像到视频任务进行。

而在更具体Infra层面的优化,他们还做了这些方面的措施。

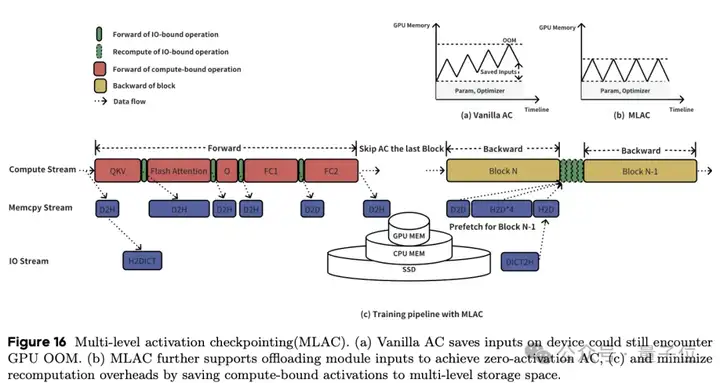

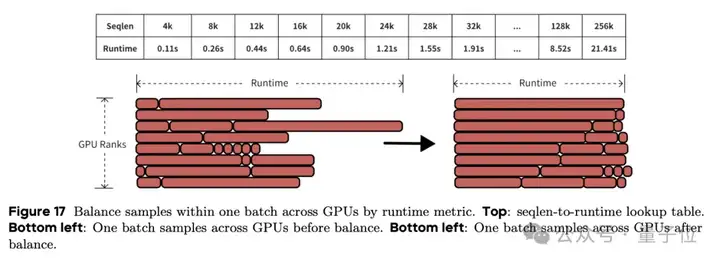

比如采用并行策略在长语境视频中训练7B模型;引入了运行时平衡(Runtime Balance)策略,以减轻图像和视频联合训练过程中的负载不平衡;还设计了多级激活检查点(MLAC),以减少GPU内存使用量和重新计算开销。

最后,还通过实施融合的CUDA内核来简化零散的I/O操作,从而优化GPU利用率。

因此,在大规模分布式训练中,Seaweed-7B的模型FLOPs利用率(MFU)达到了38%。

Seed研究团队大曝光

而在官网最后,背后研究团队也都全部曝光。

由蒋路、冯佳时、杨振恒、杨建超带领的研究团队。

其中蒋路正是去年加盟字节的前谷歌高级科学家,曾负责谷歌视频生成工作,在多个谷歌产品(如YouTube、云服务、AutoML、广告、Waymo和翻译)中做出了重要贡献,同时也是CMU兼职教授。

冯佳时则是首次曝光的「关键8人」之一,大模型视觉基础研究团队负责人,专注于计算机视觉、机器学习领域的相关研究及其在多媒体中的应用。

具体研究团队成员如下:

基础设施以及贡献者还有这些:

参考链接:

[1]https://seaweed.video/

[2]https://arxiv.org/abs/2504.08685

[3]https://x.com/CeyuanY/status/1911618555210334350

文章来自于“量子位”,作者“白交”。

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales