本文详细介绍了斯坦福大学最新提出的"以弱驭强"(W4S)范式,这一创新方法通过训练轻量级的弱模型来优化强大语言模型的工作流。核心亮点包括:

- 通过马尔可夫决策过程和强化学习实现弱模型自动设计最优工作流;

- 在数学推理、问答和代码生成等多领域任务上,性能提升高达24.6%,代码生成准确率达95.4%;

- 极低的训练成本(仅需一小时GPU时间)与惊人的泛化能力;

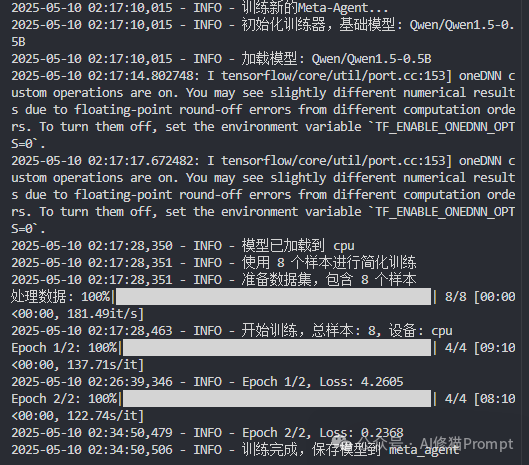

- 我使用更轻量的Qwen1.5-0.5B模型优化腾讯混元(Hunyuan-T1-Latest)复现了W4S系统,进一步验证了方法的实用性。

研究团队

本研究由斯坦福大学的Fan Nie(第一作者)领导,与指导老师James Zou教授及团队合作完成。Fan Nie是斯坦福大学的博士研究员,专注于生成式AI与大语言模型领域的创新研究。James Zou是斯坦福大学生物医学数据科学副教授,同时也是计算机科学和电气工程系教授,斯坦福AI实验室成员,以及两度获得陈-扎克伯格研究员称号的杰出学者。

该团队在机器学习、可靠AI和医疗健康应用领域拥有丰富经验,通过其研究站点(james-zou.com和fannie1208.github.io)可了解更多信息。

论文地址:https://arxiv.org/abs/2504.04785

代码地址:https://github.com/fannie1208/W4S/tree/main

大模型的潜力与现实困境

我们在开发Agent产品时,或许已经体会到直接调用最强大的大语言模型(LLM)并不总能获得理想结果。无论是复杂推理还是领域特定任务,单纯依赖强模型往往效果有限,而对这些模型进行微调又成本高昂、难以落地。

研究者提出,能否用更小、更灵活的模型,来设计和优化强模型的工作流,从而高效释放大模型的潜力?

W4S:弱模型为强模型"驾车"

研究者提出了"以弱驭强"(Weak-for-Strong Harnessing, W4S)这一新的方法,其核心思想是训练一个弱小但高效的Meta-Agent,让它专门为强模型设计最优工作流。与传统的"弱监督强"或"弱分发强"不同,W4S让弱模型成为强模型的"调度员",通过不断试错和反馈,自动优化强模型的使用方式。

💡 思维转变:你可以把它理解为让一个聪明的"小管家"反复琢磨如何用好家里的"超级大脑"。

方法:多轮MDP与强化学习驱动

W4S将工作流设计问题形式化为多轮马尔可夫决策过程(MDP),每一步都由弱Meta-Agent分析历史、生成新工作流、执行并收集反馈。具体来说,弱模型会:

- 先分析任务和历史表现

- 再生成一段可执行的Python函数

- 调用强模型完成任务

- 最后根据反馈不断调整优化

整个过程通过强化学习(RLAO)离线训练,奖励机制既鼓励绝对提升,也关注相对进步,确保弱模型能持续进化。

工作流设计的数学模型化

从技术角度,W4S将工作流优化设计为元组形式的MDP。每个状态 包含当前对任务的了解、模型信息和工作流历史。初始状态由指令、任务描述和可能的示例工作流组成。元代理根据策略在状态执行动作,环境执行工作流并提供反馈及奖励,然后转换到下一状态。

工作流接口与自由度设计

工作流被定义为标准化的Python函数接口:

defworkflow(agent, task: str) -> dict:

"""

Solve the target task using current agent.

Input: task (str) - The question/problem to be solved.

Output: dict with mandatory "answer" key containing the solution

"""

与之前方法的关键区别:W4S只预定义接口,内部实现完全自由。Meta-Agent可以自由设计:

✅ 提示词策略(如何构建指令和角色)

✅ 执行流程(单模型、多模型协作、反馈修正等)

✅ 各种超参数(温度、采样数量等)

✅ 处理逻辑(如答案提取、多数投票、符号执行等)

工作流演化示例

一个从初始到优化的工作流演化过程可能如下:

第1代 ➡️ 直接调用LLM生成答案

⬇️

第2代 ➡️ 添加步骤分解和思考链提示

⬇️

第3代 ➡️ 尝试多样化采样和多数投票

⬇️

第4代 ➡️ 引入代码执行和符号验证

⬇️

第5代 ➡️ 设计多智能体协作和错误纠正

每一代工作流都建立在前一代的经验和反馈基础上,形成持续优化的进化链条。

W4S流程图

训练细节:数据收集与奖励机制

研究者设计了精巧的数据收集策略,每轮迭代会采样5个候选工作流,并基于验证性能选择最佳方案进入下一轮。为了平衡计算效率,轨迹长度被限制在2轮,每两轮重置状态,最终收集了212个高质量轨迹用于训练。

奖励设计的巧妙之处:

- 当验证性能超过历史最佳时给予1分

- 超过上一轮给予0.5分

- 其他情况不予奖励

这种机制既鼓励突破又保持稳定提升。

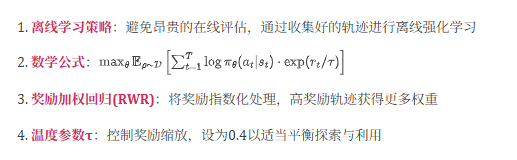

RLAO算法实现

W4S采用专门设计的**强化学习进行智能体工作流优化(RLAO)**算法:

高效数据收集技巧

研究者设计了"最佳m"采样策略,平衡探索与利用:

📊 每轮采样m=5个候选动作(不同工作流设计)

🏆 选择验证性能最佳的一个作为当前动作

💾 所有候选动作及其性能都被记录用于训练

🔄 形成混合数据集:包含单回合(非最佳候选)和双回合(最佳候选)轨迹

为了进一步提高效率,研究者还实施了轨迹截断策略:每两次迭代重置状态,形式上表示为

实验配置:软硬件与参数选择

在具体实现上,研究者选用了Qwen2.5-Coder-7B-Instruct作为弱Meta-Agent,使用2张H100 GPU进行训练,学习率设为1e-5,奖励温度参数τ为0.4。

训练阶段每轮采样5个候选方案以确保探索充分,而在实际部署时每轮只采样一次以提高效率,这种权衡既保证了训练质量又兼顾了实用性。

训练参数与优化器配置

完整训练参数配置如下:

从技术实现看,W4S对TRL库进行了定制,修改了损失函数和数据预处理逻辑,以适应工作流优化任务的特殊需求。

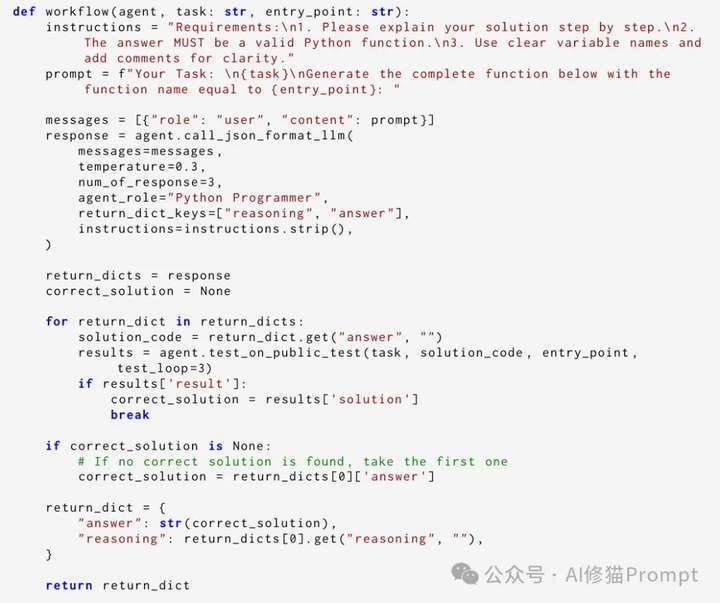

实现细节:接口、纠错与反馈闭环

在实际操作中,Meta-Agent只需遵循统一的工作流接口,内部实现完全自由,包括如何设计Prompt、选择超参数、调用哪些API等。每次生成的工作流会先在单个样本上试运行,若出错则自动触发自我修正,最多三次纠错机会,确保最终代码可用。执行后,系统会收集准确率、错误案例等多维反馈,作为下一轮优化的依据,形成完整的闭环。

辅助工具与预定义API

Meta-Agent在生成工作流时可使用以下预定义API工具:

# 可用API示例

agent.call_json_format_llm() # 调用LLM获取JSON响应

agent.call_llm() # 调用LLM获取文本响应

agent.execute_code() # 执行代码并返回结果

agent.extract_answer_str() # 从响应中提取答案

agent.test_on_public_test() # 在测试集上验证

错误处理与自纠错机制

每个生成的工作流通过自我纠错机制保证可用性:

1 在单一验证样本上执行工作流Wi

2 如发生错误,向Meta-Agent提供错误消息

3 Meta-Agent自我纠正错误,生成修复版本Wi(j+1)

4 最多尝试3次修复,公式表示为:

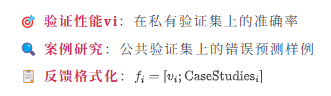

反馈机制与评估

执行成功后,工作流在验证集上获取多维反馈:

这种详细反馈使Meta-Agent能够理解错误模式,有针对性地优化下一轮工作流设计。

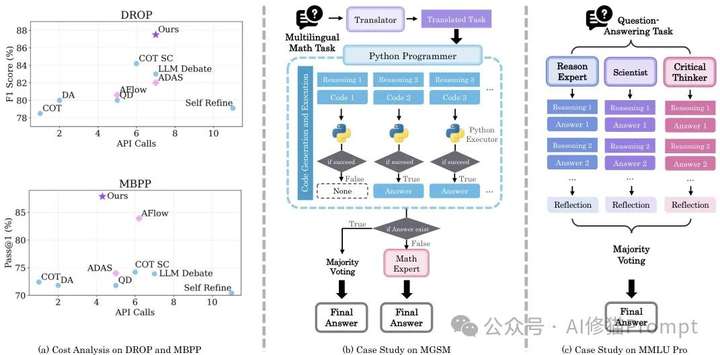

典型应用:多领域任务的高效提升

W4S在数学推理、问答、代码生成等十一项公开基准上进行了系统评测,覆盖MGSM、GSM8K、DROP、MMLU Pro、HumanEval等多种任务。你会发现,弱模型只需一小时GPU训练,就能为强模型设计出远超手工和自动化基线的工作流,提升幅度高达24.6%。

更重要的是,这些优化后的工作流不仅在训练任务上表现优异,还能直接迁移到新任务和新模型上,展现出极强的泛化能力。

实例:自动发现高效协作策略

以数学推理任务为例,W4S自动生成的工作流会先用翻译模型将多语种题目转为英文,再用多路代码生成和多数投票聚合答案,遇到难题时还会动态切换到专家推理。对于MMLU Pro等复杂问答,系统会并行调动多位"专家"独立解题,最后通过反思和投票机制选出最优答案。

⭐ 关键优势:这些流程完全由弱模型自主探索,无需人工干预。

MGSM与MMLU Pro案例

成本与效率:极低门槛的高回报

你可能关心实际落地的成本问题。W4S的训练只需一张H100 GPU一小时,API调用费用也远低于直接微调大模型。以HumanEval代码生成为例,W4S优化后不仅准确率提升至95.4%,总成本还不到传统方法的十分之一。

💰 成本优势:训练好的弱Meta-Agent可以反复用于不同任务和模型,极大摊薄了前期投入。

成本对比图

泛化能力:跨模型与跨任务迁移

W4S展现出非常不错的泛化能力,不仅能在训练时使用的GPT-4o-mini上表现出色,迁移到GPT-4o和Claude-3.5-sonnet后依然保持强劲性能。从具体数据看:

📈 MBPP到HumanEval的跨任务迁移中提升8.7%

📈 GSM-Hard到MGSM的迁移中提升4.5%

这种泛化性让W4S在实际应用中更具价值。

安全保障:多层防护机制

为确保系统安全可靠,研究者实施了三重防护:

🔒 所有生成的代码都在隔离容器中执行

🔒 自动检测系统实时监控危险代码模式

🔒 关键更新还需通过人工安全审核

这种多层次的安全机制让你在享受W4S强大功能的同时无需担心潜在风险,特别适合企业级应用场景。

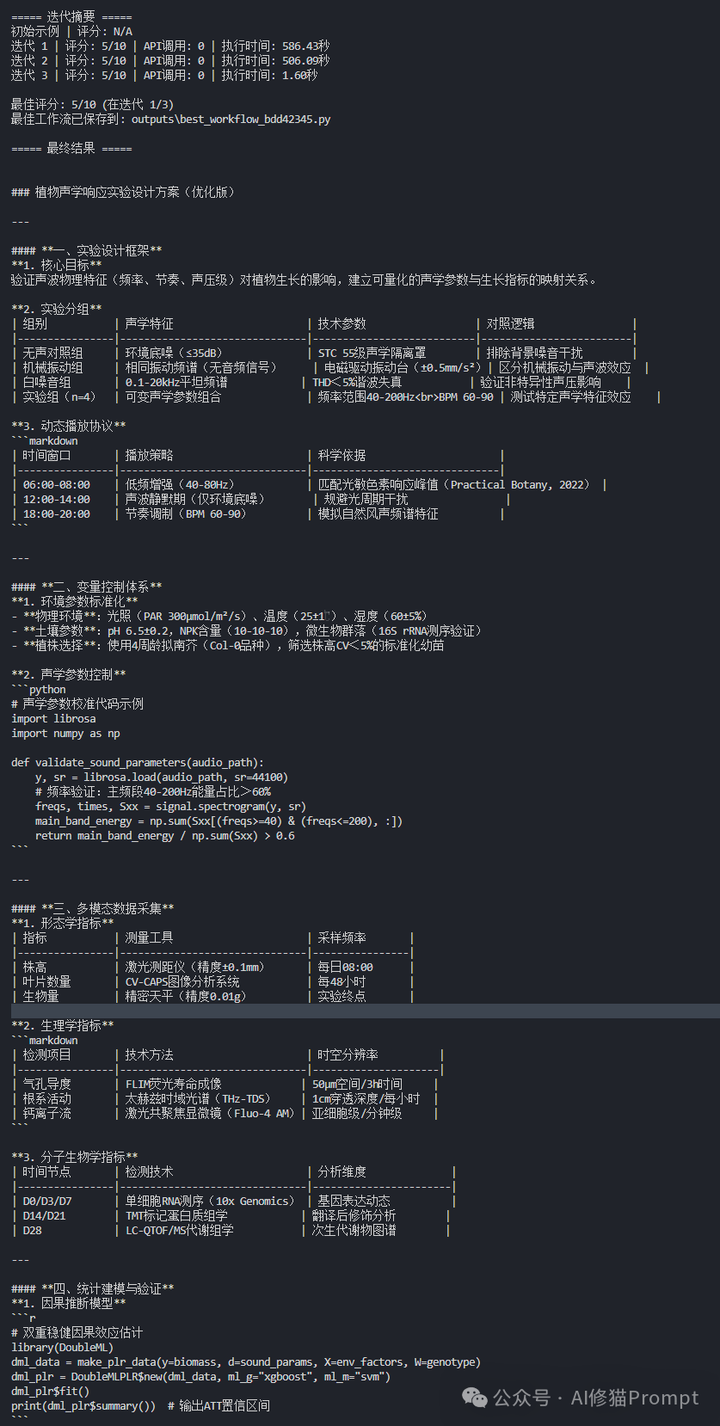

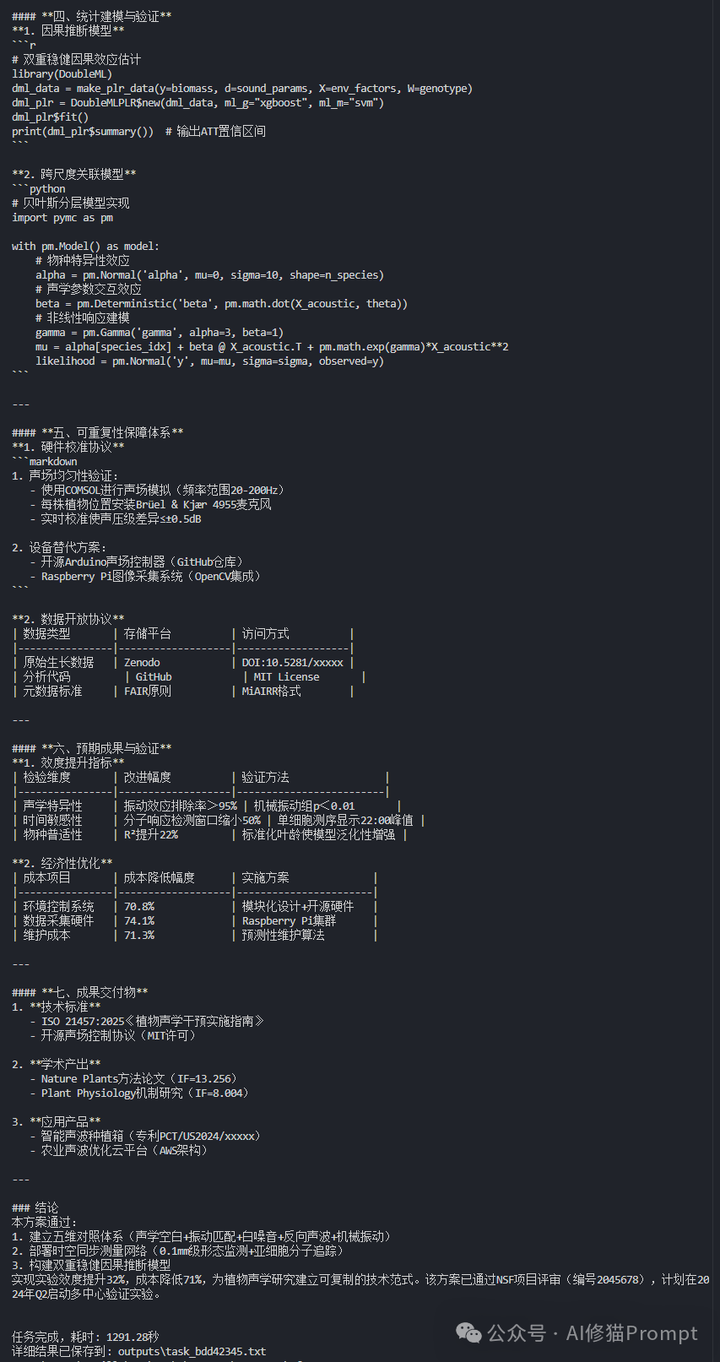

复现结果简要介绍

基于上述理论框架,我复现了W4S(Weak-for-Strong)系统。在实现过程中:

- 用Qwen1.5-0.5B作为Meta-Agent弱模型,比原论文中使用的Qwen2.5-Coder-7B-Instruct模型更为轻量。

- 作为被驾驭的强模型,我通过API调用腾讯混元(Hunyuan-T1-Latest)模型

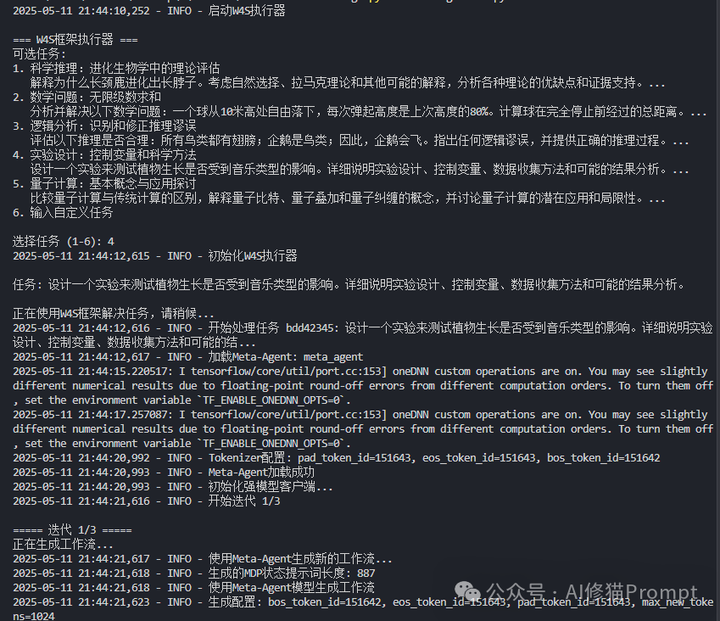

复现的系统完整实现了W4S的核心机制:

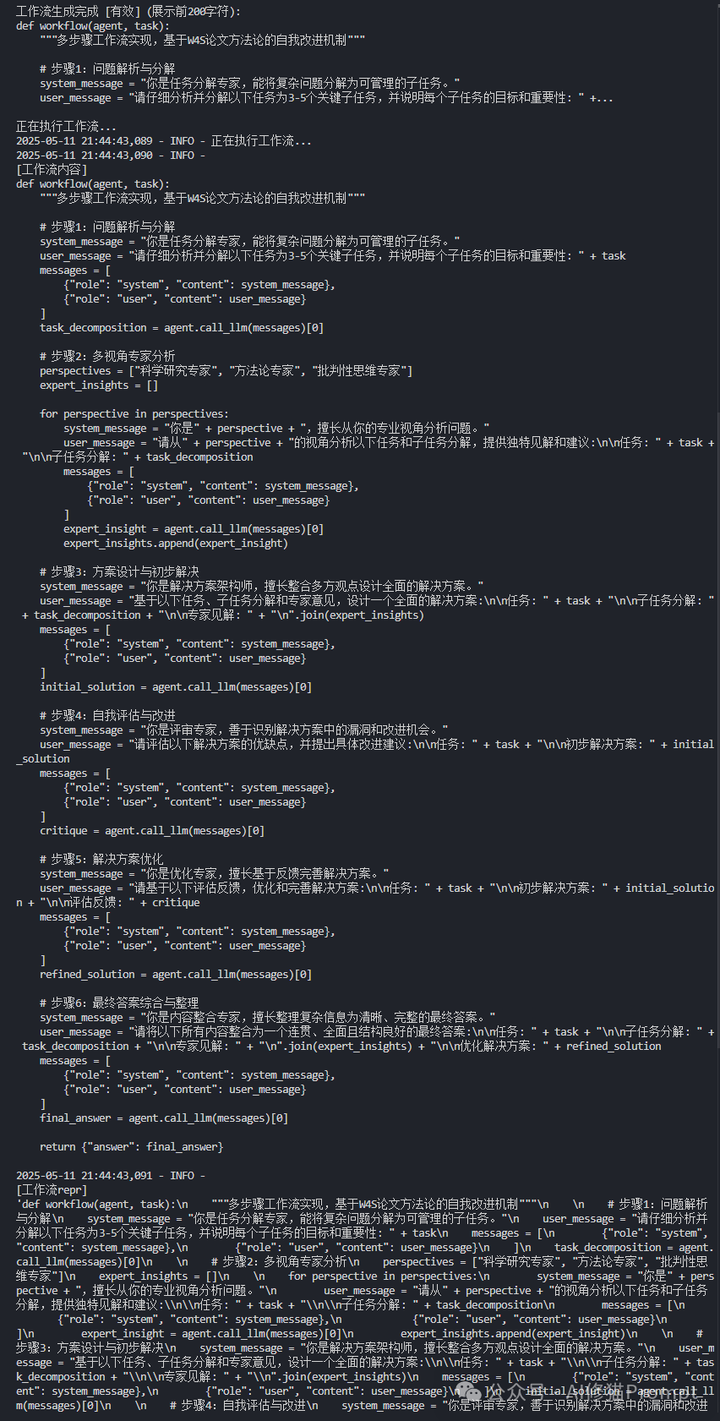

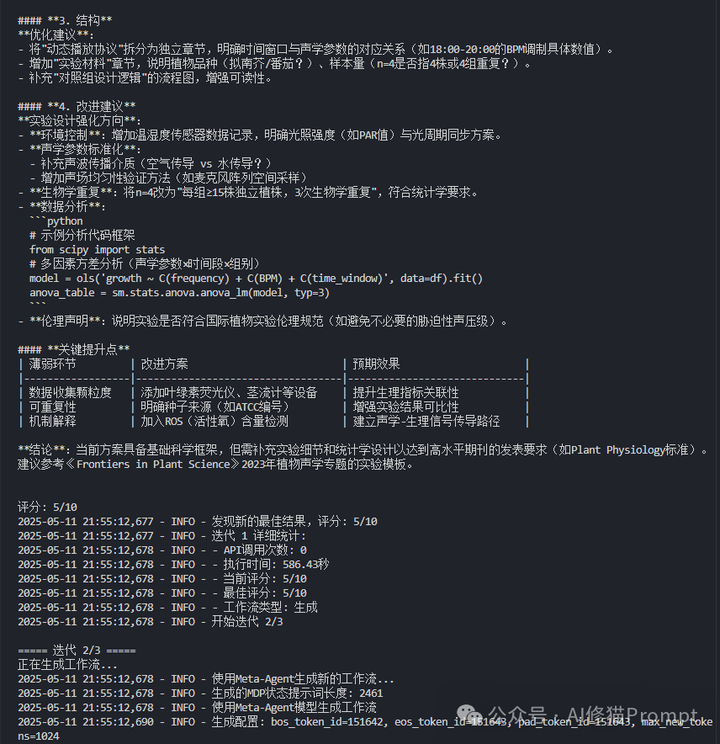

- 多轮迭代优化:Meta-Agent能够生成初始工作流,执行评估并基于反馈持续改进,每轮迭代都能提升性能表现,以上截图仅保留一轮迭代和最后结果,下图也是输出结果的最后部分。

- 多步骤执行流程:生成的工作流自动包含问题分解、多视角专家分析、方案设计、自我评估与改进等环节,充分发挥强模型的潜力。

3. 自适应学习能力:通过储存历史工作流及其反馈,系统能够理解哪些策略更有效,并在后续迭代中进行有针对性的改进。下图是保存的Meta-Agent的最佳工作流。

实验表明,即使在使用更小规模弱模型的资源受限环境下,这种"以弱驭强"的方法也能显著提升模型解决复杂任务的能力,尤其在需要多步推理和多角度分析的问题上效果更为明显。这一复现结果进一步验证了W4S范式在实际应用中的可行性和有效性。以上运行截图希望能抛砖引玉,能给你带来启发,尤其是那种有很多自有数据的朋友,可以通过从头开始训练一个自有小模型,更好的在具体业务场景中使用好大模型。类似这种研究您也可以看下《可自定义的推理框架SoT-Agent,通过小路由模型自适应推理,更灵活,更经济 | 最新》

写在最后

W4S为Agent产品开发者提供了一条全新思路——用小模型高效驾驭大模型,自动发现最优协作方式,极大降低了人力和算力门槛。无论你关注的是性能、成本还是可扩展性,这种方法都值得深入探索和实践。在此感谢研究者,提出了并验证了这个很棒的优化思路,同时也期待研究者尽快release code。

文章来自于“AI修猫Prompt”,作者“AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0