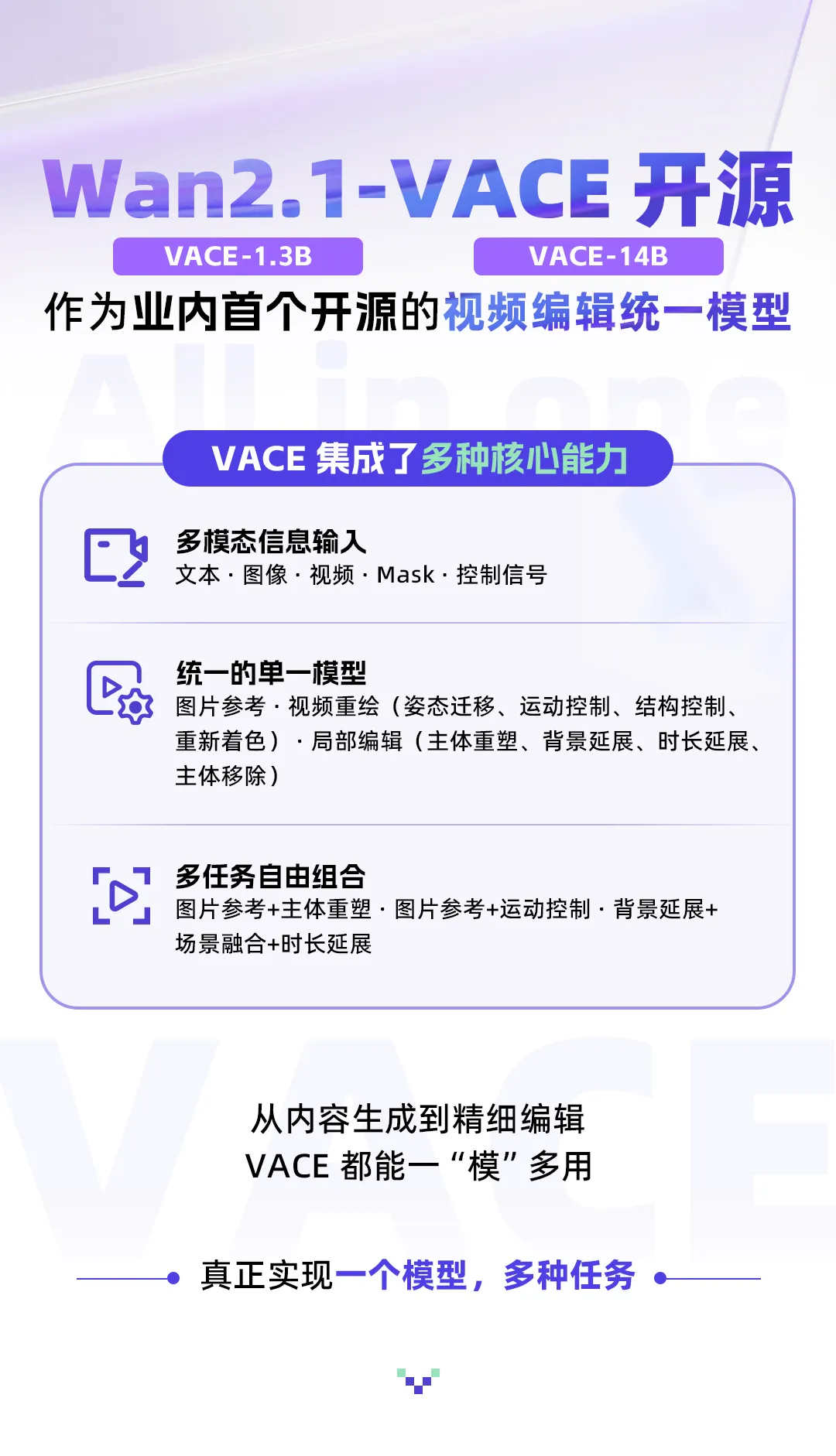

此次开源的 Wan2.1-VACE-1.3B 支持 480P 分辨率,Wan2.1-VACE-14B 支持 480P 和 720P 分辨率。通过 VACE,用户可一站式完成文生视频、图像参考生成、局部编辑与视频扩展等多种任务,无需频繁切换模型或工具,真正实现高效、灵活的视频创作体验。

三大核心能力解析

多模态信息输入,让视频生成更可控

传统视频生成流程,一旦生成完成,想要调整人物姿态、动作轨迹或场景布局非常困难。VACE 提供了强大的可控重绘能力,支持基于人体姿态、运动光流、结构保持、空间运动、着色等控制生成,同时也支持基于主体和背景参考的视频生成。

背后的核心技术是 VACE 的多模态输入机制,不同于仅依赖文本提示的传统模型,VACE 构建了一个集文本、图像、视频、Mask 和控制信号于一体的统一输入系统。

对于图像输入,VACE 可支持物体参考图或视频帧;对于视频输入,用户可以通过抹除、局部扩展等操作,使用 VACE 重新生成;对于局部区域,用户可以通过0/1二值信号来指定编辑区域;对于控制信号,VACE支持深度图、光流、布局、灰度、线稿和姿态等。

统一的单一模型,一站式解决多任务需求

VACE 支持对视频中指定区域进行内容替换、增加或删除等操作。在时间维度上,VACE 可根据任意片段或首尾帧补全整个视频时长;在空间维度上,支持对画面边缘或背景区域进行扩展生成,如背景替换 ——在保留主体不变的前提下,依据 Prompt 更换背景环境。

得益于强大的多模态输入模块和 Wan2.1 的生成能力,传统专家模型能实现的功能 VACE 可以轻松驾驭,包括:

- 图像参考能力,给定参考主体和背景,可以完成元素一致性生成

- 视频重绘能力,包括姿态迁移、运动控制、结构控制、重新着色等

- 局部编辑能力,包括主体重塑、主体移除、背景延展、时长延展等

多任务自由组合,释放AI创意边界

VACE 还支持多种单任务能力的自由组合,打破了传统专家模型各自为战的协作瓶颈。作为统一模型,它能够自然融合文生视频、姿态控制、背景替换、局部编辑等原子能力,无需为单一功能单独训练新模型。

这种灵活的组合机制,不仅大幅简化创作流程,也极大拓展了 AI 视频生成的创意边界,例如:

- 组合图片参考 + 主体重塑功能 → 视频中物体替换

- 组合运动控制 + 首帧参考功能 → 静态图片的姿态控制

- 组合图片参考 + 首帧参考 + 背景扩展 + 时长延展 → 将竖版图拓展为横屏视频,并且在其中加入参考图片中的元素

模型设计亮点解读

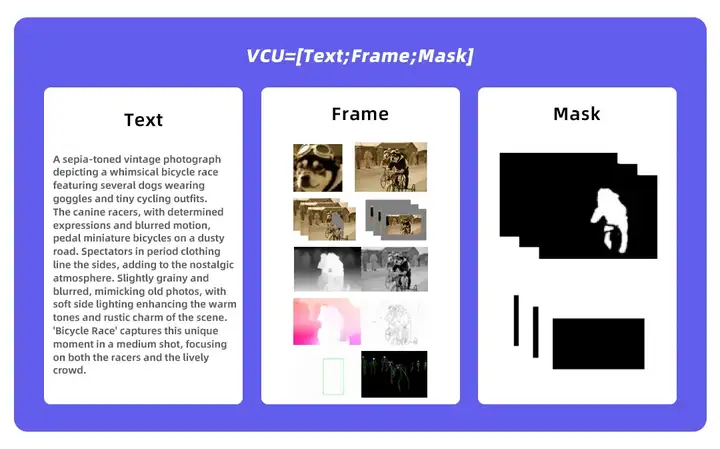

VCU-更灵活统一的输入范式

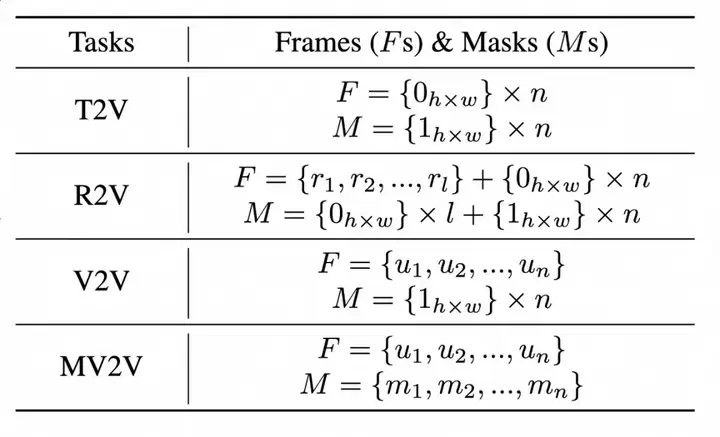

我们通过对四类常见任务(文生视频、图生视频、视频生视频、局部视频生视频)的输入形态进行分析和总结,提出了一个灵活统一的输入范式:视频条件单元 VCU。

它将多模态的各类上下文输入,总结成了文本、帧序列、mask 序列三大形态,在输入形式上统一了 4 类视频生成与编辑任务的统一。VCU 的帧序列和 Mask 序列在数学上可以相互叠加,为多任务的自由组合创造条件。

多模态Token序列化,统一建模的关键

如何将多模态输入统一编码为扩散 Transformer 可处理的 token 序列?这是 VACE 需要解决的一大难题。

首先,VACE 对 VCU 输入中的 Frame 序列进行概念解耦,将其分为两类:一类是需要原封不动保留的 RGB 像素(不变帧序列),另一类是需要根据提示重新生成的内容(可变帧序列)。接下来,分别对这三类输入(可变帧、不变帧、Mask)进行隐空间编码,其中,可变帧和不变帧通过 VAE 被编码到与 DiT 模型噪声维度一致的空间,通道数为 16;而 mask 序列则通过变形和采样操作,被映射到时空维度一致、通道数为 64 的隐空间特征。

最后,将 Frame 序列和 mask 序列的隐空间特征合一,并通过可训练参数映射为 DiT 的 token 序列。

上下文适配器微调,高效训练策略

在训练策略上,我们对比了全局微调与上下文适配器微调两种方案。全局微调通过训练全部 DiT 参数,能取得更快的推理速度;而上下文适配微调方案是固定原始的基模型参数,仅选择性地复制并训练一些原始 Transformer 层作为额外的适配器。

实验表明,两者在验证损失上差异不大,但上下文适配器微调具有更快的收敛速度,且避免了基础能力丢失的风险。因此,本次开源版本采用该方法进行训练。

通过本次发布的 VACE 系列模型定量评测可以看出,相比 1.3B preview 版本,模型在多个关键指标上均有明显提升。

开源与使用指南

如果想要基于 VACE 进行二次开发,可以遵循以下步骤进行使用,首先从 GitHub 下载 Wan2.1 的官方repo,再进入 HuggingFace 或 ModelScope 下载对应的 VACE 模型,在 Wan 的主站也即将支持 VACE 的部分功能。

✅ GitHub:https://github.com/Wan-Video/Wan2.1

✅ 魔搭:https://modelscope.cn/organization/Wan-AI

✅ Hugging Face:https://huggingface.co/Wan-AI

✅ 国内站:https://tongyi.aliyun.com/wanxiang/

✅ 国际站:https://wan.video

文章来自微信公众号 “ 通义大模型 ”,作者 开源

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0