强化学习(RL)+真实搜索引擎,可以有效提升大模型检索-推理能力。

但问题来了:

一方面,搜索引擎返回的文档质量难以预测,给训练过程带来了噪音和不稳定性。

另一方面,RL训练需要频繁部署,会产生大量API开销,严重限制可扩展性。

现在,来自阿里通义实验室的解决方案公开了:开源ZeroSearch,提供了一种无需与真实搜索引擎交互的强化学习框架。

实验表明,ZeroSearch仅需3B参数的LLM作为检索模块,即可有效提升搜索能力,节省了高昂API成本。

ZeroSearch让LLM“自给自足”实现搜索进化

研究团队用模拟搜索环境+渐进式抗噪训练,让LLM不再依赖昂贵搜索引擎API。

轻量微调:把LLM变成“搜索引擎模拟器”

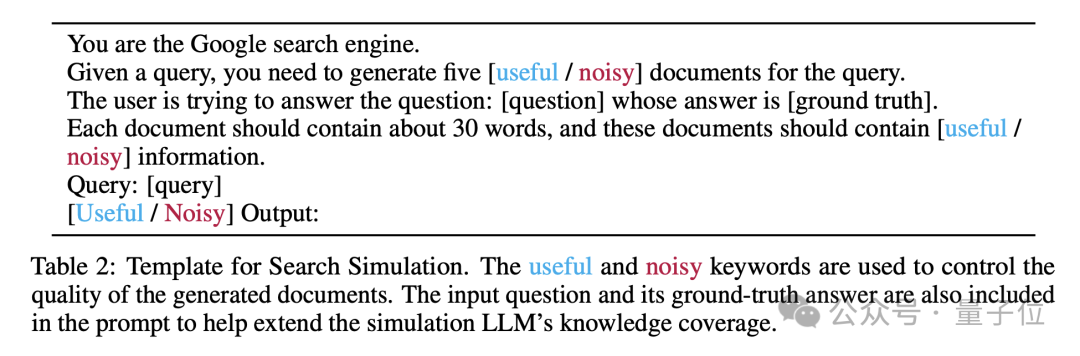

用少量标注数据微调LLM,使其能按指令生成两种文档——有用结果和噪声干扰。

通过收集与真实搜索引擎交互的数据,ZeroSearch对LLM进行轻量级监督微调。

在这个过程中,模型学会生成与真实搜索引擎风格相似的文档,同时能够根据提示词生成相关或噪声文档。

这种能力使得模型在训练过程中能够动态调整文档质量,从而更好地模拟真实检索场景。

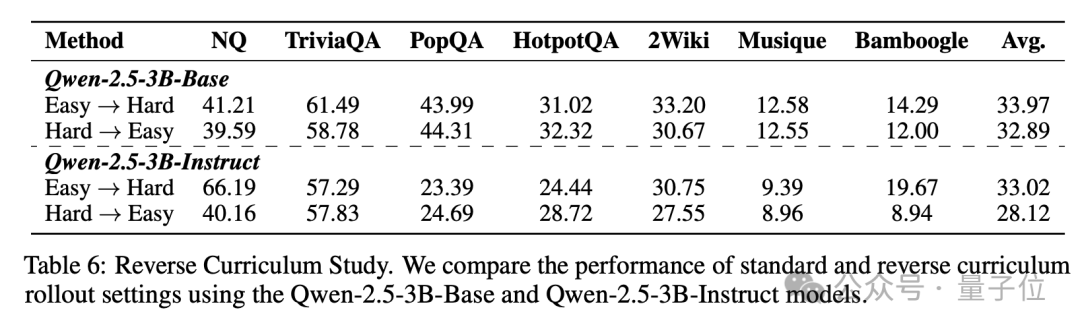

课程化抗噪训练:像打游戏升级一样练模型

训练初期返回高质文档,后期逐渐混入噪声(噪声比例按指数曲线上升)。

ZeroSearch引入了课程式学习机制,逐步降低生成文档的质量,使模型从简单的检索场景逐步过渡到更具挑战性的任务。

这种策略不仅提升了模型的推理能力,还显著增强了训练的稳定性和效果。

随着训练的进行,模型逐渐适应更复杂的检索任务,最终能够在高质量和低质量文档中找到平衡。

强化学习闭环:自产自销的搜索生态

ZeroSearch通过模拟搜索引擎,完全消除了与真实搜索引擎交互的API费用,使得大规模强化学习训练变得更加经济可行。

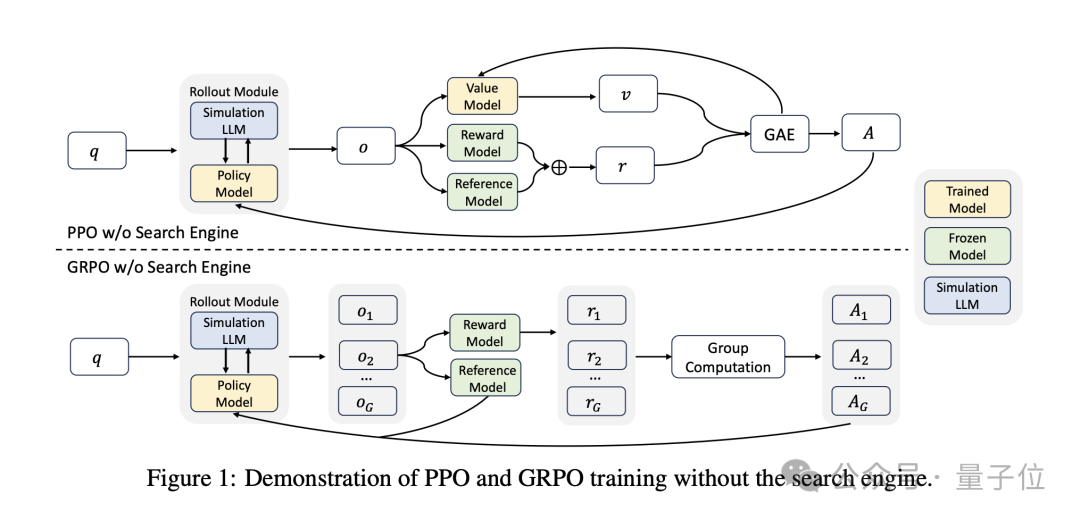

并且,ZeroSearch兼容多种强化学习算法,包括PPO(Proximal Policy Optimization)和GRPO(Group Relative Policy Optimization)。

这些算法为模型提供了不同的优化策略,使得ZeroSearch能够在不同的模型和任务中表现出色。

实验表明,GRPO在训练稳定性方面表现更好,而PPO则在某些任务中提供了更高的灵活性。

实验结果及结论

ZeroSearch的零API成本优势不仅体现在经济上,还体现在训练的灵活性和可扩展性上。

ZeroSearch vs. 现有方法

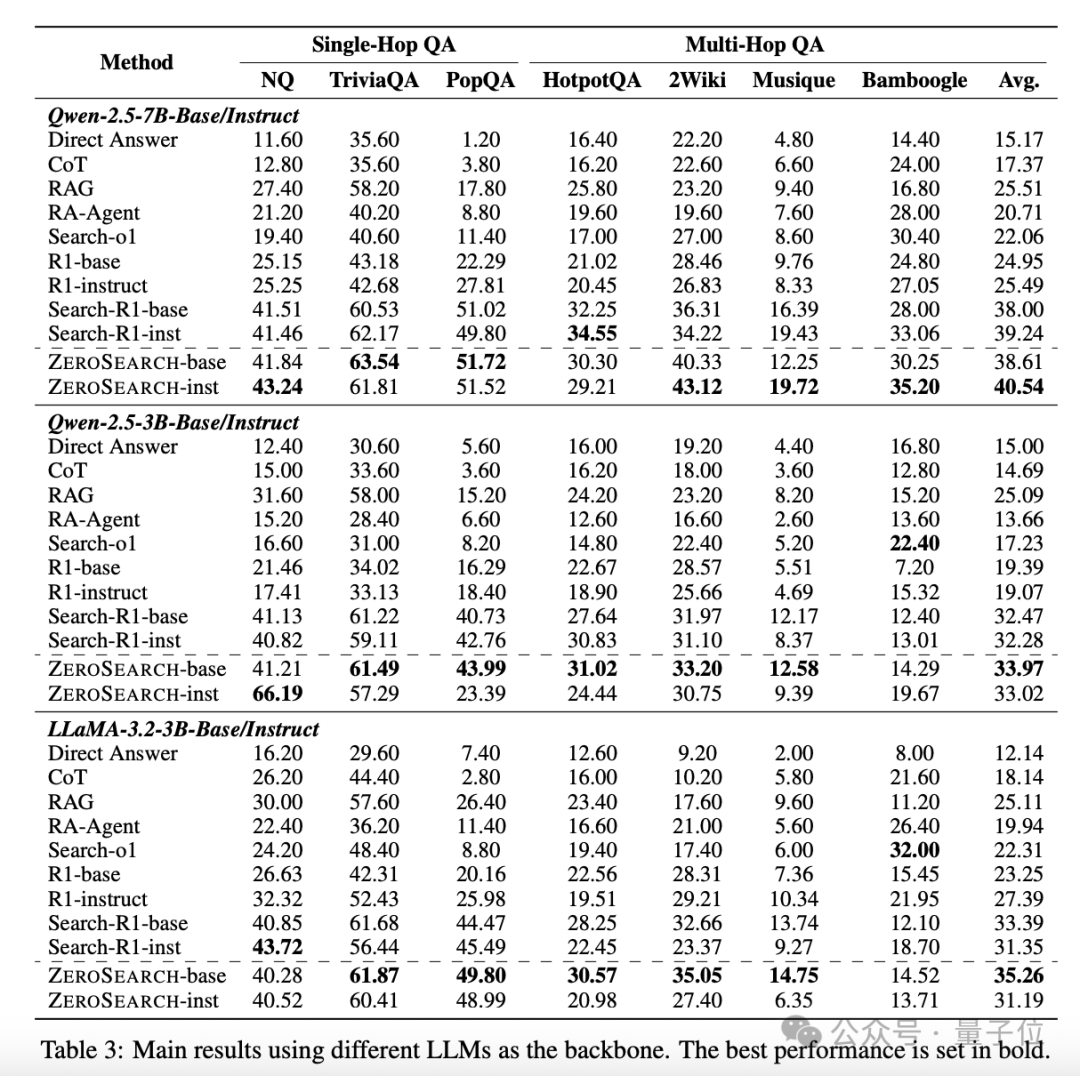

在图中,我们可以清晰地看到ZeroSearch在多个问答数据集上的表现。

无论是单跳(Single-Hop)还是多跳(Multi-Hop)问答任务,ZeroSearch都显著优于现有的基线方法,包括直接提示、RAG和Search-R1等。

这表明ZeroSearch不仅在简单任务中表现出色,还能在复杂的多跳问答任务中发挥强大的检索能力。

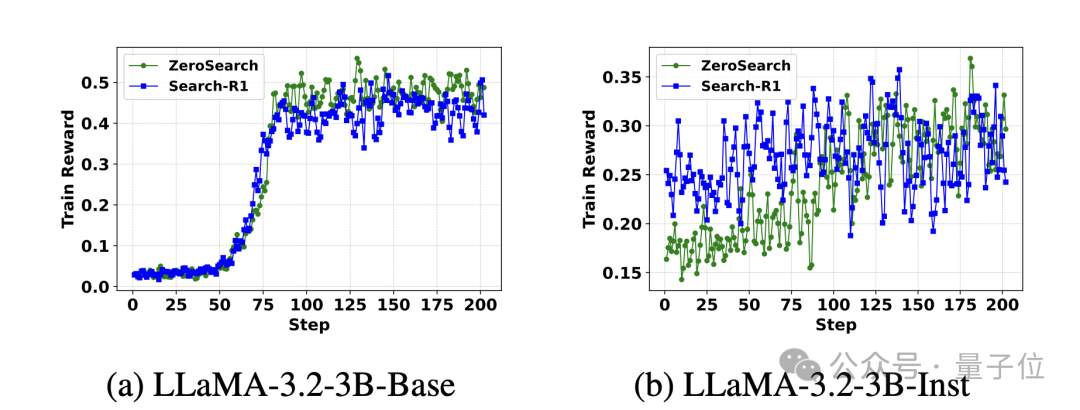

上图展示了ZeroSearch和Search-R1(使用真实搜索引擎)在LLaMA-3.2-3B模型上的奖励曲线对比。

ZeroSearch的学习曲线更加平滑且最终性能优于Search-R1,表明其在训练过程中的稳定性和优越性。

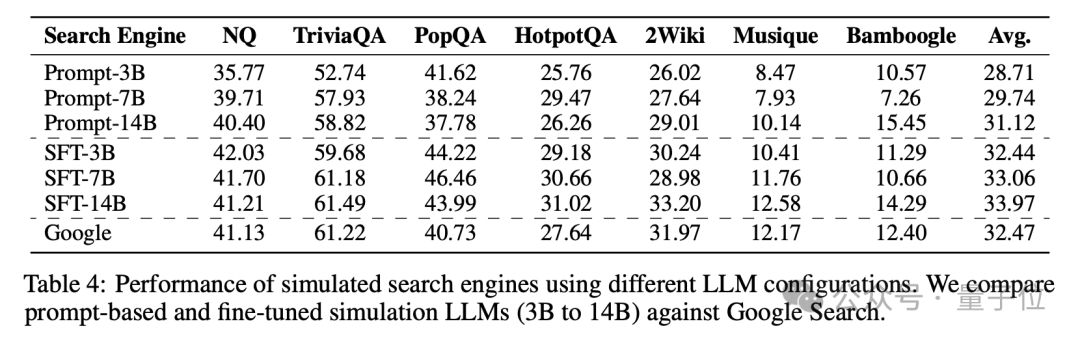

不同模型规模的性能

可以看到使用7B参数的检索模块就能达到与谷歌搜索相当的性能,而14B参数的检索模块甚至能够超越谷歌搜索。

这表明ZeroSearch不仅适用于小型模型,还能在大型模型中发挥更大的潜力,为LLM的检索能力提升提供了广阔的空间。

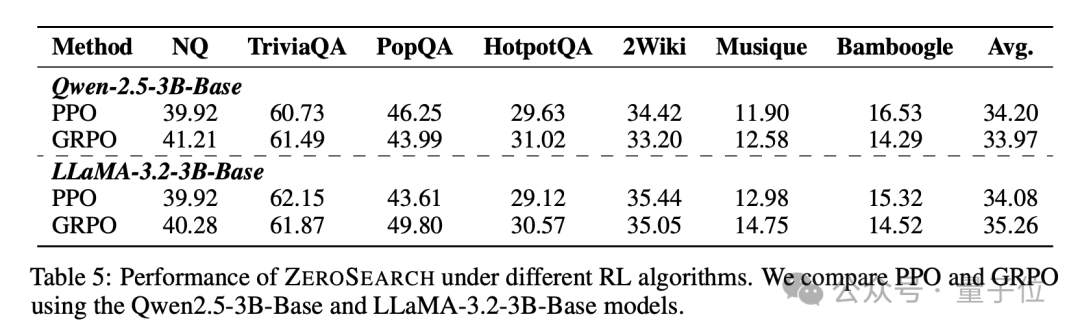

强化学习算法的兼容性

比较了在Qwen-2.5-3B和LLaMA-3.2-3B模型上,使用PPO和GRPO算法的ZeroSearch性能,可以看到ZeroSearch与PPO和GRPO两种强化学习算法的兼容性。

实验结果表明,GRPO在训练稳定性方面表现更好,而PPO则在某些任务中提供了更高的灵活性。

这表明ZeroSearch能够适应不同的强化学习算法,为研究人员提供了更多的选择。

通过模拟搜索引擎,ZeroSearch完全消除了API成本,同时通过课程式学习策略逐步提升模型的推理能力。

论文第一作者孙浩目前是北京大学智能学院四年级博士研究生,研究方向聚焦于检索增强的大语言模型与智能体,师从张岩教授。

论文链接:

https://arxiv.org/abs/2505.04588

项目主页: https://alibaba-nlp.github.io/ZeroSearch

文章来自于微信公众号 “量子位”,作者 :闻乐

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0