AI越来越聪明,但如果它们反应慢,效率低,也难以满足我们的需求。

大语言模型(LLM)驱动的搜索智能体,通过动态拆解问题、交错执行“思考”(推理)和“查找”(检索)来解决复杂任务,展现了惊人能力。

然而,这种深度交互的背后,也隐藏着显著的效率痛点。

处理复杂任务时,查得慢、查得不准,都会拖慢整个流程。

来自南开大学和伊利诺伊大学厄巴纳-香槟分校的研究人员深入剖析了这些效率瓶颈,并提出了一套名为SearchAgent-X的高效推理框架。

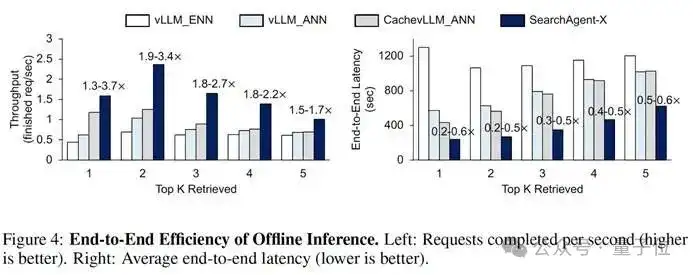

实践表明,SearchAgent-X实现了1.3至3.4倍的吞吐量提升,延迟降至原来的1/1.7至1/5,同时不牺牲最终的答案质量。

解析搜索智能体中的两大效率瓶颈因素

研究者发现,看似简单的检索环节,隐藏着两大关键的效率制约因素:

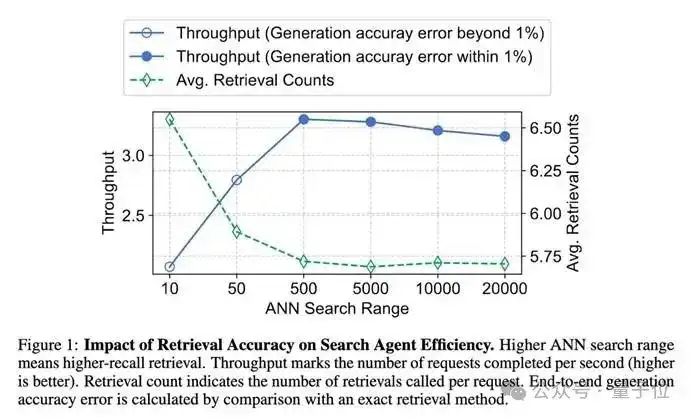

检索精度:并非“越高越好”的微妙平衡

直觉上,检索越准,LLM获取信息质量越高,效率也应该越高。但实际情况是非单调关系:

- 过低精度LLM需更多轮检索和推理弥补,总时间增加。

- 过高精度检索本身计算资源消耗巨大,拖慢整体速度。

研究表明,系统吞吐量随近似检索精度先升后降。当搜索范围超过最佳点,检索成本反噬整体效率。

核心洞察:搜索智能体更青睐高召回率的近似搜索,有效支撑推理,避免不必要开销。

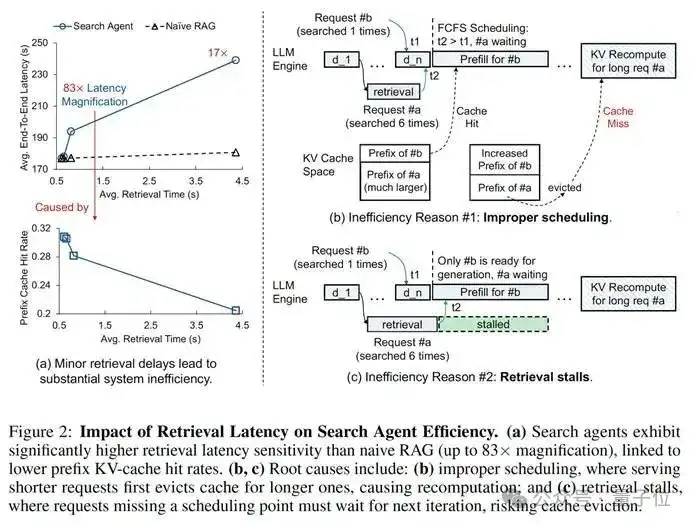

检索延迟:“差之毫厘”引发的“千里之堤”效应

与传统RAG不同,搜索智能体对检索延迟极为敏感。即使微小增加,也可能导致端到端延迟急剧放大(高达83倍)。这与KV-cache命中率骤降密切相关,迫使系统频繁重计算。主要原因:

不当调度(Improper Scheduling):

- 现象:标准“先来先服务”可能让短任务抢占长任务计算资源。

- 恶果:长任务宝贵KV-cache被“挤掉”,恢复执行时不得不重算。数据显示,高达55.9%的token被不必要重计算。

检索停滞(Retrieval Stalls):

- 现象:异步检索和生成可能时间错位。长任务检索结果在下一轮生成“窗口期”之后返回。

- 恶果:任务错过当前调度批次被迫等待,KV-cache可能被挤占。平均而言,超过25%的序列在完成检索后会经历此类停滞。

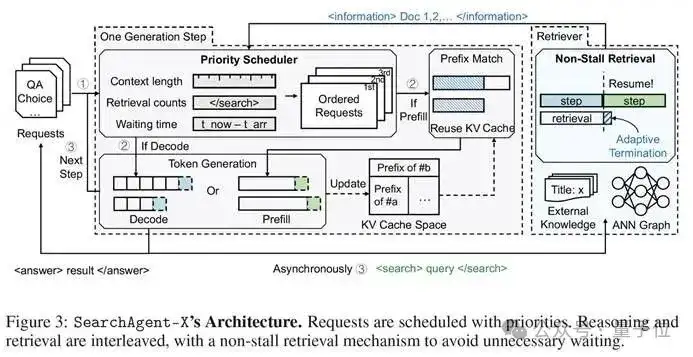

SearchAgent-X的两大“加速引擎”

基于上述洞察,SearchAgent-X通过智能调度与自适应检索,最大限度减少延迟,最大化GPU资源利用率,尤其提升KV-cache的有效利用。

利器一:优先级感知调度 (Priority-Aware Scheduling)

解决不当调度问题,SearchAgent-X引入优先级调度,动态排序并发请求。

调度依据:综合考虑:

- 已完成的检索次数:检索越多,计算成果越多,缓存复用价值越大。

- 当前序列的上下文长度:指向更长、可复用的缓存。

- 请求的等待时间:确保公平。

核心理念:“让最有价值的计算优先”,减少无谓等待与重复劳动。

利器二:无停顿检索 (Non-Stall Retrieval)

缓解检索停滞,SearchAgent-X实现灵活、非阻塞式检索提前终止策略。

执行逻辑:自适应判断是否“见好就收”,依据:

- 检索结果的成熟度:新信息带来的质量提升甚微时,认为结果已足够好。

- LLM引擎的就绪状态:判断LLM是否准备好下一轮计算。

核心理念:当检索结果足够成熟且LLM引擎就绪时,SearchAgent-X停止检索。这种机制是恰到好处的“放手”,保证信息质量同时,让生成过程无需不必要的等待。

实战检验:效率与质量双丰收

研究者在Qwen-7B/14B等模型上,对SearchAgent-X与多种基线系统进行了全面对比。

端到端性能:吞吐与延迟的显著优化

- 离线推理 (所有请求一次性到达):在Musique数据集上,SearchAgent-X的吞吐量比基线系统高出1.3至3.4倍,平均延迟降低至基线系统的20%至60%。

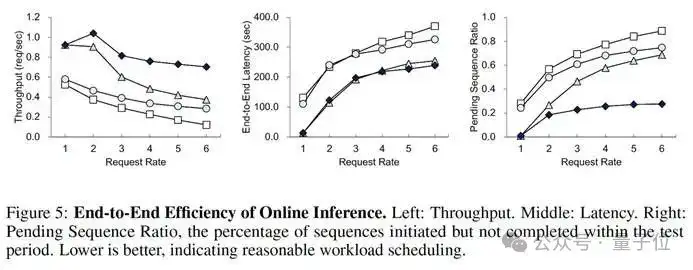

- 在线推理(请求持续到达):SearchAgent-X 完成的请求数量比基线系统多**1.5至3.5 倍。请求速率越高,其优势越明显,最多时是某些基线的5.8倍。

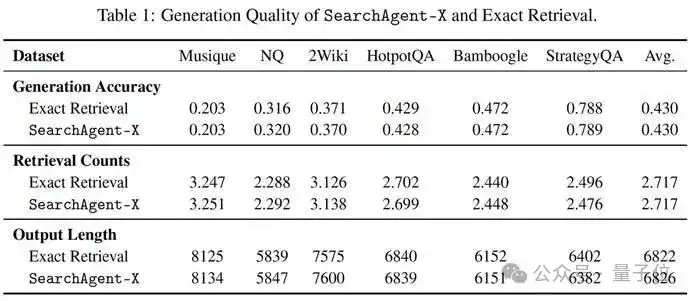

生成质量:效率提升,效果不打折

在Musique, NQ, HotpotQA等六个代表性数据集上的评估表明,SearchAgent-X在生成准确率上,与采用精确检索的基线系统表现相当。

有趣的是,在某些数据集上,由于近似检索带来的轻微扰动促使模型进行额外推理,其准确率甚至略有提升。

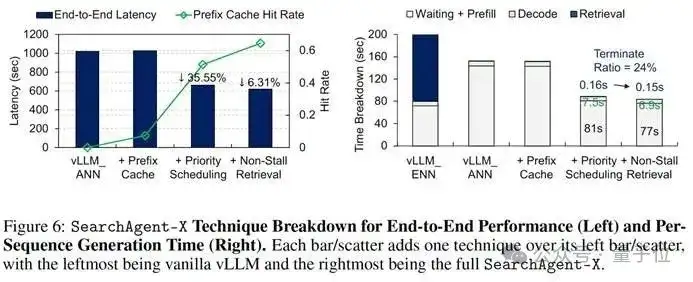

技术拆解:每一项优化都“功不可没”

消融实验揭示各组件贡献:

- 优先级调度在引入缓存基础上,将端到端延迟降低35.55%,KV-cache命中率从0.07提升至0.51。

- 无停顿检索在前两者基础上,进一步将KV-cache命中率提升至0.65。它平均仅使检索时间减少0.01秒,却显著降低端到端延迟,印证了“差之毫厘的等待,影响深远”。

总结与展望

未来的AI要解决更宏大、更开放的问题,必然需要更频繁地与外部工具和知识库交互,而这恰恰是效率瓶颈所在。

SearchAgent-X揭示了:

- 平衡之殇在AI智能体中,任何单一工具(如检索)的性能并非越高越好,需要与智能体的整体工作流相匹配。

- 等待之痛在由多个异步组件构成的复杂AI系统中,微小的延迟和不当的资源调度会被急剧放大,造成雪崩效应。

该研究通过引入优先级感知调度和无停滞检索两项机制,显著提升了搜索型AI智能体的推理效率和响应速度。

实验表明,这些优化在不牺牲答案质量的前提下,有效缓解了深度交互中的延迟与资源浪费问题。相关方法可为包括搜索引擎、企业问答系统在内的多类复杂AI Agent提供实践参考。

论文地址: https://arxiv.org/abs/2505.12065

Github地址: https://github.com/tiannuo-yang/SearchAgent-X

文章来自于“量子位”,作者“SearchAgent-X团队”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/