本文第一作者为上海交通大学计算机学院副教授刘卫文,研究方向为大模型智能体,大语言模型,个性化算法等。

近年来,随着大语言模型的快速发展,基于其构建的大模型智能体(LLM Agents)正逐步从技术演示走向实际应用部署。然而,真正实现规模化应用仍面临诸多瓶颈。使用范围主要集中于专业领域,如代码生成、科研辅助等。在大众、高频、日常的应用场景(如电商、个人助理)中,普及率依然较低。这一现象引发了一个关键问题:

当前制约大模型智能体实际可用性的真正原因是什么?

上海交通大学联合中科大在本文中指出:现阶段大模型智能体的主要障碍不在于模型能力不足,而在于其「Agentic ROI」尚未达到实用化门槛。

- 论文题目:The Real Barrier to LLM Agent Usability is Agentic ROI

- 论文链接:https://arxiv.org/pdf/2505.17767

Agentic ROI:大模型智能体实现规模化应用的关键瓶颈

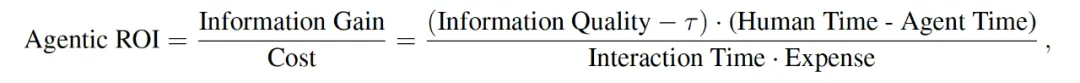

研究团队提出 Agentic ROI(Agentic Return on Investment)这一核心指标,用于衡量一个大模型智能体在真实使用场景中所带来的「信息收益」与其「使用成本」之间的比值:

- Information Quality:指智能体所生成的信息质量,包括准确性、完整性等。

- Quality Threshold:指最低可接受的信息质量阈值(注:根据上下文推断)。

- Human Time和 Agent Time:分别指人类与智能体完成对应任务所需的时间。

- Interaction Time:指用户与智能体交互所需要的时间,如用户进行任务描述、验证结果过程中所消耗的时间。

- Expense:指用户经济成本,如模型调用、API 使用的开销。

只有当信息质量超过一定阈值,且智能体所节省的时间和成本之比足够高时,智能体才真正具备可用性。

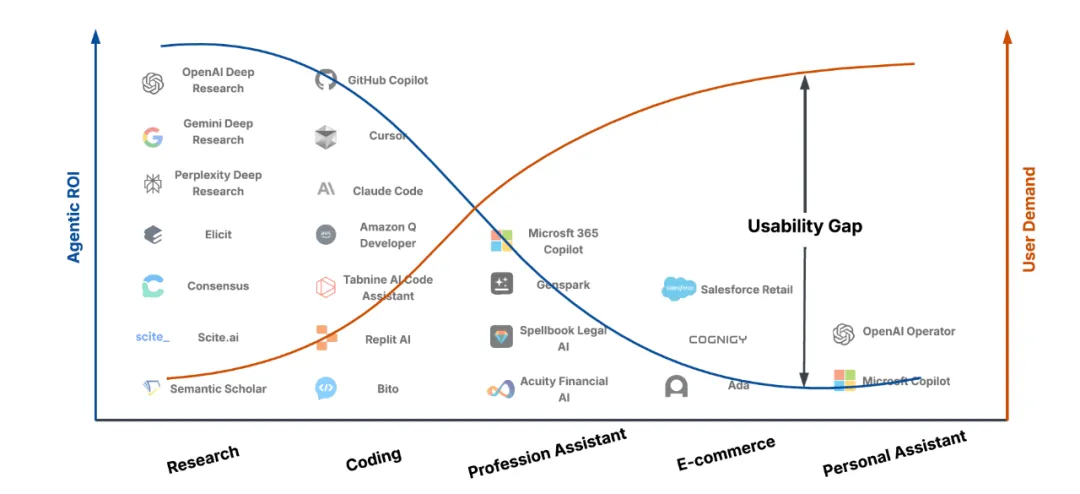

如上图所示,当前大部分 LLM 智能体集中应用于人类任务时间成本高的信息密集型场景(如科研、编程),此类任务本身就需要大量人力投入,因此即便智能体部分替代也能显著提高效率。然而,在用户量庞大的日常场景中(如电商、搜索、助理等),任务本身较为简单,交互成本低(如点击、下滑操作),智能体提升的边际价值不明显,反而可能引入额外的交互成本和延迟,从而导致 Agentic ROI 较低。

因此,当前高用户需求与低 Agentic ROI 之间的矛盾,反映了智能体在日常应用中的实用性不足,需进一步优化信息价值、智能体任务完成时间、及交互时间以填补市场空白。

优化 Agentic ROI 智能体发展的「之字形」轨迹

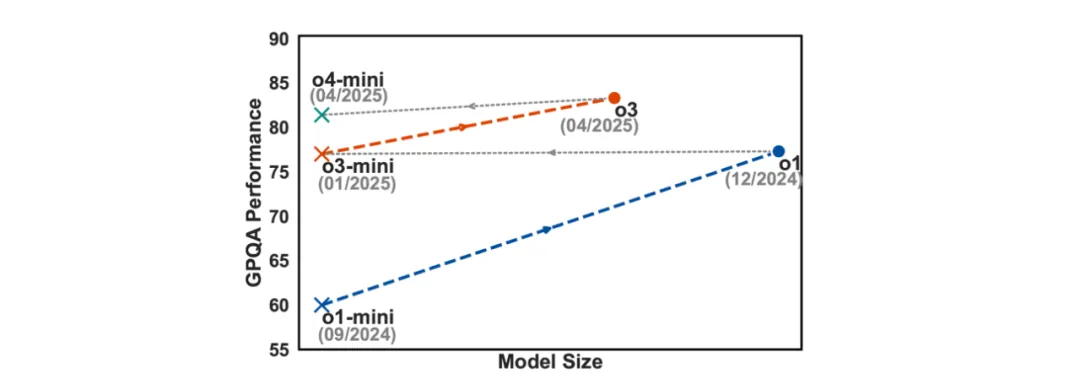

研究团队提出,LLM 智能体的发展路径并非线性增长,而是呈现出一种「先规模化、后轻量化」的「之字形」发展模式:首先规模化(scaling up)参数规模、训练数据、推理能力以提升信息质量;之后在保证信息质量的前提下,轻量化(scaling down)进行模型压缩、蒸馏、推理优化以减少智能体所用时间与调用成本。我们正处于智能体规模化发展的高峰阶段,优先提升信息质量。

基础模型如 OpenAI 系列模型的发展也体现了这一「之字形」发展趋势:同系列模型如 o1-mini 到 o1 模型表现显著增强,而新一代小模型如 o3-mini 则在持平 o1 性能的同时显著降低了推理费用和延迟。

规模化提升信息质量(Scaling Up)

预训练规模化(Pre-training Scaling)

预训练阶段通过扩大模型规模、数据量和计算资源,使智能体在语言理解、推理和世界知识等基础能力方面获得稳步提升。而规模化使用包含任务结构和操作流程的文档数据(如操作手册、工作流程指南)能够帮助模型学习实际任务的分解逻辑和执行顺序。此外,随着上下文窗口的扩展和记忆机制的引入,智能体可以处理更长的交互历史和用户偏好,从而提升多轮任务执行的能力。

后训练规模化(Post-training Scaling)

后训练阶段(如监督微调和强化学习)使智能体更贴近人类的需求与价值观。同时,智能体性能提升还依赖于大规模复杂环境(网页、API 接口)交互轨迹数据,使用外部工具进行操作决策。此外,在真实部署中积累的用户反馈、任务完成记录和错误修复数据,构成了智能体持续学习与演化的基础,形成智能体的数据飞轮,使其在真实使用中不断优化行为。

推理时规模化(Test-time Scaling)

推理时规模化包括:

- 规模化推理步骤(Scaling reasoning process),以应对复杂任务并生成更可靠的输出;

- 规模化多智能体系统(Scaling multi-agent system),通过协作完成任务分解与执行;

- 扩展工具调用(Scaling tool calling),通过多次工具调用使智能体能够逐步验证中间结果;

- 扩展推理时训练(Scaling test-time training),通过利用无标签测试数据实时更新快速适应新任务或用户需求

- 有约束条件下直接优化 Agentic ROI(Scaling towards Agentic ROI under budget constraints),智能体可在给定预算约束(如时间、API 成本)下动态评估每一步操作信息收益,直接整体优化 Agentic ROI。

构建世界模型(Building World Model)

构建真实的「世界模型」对于实现真正规模化数据合成、智能体评估至关重要。世界模型应支持多模态交互(语言、图像、文档、音频),具备处理多步骤、长时程任务的能力,并能模拟用户的多样化偏好与反馈机制。此外,它还应反映现实世界中的不确定性,例如信息不完全、用户意图变化、环境干扰等。

确保鲁棒性与安全性(Ensuring Robustness & Security)

确保智能体行为的稳健性与安全性也是提升信息质量的重要一环。鲁棒性方面,智能体应防止奖励机制被利用,避免出现「奖励黑客」现象;安全性方面,需要防范训练数据污染、防止反馈被篡改和后门攻击等。在运行过程中,智能体应配备异常检测和事实核查能力,确保输出内容的准确性与一致性。同时,构建行为审计机制和可解释性工具,可以提升智能体的可控性和可靠性。

轻量化降低智能体时间与成本(Scaling Down)

减少智能体任务完成时间

引入记忆机制: 引入记忆机制是提高效率的重要手段。具备记忆能力的智能体可以跳过重复计算,直接调用以往任务中积累的知识,从而加快处理速度。这种方式模拟人类专家的行为,依靠经验而非实时推理来完成任务。

模型压缩: 通过模型压缩或蒸馏来减少计算资源和推理延迟,是另一个核心方向。借助模型蒸馏等技术,可以将大模型的能力迁移到更小的模型中,从而在不显著降低性能的前提下,显著缩短响应时间、减少部署成本。

优化推理策略: 智能体的时间消耗不仅来源于计算,还受到推理链条长度的影响。如果推理过程过于复杂或冗余,例如频繁的自我反思、递归规划等,可能会延长任务完成时间而未带来质的提升。因此,更高效的智能体应具备「少而精」的思维能力,能够通过最短路径达成最优解。

基础设施优化: 硬件层面的升级,如 Groq 和 Cerebras 等新型 AI 芯片,以及软件层面的优化,如 vLLM 和 FlashAttention 等推理引擎,都能显著提升模型运行速度。只有软硬件协同进化,才能真正满足低延迟、实时响应的实际需求,从而提升智能体的整体可用性。

降低成本

降低交互时间: 当前的智能体往往要求用户提供冗长、明确的指令,这带来了较高的使用门槛与认知负担。为此,智能体的交互方式应从被动解析输入,转向主动理解用户意图,具备一定程度的目标推理与任务自完成能力。这种转变不仅可以减少用户的操作负担,也有助于提升整体使用体验。此外,产品设计上的新范式也有助于进一步降低用户交互时间。

降低开销: 智能体的运行费用可能因模型规模、推理深度、调用外部工具等因素而迅速上升。尤其在大规模部署或持续运行场景下,成本问题尤为突出。因此,未来的智能体需要更智能地管理上下文,合理控制推理复杂度与工具调用频率,确保在保证性能的前提下,尽可能降低资源消耗与使用开销。

Agentic ROI 提供了一个衡量智能体真实可用性的系统框架,帮助我们超越模型性能的单一维度,转向「实际效益」导向的设计与评价逻辑。智能体的「可用性」不应仅以模型性能定义,而应以综合效益衡量。在实际部署中,Agentic ROI 为我们提供了一个更贴近真实世界的评价维度,帮助我们识别系统中被忽视的「隐藏成本」,并指导我们构建真正高效、可用、可负担的智能体系统。

文章来自微信公众号 “ 机器之心 ”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner