最近AI圈子里有两个特别有意思的项目,一个是谷歌DeepMind的AlphaEvolve,另一个是UBC大学的Darwin Gödel Machine(简称DGM)。

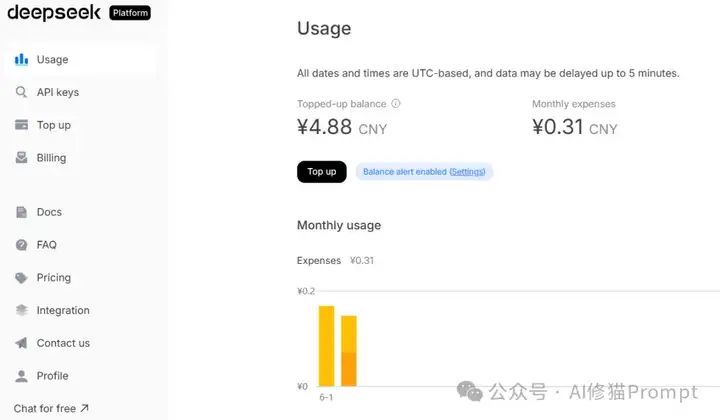

假期我花了0.31元人民币,用Deepseek模型运行了一遍这两个系统。结果让我很震撼:

- AlphaEvolve在3分钟内将一个函数优化算法的性能提升了8.52%

- DGM更是将排序算法的性能提升了345%——从简单的冒泡排序直接进化成了高度优化的快速排序

就像看到AI在我面前重新发明了算法。

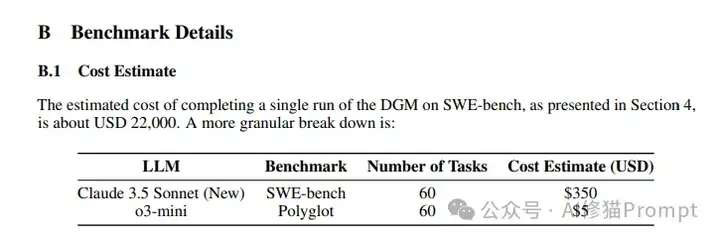

成本对比震撼:DGM的官方实验运行一次需要大约2.2万美元的计算成本,而我用国产的Deepseek模型。仅仅花费了0.31元人民币就体验到了AI自我改进的核心能力,先别急着跟我掰持,如果您也需要用Claude 3.6 sonnet和o3-mini运行SWE-bench花费0.31元人民币断然是不够的,我说的是体验,运行DGM主要代码并使用Deepseek-R1-0526模型进行体验。

这让我看到了一个重要信号:AI自我改进技术正在加速,加速!加速。。。

更让我感到震撼的是,AlphaEvolve能够56年来首次改进Strassen矩阵乘法算法——这可是1969年以来数学界的一个开放问题啊!这两个系统有个共同的野心:让AI自己改进自己的代码,不再需要我们人类手把手地优化算法。

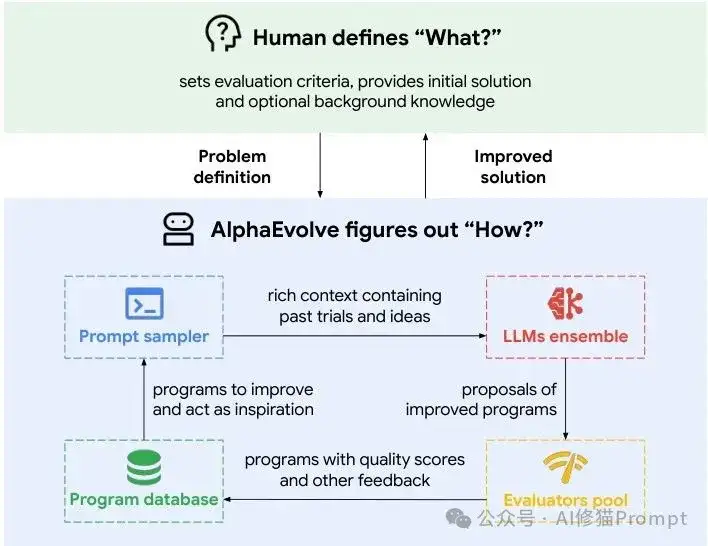

AlphaEvolve高层概览

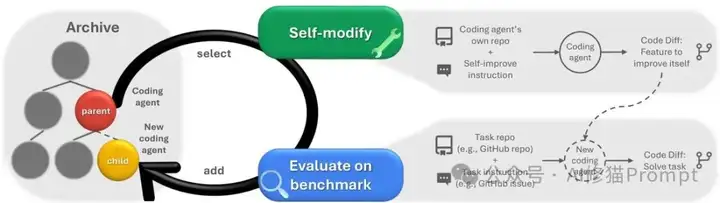

Darwin Gödel Machine系统概览。DGM通过交替进行自我修改和下游任务评估,迭代构建不断增长的智能体档案库。

什么是"自我改进"的AI?不是调参那么简单

您可能会想,AI自我改进不就是自动调参吗?但这两个系统做的事情完全不一样。

传统方式 vs 自我改进:

- 传统AutoML/超参数优化:在人类设计的框架内打转,就像给车换不同的轮胎,但车的基本结构不变

- AlphaEvolve和DGM:让车自己决定要不要长翅膀、要不要变成潜水艇,甚至重新设计整个交通工具的概念

这种自我改进的核心在于,系统能够修改自己的源代码,而不仅仅是调整参数。这意味着什么?

意味着AI可以改变:

- 自己的算法逻辑

- 工具组合

- 整个工作流程

- 复杂的数学运算

- 人类尚未发现的未知领域

- 。。。

就像一个程序员不仅能调试代码,还能重构架构、发明新的编程范式一样。

AlphaEvolve:科学发现的进化引擎

谷歌是怎么让AI"进化"代码的

AlphaEvolve的工作方式其实挺像生物进化的,但比自然选择聪明多了。

核心机制:

- 程序数据库:存着各种不同版本的算法代码

- 突变操作员:用Gemini 2.0这样的LLM分析现有代码,提出改进建议

- 自动评估:通过评估函数筛选,只有表现更好的代码才会被保留

完全自动化的进化循环:

- 提示采样器从程序数据库中选择表现好的代码作为"父母"

- LLM基于这些代码和任务上下文生成新的代码修改(以diff格式输出)

- 评估器运行这些新代码并打分

- 优秀的代码被加入数据库

您可以把它想象成一个永不停歇的代码Code Review和重构过程,只不过参与者都是AI。

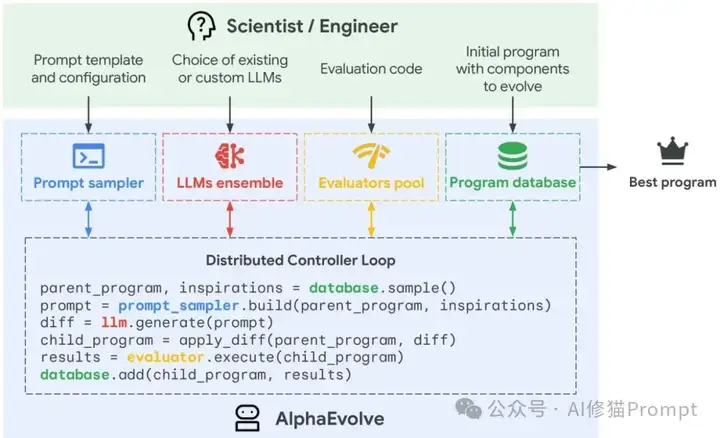

AlphaEvolve发现过程的详细视图

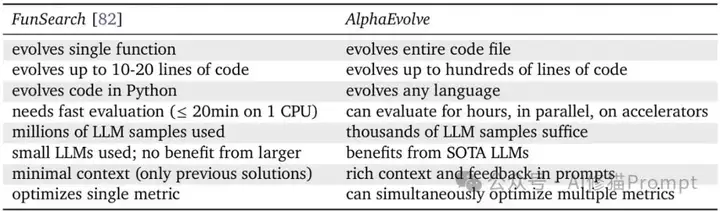

从矩阵乘法到数学难题,AlphaEvolve都能搞定

AlphaEvolve最让人印象深刻的成果是什么?它解决了一堆人类专家几十年都没搞定的问题。

矩阵乘法的历史突破:

- 历史问题:4×4矩阵相乘的最优算法一直是开放问题

- Strassen算法:1969年提出,需要49次标量乘法,56年来无人改进

- AlphaEvolve突破:找到了只需48次乘法的算法,复数域上的重大突破

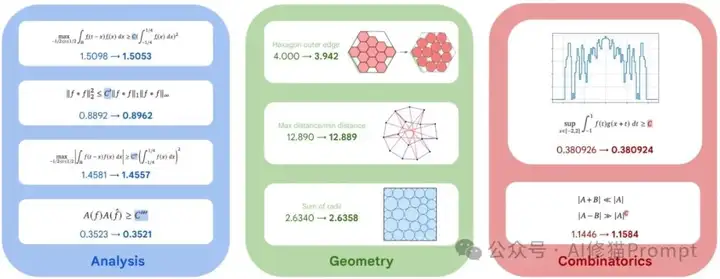

AlphaEvolve与前一代系统FunSearch的能力对比

更广泛的数学成就: 研究者把AlphaEvolve应用到了50多个数学构造问题上:

- Erdős的最小重叠问题

- 11维接吻数问题

- 各种几何包装问题

成功率令人瞩目:

- 75%的问题:重新发现了已知最优解

- 20%的问题:找到了比已知方案更好的构造

这个成功率说明什么?说明AI已经具备了在某些领域超越人类专家的发现能力。

AlphaEvolve发现的突破性数学构造示例

进化不是随机搜索,是有策略的探索

您可能觉得这听起来像是暴力搜索,但实际上AlphaEvolve的策略相当精妙。

评估级联机制:

- 新生成的解决方案先在简单测试用例上验证

- 只有通过了才会进入更复杂的评估阶段

- 就像招聘时的多轮面试,避免浪费计算资源

多目标优化策略:

- 同时追求多个评估指标的提升

- 即使只关心一个特定指标,多目标优化往往效果更好

- 不同评估标准产生结构不同的优秀程序,激发LLM更有创意的解决方案

AlphaEvolve发现更快矩阵乘法算法的代码变化过程

验证AlphaEvolve,结果如何?

从理论到现实:一个函数优化任务的演进过程

说了这么多理论,您可能好奇这些系统实际运行起来是什么样子。

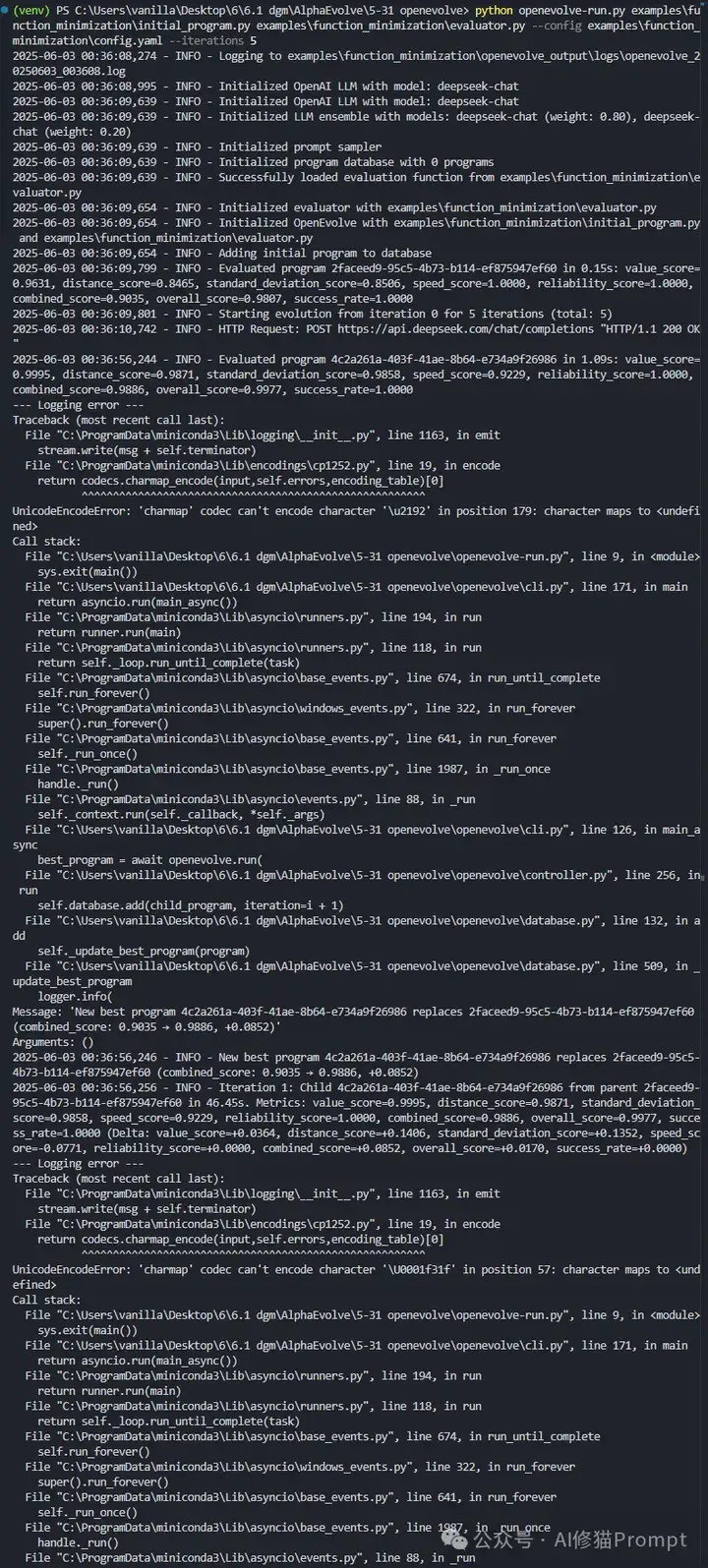

我的实验设置:

- 模型:Deepseek-V3

- 项目:AlphaEvolve的开源版本OpenEvolve(见文末Reference)

- 任务:经典的函数最小化问题

- 时间:大约3分钟

- 迭代次数:5次代码进化

结果确实让人印象深刻——不是那种夸张的"惊人",而是实实在在看得见的改进。

图:AlphaEvolve(OpenEvolve)使用Deepseek模型进行函数优化的实际运行过程

数据不会撒谎:从0.9035到0.9886的飞跃

性能提升数据:

- 初始算法评分:0.9035

- 5次迭代后:0.9886

- 提升幅度:8.52%

您可能觉得这个提升看起来不大,但要知道,这是在一个已经相当优化的基准任务上实现的改进。在实际的工程场景中,8%的性能提升往往意味着:

- 数百万的成本节约

- 用户体验的显著改善

更有趣的权衡策略: 系统在不同维度上的表现:

- speed_score:从1.0000降到0.9229(略有下降)

- value_score、distance_score、standard_deviation_score:都有显著提升

这说明AI学会了通过稍微增加计算复杂度来换取更好的解决方案质量——这种权衡策略正是优秀程序员会做的决策。

真实世界的不完美:错误处理和系统鲁棒性

运行过程中出现了一些有意思的现象,这让我们看到了系统的真实表现。

语法错误处理:

- 系统生成的某些代码变体包含语法错误(比如括号未闭合)

- 这在自动代码生成中很常见

- 关键是:AlphaEvolve的评估系统能够自动检测这些错误

- 丢弃有问题的代码,继续用其他有效的变体进化

工程化问题:

- 遇到了Unicode编码问题(Windows环境下常见)

- 不影响核心算法执行

- 提醒我们:将研究原型部署到生产环境时,仍需考虑各种工程化问题

DGM:真正的"自我指涉"改进系统

从理论到实践,Gödel机器的现实版本

Darwin Gödel Machine的名字听起来就很有学术范儿,它的灵感来自Schmidhuber在2006年提出的Gödel机器理论。

理论 vs 实践的转换:

- 原始Gödel机器:要求系统在修改自己之前必须能够数学证明这种修改是有益的

- 现实问题:这在实践中几乎不可能做到

- DGM的创新:放弃数学证明要求,改用经验验证——通过编程基准测试判断修改效果

DGM的核心特征:自我指涉性

DGM和AlphaEvolve最大的不同在于"自我指涉性":

- DGM不仅要解决编程任务

- 还要改进自己解决编程任务的能力

- 而改进自身的过程本身就是一个编程任务

这形成了一个递归循环:

更好的编程能力 → 更好的自我改进能力 → 更好的编程能力

精妙之处:下游任务的改进直接反映了系统自我改进能力的提升

开放式探索:为什么要保留"失败"的尝试

DGM采用了一种叫做"开放式探索"的策略,这点特别值得注意。

核心理念:

- 系统维护一个包含所有历史智能体的档案库

- 即使某些智能体在当时看起来表现不佳,也不会被丢弃

- 原因:看似"失败"的尝试可能包含有价值的创新点

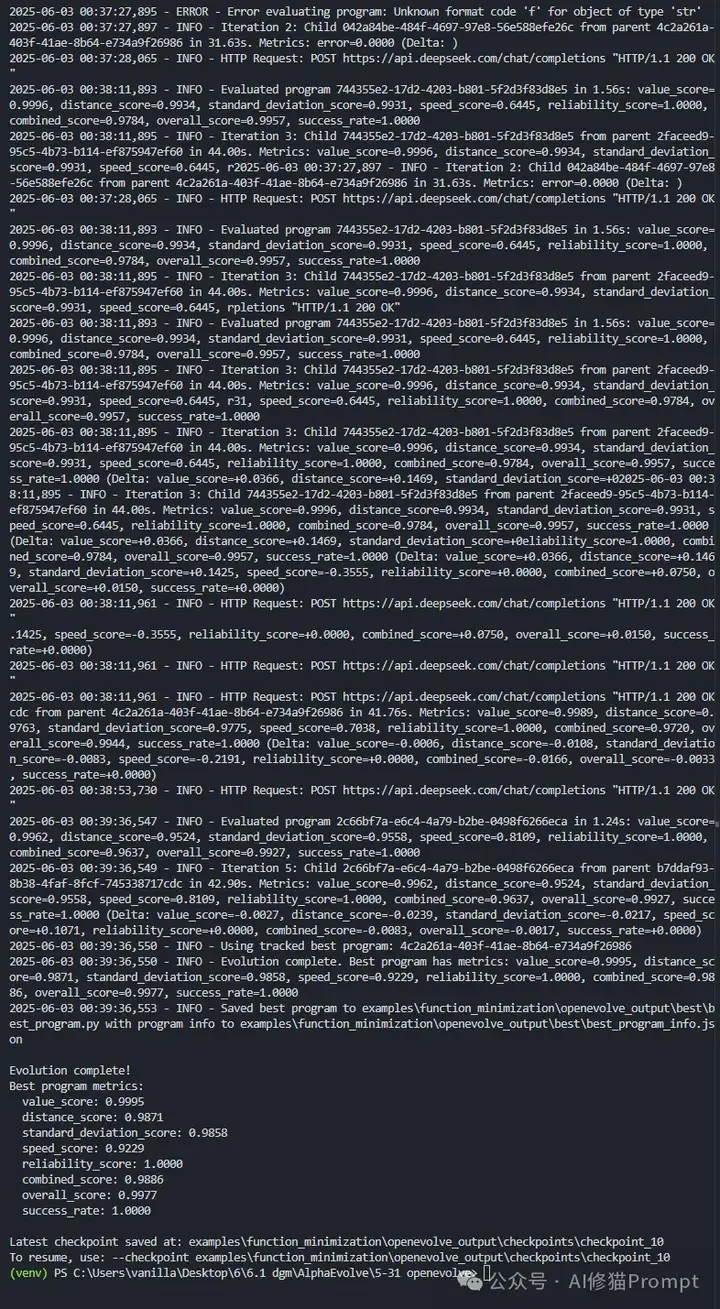

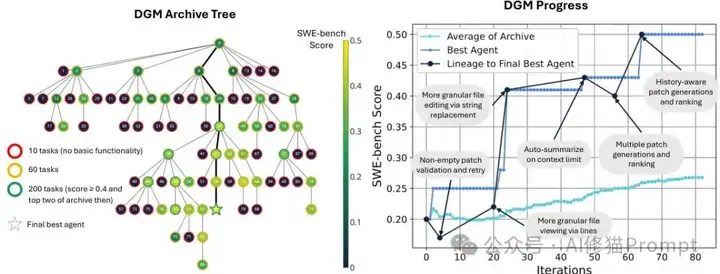

DGM的自动改进过程

真实案例证明: 在SWE-bench实验中:

- DGM在第4次和第56次迭代时性能都出现了临时下降

- 系统没有回滚到之前的版本

- 继续基于这些"退步"的版本进行探索

- 结果:这些看似退步的分支最终产生了超越所有前代的优秀智能体

就像科学研究中的"偶然发现"——很多重大突破都来自于看似失败的实验。

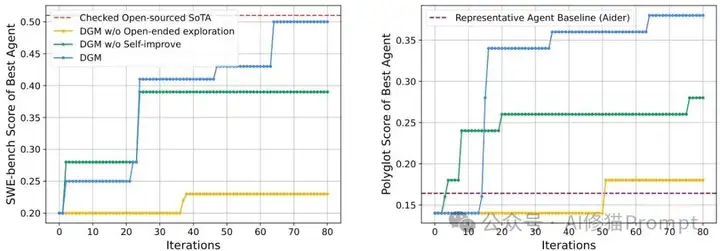

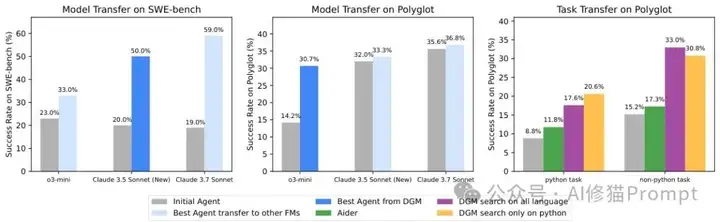

从20%到50%,DGM在编程任务上的突破

基准测试表现:

- SWE-bench:从20.0%提升到50.0%

- Polyglot:从14.2%提升到30.7%

但更重要的是它是怎么做到的——系统自动发现了:

自动发现的改进:

- 更精细的文件编辑工具(支持按行查看和字符串替换)

- 改进的多轮尝试机制

- 同行评审机制(用另一个FM来评估和选择最佳解决方案)

关键点:这些改进都不是人类预先设计的,完全是系统在自我探索过程中发现的。

自我改进和开放式探索使DGM能够持续进步

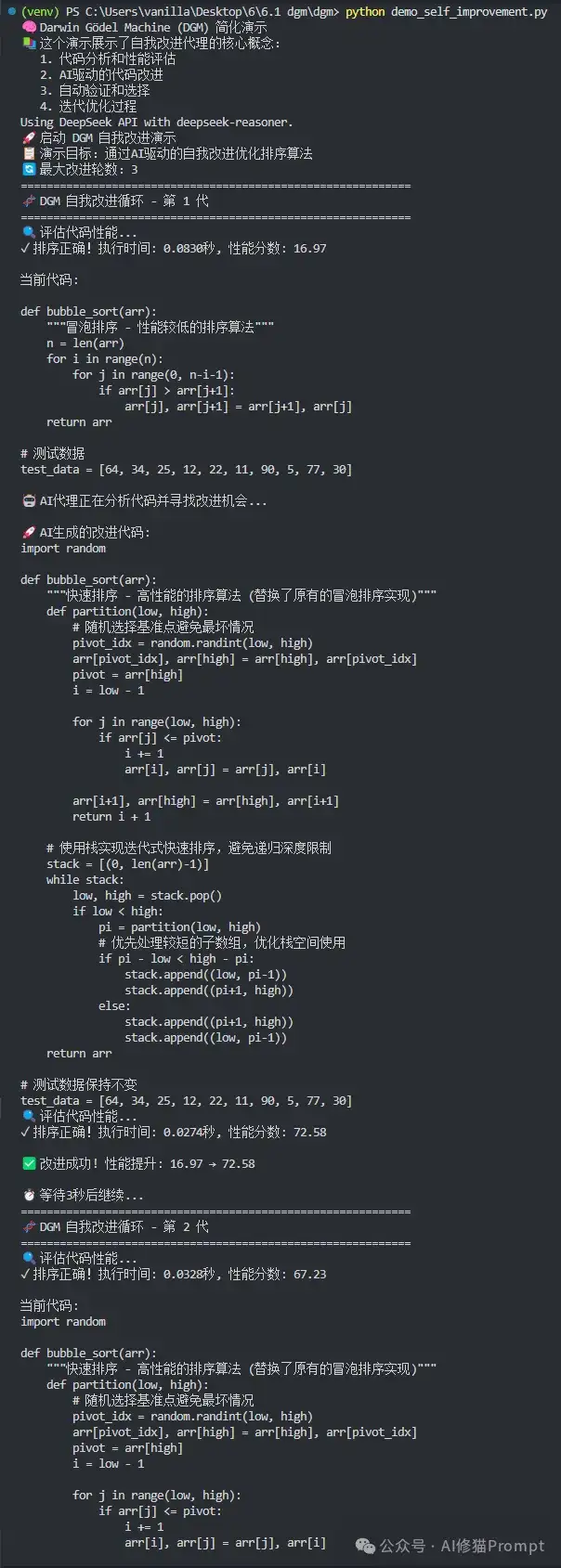

DGM实践:从冒泡排序看AI进化之路

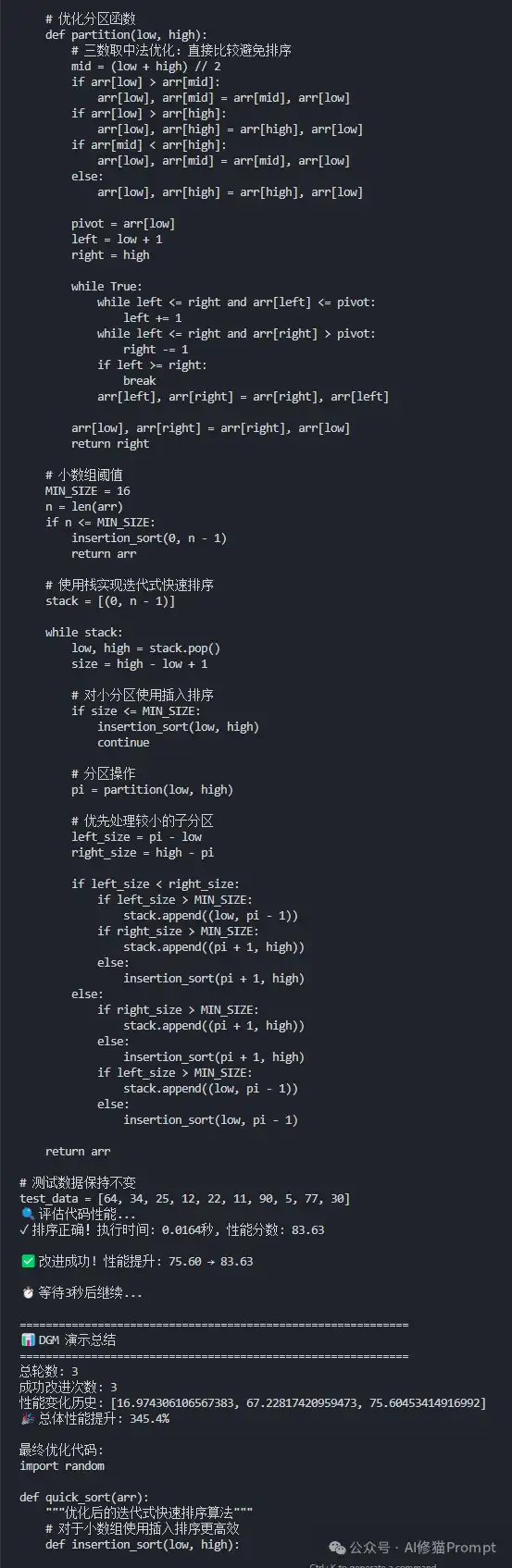

345%性能提升背后的智能决策

相比AlphaEvolve的渐进式优化,DGM展现出了更加激进的自我改进策略。

我的实验结果:

- 模型:Deepseek

- 任务:排序算法优化演示

- 迭代轮次:3轮

- 性能跨越:从16.97到83.63

- 总体提升:345.4%

更重要的是,我们可以清楚地看到AI是如何一步步进行"算法重构"的,这种改进远远超出了传统的参数调优范畴。

图:DGM使用Deepseek模型进行排序算法自我改进的完整过程

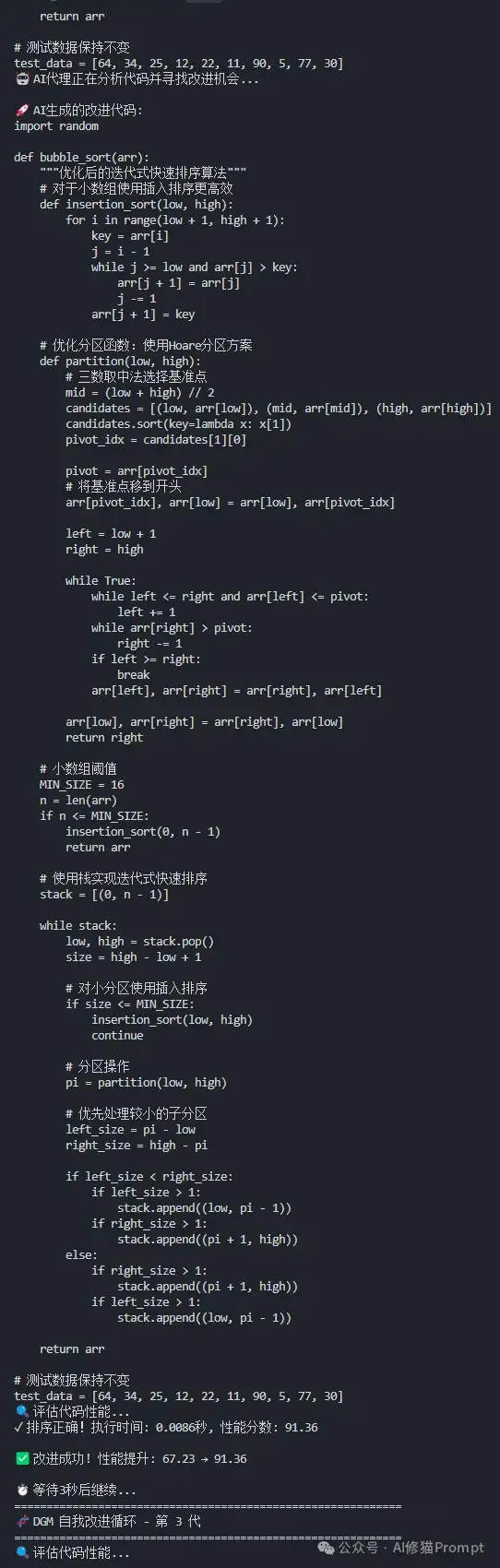

不是参数调优,是算法重新发明

第一轮改进:最震撼的算法范式转变

AI直接放弃了原来的冒泡排序实现,完全重写成了迭代式快速排序。

这不是简单的代码优化,而是算法范式的根本转变:

- 从:O(n²)的冒泡排序

- 到:O(n log n)的快速排序

AI自己"意识到"了冒泡排序的本质缺陷,并选择了更适合的算法结构。这种决策能力已经接近了一个资深算法工程师的水平。

第二轮和第三轮:精深的算法优化

展现了AI对算法细节的精深理解:

- 混合排序策略:小数组用插入排序

- 三数取中的基准选择

- 栈空间使用模式优化

这些都是教科书级别的快速排序优化技巧,证明AI已经掌握了算法设计的核心原理,而不仅仅是在模仿现有代码。

真实的探索过程:有进有退才是常态

DGM的运行过程真实地反映了探索的不确定性。

性能波动的真实性:

- 第三轮评分:83.63

- 第二轮评分:91.36

- 现象:第三轮实际上比第二轮有所下降

- 系统行为:没有简单地回滚到前一个版本

这种"容忍暂时退步"的策略正是开放式探索的精髓——有时候看似的退步可能为更大的突破铺路。

多维度权衡能力: 我们可以观察到AI在不同维度上的权衡策略:

- 算法正确性

- 执行效率

- 代码可读性

- 内存使用

这种多目标优化的能力说明,DGM已经具备了相当成熟的工程判断力。

专用vs通用两套系统的核心差异

应用领域的分化:科学发现 vs 编程智能体

虽然AlphaEvolve和DGM都采用进化算法和LLM驱动的代码修改,但它们的应用重点完全不同。

AlphaEvolve:科学发现引擎

- 定位:专门解决有明确评估标准的科学和工程问题

- 应用领域:

- 矩阵乘法

- 数学构造

- 系统优化

- 强项:能够处理各种不同问题类型,从数学证明到工程优化

DGM:通用智能智能体

- 定位:构建能够持续自我改进的系统

- 专注领域:编程任务

- 核心假设:如果系统能够更好地编写代码,就能更好地改进自己

- 理论潜力:具有无限改进潜力的自我指涉设计

技术架构的不同选择

AlphaEvolve的架构特点:

- 分布式异步架构:可以同时运行数千个评估任务

- 适用场景:计算密集型的科学问题

- 评估级联:先用简单测试筛选,再进行深度评估

- 优势:大大提高效率

DGM的架构特点:

- 相对简单的架构:但在"开放式探索"上下功夫

- 父代选择机制:考虑性能表现和已有子代数量

- 平衡策略:既利用优秀解决方案,又保持探索多样性

- 可追溯性:每个智能体的修改历史都有完整记录

实际应用:这些系统能为您的AI项目带来什么

AlphaEvolve的工程价值:从算法优化到系统加速

如果您正在开发需要高性能计算的AI产品,AlphaEvolve展示的能力就很有参考价值。

谷歌的实际应用: 研究者用它优化了谷歌计算栈的多个关键组件:

- 数据中心调度算法

- LLM训练用的矩阵乘法内核

- TPU内部的算术电路

- Transformer的attention计算加速

这些都是实际生产环境中的关键瓶颈,任何微小的改进都能带来巨大的经济价值。不过,AlphaEvolve的源码是需要向谷歌申请的,以上运行的openEvolve版本仅是复现。

对您项目的启示: 如果把AlphaEvolve应用到您的推理服务优化上,系统可能会自动发现:

- 新的批处理策略

- 内存管理方法

- 您从未想过的算法组合

关键优势:这种优化是端到端的,不需要您预先定义搜索空间,系统会自己探索各种可能性。

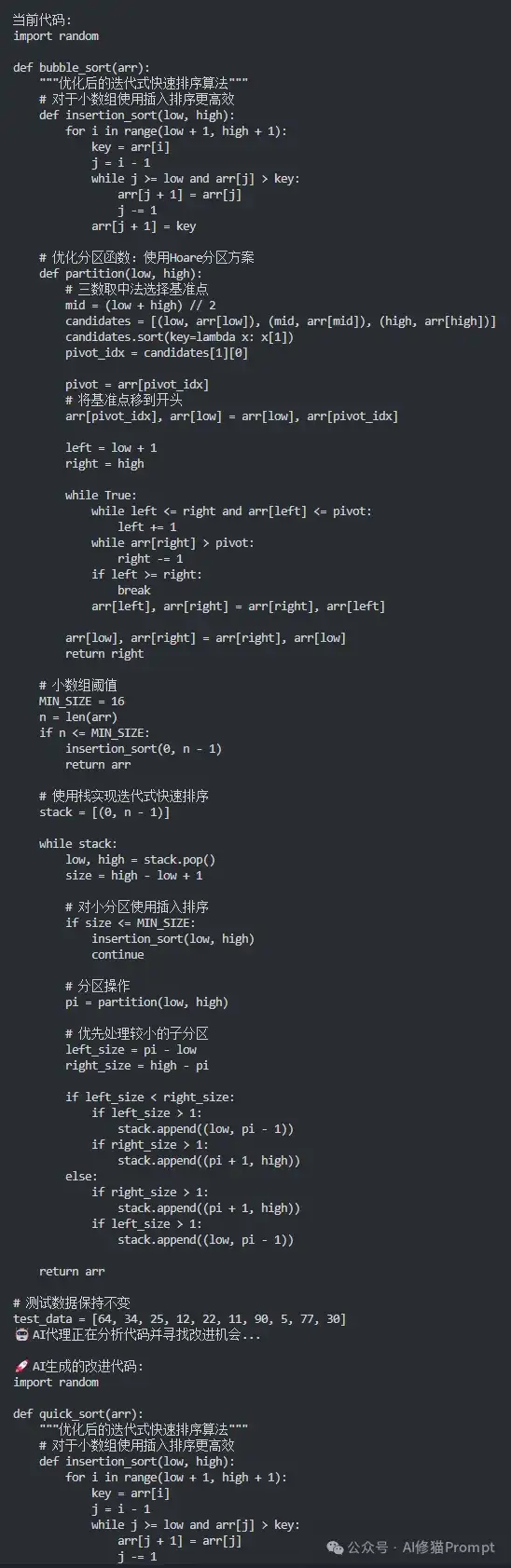

DGM的产品启示:自我改进的智能体架构

DGM的价值更多体现在系统架构层面。

应用场景举例: 如果您在构建复杂的AI智能体系统,比如:

- 您的客服机器人不仅能回答用户问题

- 还能根据用户反馈自动改进自己的对话策略

- 优化知识检索方法

- 甚至改进整个交互流程

现实验证: DGM证明了这种自我改进并非空想:

- SWE-bench:表现已经接近开源SOTA水平

- Polyglot:甚至超越了人类专家长期优化的Aider工具

这说明,给AI足够的自主权和合适的反馈机制,它确实能够实现持续的自我提升。

DGM发现的改进可以在不同模型和任务间迁移

挑战:理想很丰满,现实有骨感

计算成本:烧钱的自我改进

说到实际部署,我们不得不面对一个现实问题:这些系统的计算成本都不低。

成本现状:

- DGM:SWE-bench上一次完整运行需要大约2周时间,API调用费用本文开头时所示,2.2万美元

- AlphaEvolve:虽然在采样效率上有所改进,但对于复杂问题仍然需要大量的LLM调用

投资回报思考: 换个角度想,如果系统能够自动发现像矩阵乘法算法那样的突破性改进,这种一次性投入是完全值得的。换句话说,看你用这种自进化系统想获得啥样的关键发现,认为值就跑起来。。。

关键策略:选择合适的应用场景——那些改进后能带来长期收益的核心算法和系统组件。

安全性:自我修改的双刃剑

让AI系统修改自己的代码,这事听起来就有点危险。

DGM的安全措施: 研究者认真考虑了安全问题:

- 沙盒环境

- 时间限制

- 人工监督

- 完整的修改追踪

现实挑战: 但老实说,这些措施在真正的生产环境中肯定不够,潘多拉魔盒早已打开,做好拔插头的准备就好了~

AlphaEvolve的相对优势: 在这方面相对保守一些:

- 主要针对有明确评估标准的科学问题

- 风险相对可控(仅从论文和复现代码观察)

如果要把这种自我修改能力应用到更广泛的AI系统中,安全机制还需要更多的研究和完善。

基础模型的限制:巧妇难为无米之炊

这两个系统都严重依赖底层大语言模型的能力。

模型能力的制约:

- AlphaEvolve的实验显示,使用更强的模型确实能得到更好的结果

- 系统的上限受到当前LLM能力的制约

- 如果底层模型无法理解某个领域的复杂概念,再精妙的进化算法也无济于事

一些启发

重新思考AI系统的设计模式

这两个项目最重要的启示可能是:我们需要重新思考AI系统的设计模式了。

传统 vs 新范式:

- 传统做法:人类设计架构,AI在框架内学习和优化

- 新的可能性:AI已经具备了参与甚至主导系统设计的能力

设计建议: 您在设计下一个AI产品时,不妨考虑留出一些"可进化"的空间:

- 把某些关键组件设计成可替换的模块

- 配置自动化的评估机制

- 让系统能够实验不同的实现方案

仔细借鉴下这些代码的精华,这样您的产品或许也就具备了持续自我改进的潜力。

评估机制的重要性:没有反馈就没有进化

两个系统都强调了自动化评估的重要性,这对我们设计AI产品很有启发。

核心要求: 如果您想让AI系统持续改进,就必须设计出能够:

- 快速、准确评估系统性能的机制

- 衡量最终效果

- 提供足够的信号来指导改进方向

设计原则: 找到"代理指标"——既容易自动化评估,又能真实反映系统的核心能力。

DGM选择编程基准作为评估标准,是因为编程能力和自我改进能力有直接联系。

或许是AGI的新路径?

自我改进:通向AGI的必经之路

从某种意义上说,自我改进能力可能是AGI的必要条件之一。

人类智能的特征: 人类智能的一个重要特征就是能够:

- 反思和改进自己的思维方式

- 学会学习

- 学会思考

当前进展: AlphaEvolve和DGM在这个方向上做出了重要探索,证明了AI系统确实可以获得某种程度的自我改进能力。

现实评估: 当然,目前这些系统还远远达不到AGI的水平,它们的自我改进还局限在特定领域内。

但这个开始很重要——就像最早的神经网络只能识别简单图案,但为深度学习革命奠定了基础一样。

科学发现的自动化:人机协作的新模式

AlphaEvolve在数学和算法发现上的成功,让我们看到了科学研究自动化的可能性。

未来科研模式: 未来的科学发现可能不再是纯粹的人类活动,而是:

- 人类直觉 + AI计算能力的深度结合

- 人类提供问题定义和评估标准

- AI负责大规模的探索和验证

现实验证: 这种模式已经在AlphaEvolve的数学问题研究中得到了验证:

- 许多问题都是由数学家Javier Gomez Serrano和Terence Tao建议的

- 然后由AI系统去寻找解决方案

这种人机协作的模式可能会成为未来科研的新范式。

既要又要还要

不管怎么说,AlphaEvolve和DGM都代表了AI发展的一个重要节点。

它们告诉我们,AI已经不再满足于:

- 被动地执行人类设计的任务

而是开始:

- 主动探索改进自身的可能性

作为AI产品的开发者,我们既要:

- 抓住这种技术进步带来的机遇

- 又要认真对待其中的挑战和风险

最后的问题:您准备好迎接这个AI自我改进的时代了吗?当谷歌和USC等用OpenAI和Claude的模型,跑通了AI自进化系统,不管怎样,您至少还要像我这样,用DeepSeek把代码运行起来体验一下。

Reference:

AlphaEvolve

论文:https://storage.googleapis.com/deepmind-media/DeepMind.com/Blog/alphaevolve-a-gemini-powered-coding-agent-for-designing-advanced-algorithms/AlphaEvolve.pdf

代码:https://github.com/codelion/openevolve(并非谷歌官方源码,请注意识别)

DGM

论文:https://arxiv.org/pdf/2505.22954

代码:https://github.com/jennyzzt/dgm

文章来自于“AI修猫Prompt”,作者“AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0