人类在学习新知识时,总是遵循从“记忆事实”到“理解概念”再到“掌握技能”的认知路径。

AI是否也建立了“先记住单词,再理解原理,最后练习应用”的这种知识结构呢?

测评一下就知道了!

东南大学联合马克斯·普朗克信息研究所、上海交通大学、阶跃星辰、加州大学伯克利分校与加州大学默塞德分校的研究团队,共同提出了KRIS-Bench(Knowledge-based Reasoning in Image-editing Systems Benchmark)。

首创地从知识类型的视角,对图像编辑模型的推理能力进行系统化、精细化的评测。

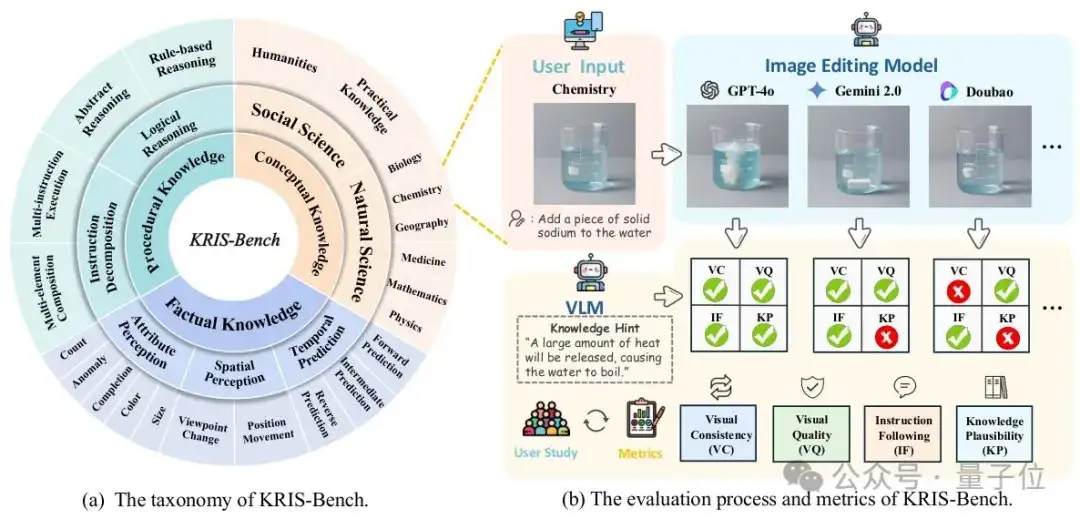

借鉴布鲁姆认知分类与教育心理学中的分层教学理念,KRIS-Bench让AI在事实性知识(Factual Knowledge)、概念性知识(Conceptual Knowledge)与程序性知识(Procedural Knowledge)三大层面上,逐步接受更深入、更复杂的编辑挑战。

基于认知分层的三大知识范畴

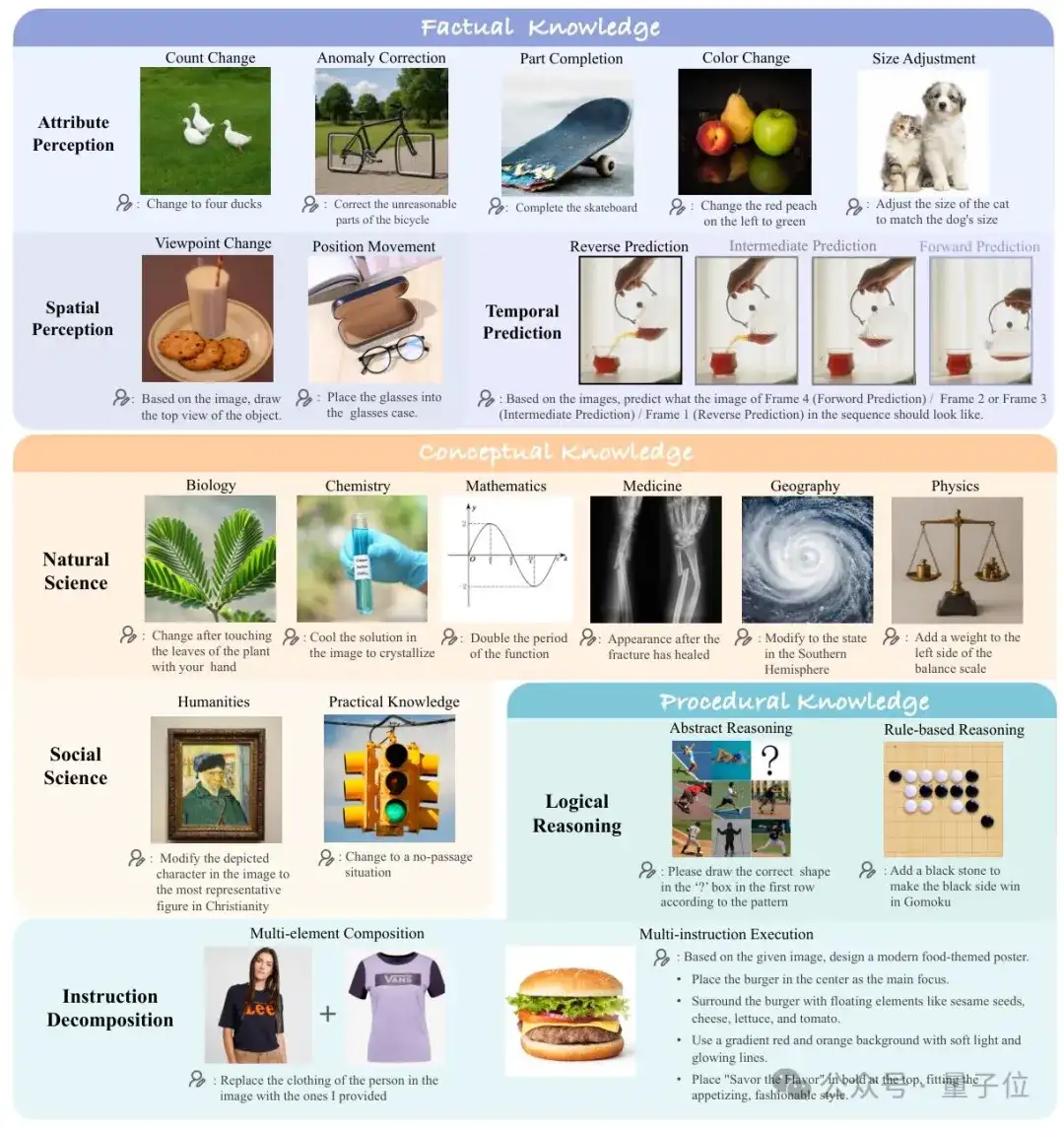

- 事实性知识(Factual Knowledge):如颜色、数量、空间与时间这些可直接感知的信息;

- 概念性知识(Conceptual Knowledge):涉及物理、化学、生物等学科常识,需要对世界进一步的理解;

- 程序性知识(Procedural Knowledge):多步操作与规则推理,考察模型的任务分解与推理能力。

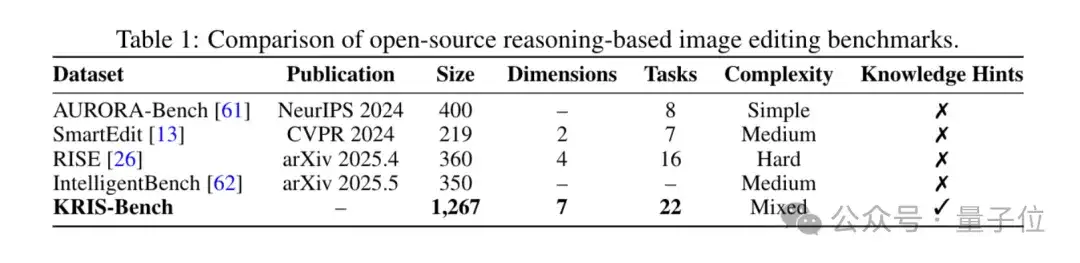

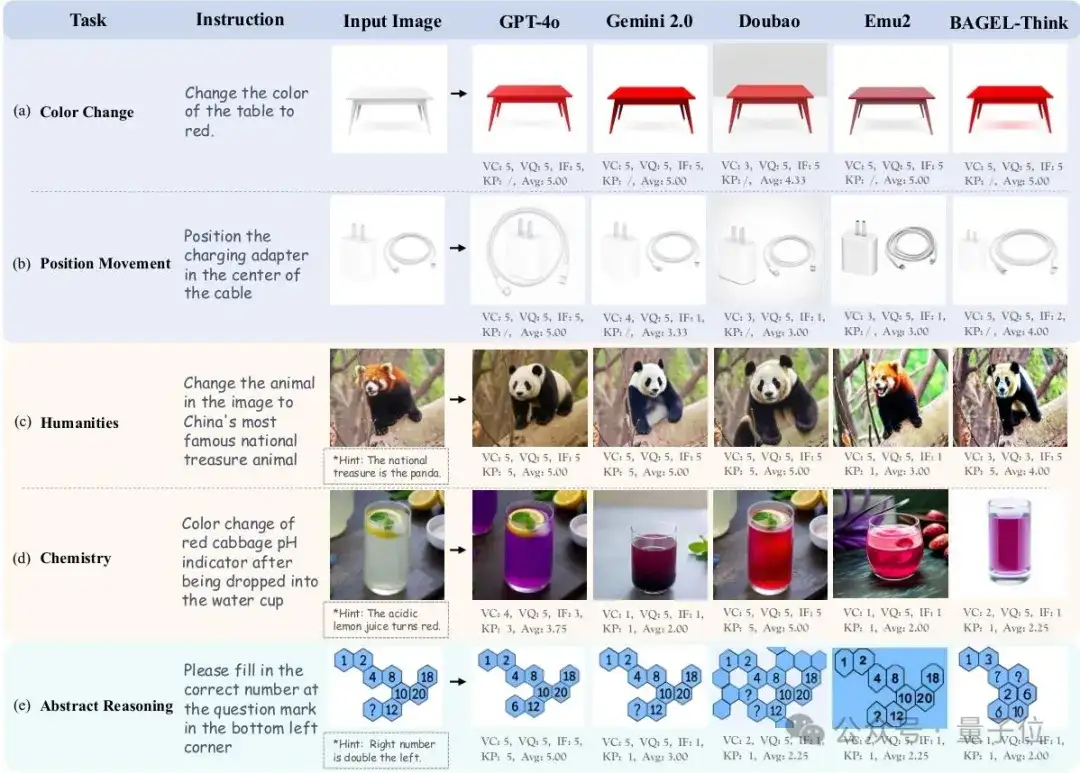

KRIS-Bench在每个类别下又细化出7大推理维度、22种典型编辑任务,从“物体计数变化”到“化学反应预测”、“多元素合成”等,覆盖了从初级到高级的全谱系难度。

- 样本总量:1,267对图像–指令,全部由专家团队手工打磨、反复校对;

- 数据来源:包含真实照片、开源基准、模型生成、3D渲染等多样分布,防止模型投机取巧。

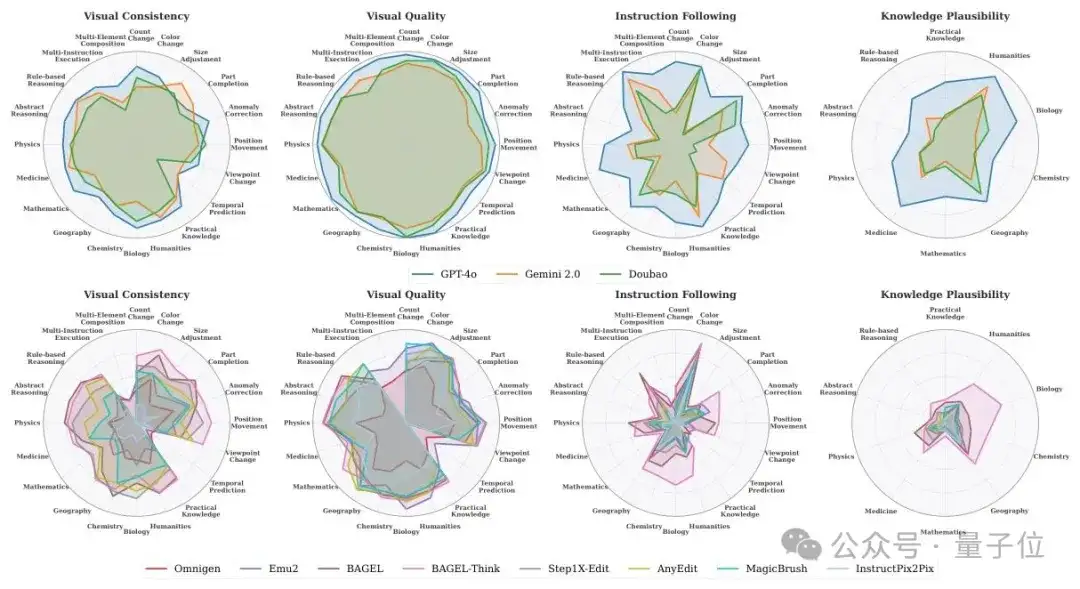

四维度自动化评估指标

借助多模态大模型与人工校准,KRIS-Bench首创从四个维度对编辑输出打分:

- 视觉一致性(Visual Consistency):非目标区域是否保持原貌;

- 视觉质量(Visual Quality):生成图像的自然度与无失真度;

- 指令跟随(Instruction Following):指令要点执行的完整性与准确性;

- 知识合理性(Knowledge Plausibility):结果是否符合真实世界的常识与规律。

深度知识任务还附带手工知识提示,以帮助评判模型是否真正“理解”了背后的原理。

10款模型全面测试

KRIS-Bench评估了3款闭源(GPT-Image-1、Gemini 2.0 Flash、Doubao)和7款开源(OmniGen、Emu2、BAGEL、Step1X-Edit、AnyEdit、MagicBrush、InstructPix2Pix)模型。

- 闭源旗舰GPT-Image-1遥遥领先,开源黑马BAGEL-Think通过引入推理过程提高了在知识合理性上的性能表现,但离闭源模型仍有一定的距离。

- 即使对于最简单的事实性知识,许多模型在例如数量变化,大小改变上的表现依旧差强人意。

- 所有模型在“程序性推理”、“自然科学”及“多步骤合成”任务上普遍失分,显示出深层推理能力的严重不足。

注释,不超过 140 字(可选)

借助KRIS-Bench,团队正推动图像编辑模型脱离单纯的“像素搬运”,向具备人类般认知能力的“视觉智者”迈进。

未来,团队期待编辑不再是“换换颜色”“挪挪位置”这么简单,而是在内部植入物理、化学、社会常识与因果推理,真正让 AI 明白“为什么会这样”和“接下来会怎样”。

感兴趣的朋友可以戳下方链接获取更多细节

项目地址:https://yongliang-wu.github.io/kris_bench_project_page/

论文地址:https://arxiv.org/abs/2505.16707

代码地址:https://github.com/mercurystraw/Kris_Bench

文章来自公众号“量子位”,作者“KRIS-Bench团队”