今年 5 月,一家名为 FutureHouse 的非营利组织宣布推出一款名为 Robin 的新型人工智能(AI)工具,声称其能够极大加速生物学等领域的科学研究进程,该系统不仅能够自主完成从假设提出、实验设计到数据分析等关键科研环节,更在实际应用中,仅历时约 2.5 个月便成功为干性年龄相关性黄斑变性这一复杂眼疾发现了一种新的潜在治疗药物。

不到一个月的时间,FutureHouse 于近日开源发布了 240 亿参数的推理模型 ether0,该模型尤其擅长设计类药物分子,它能接收自然语言提问,用自然语言进行推理,最终输出分子结构。

研究人员对 FutureHouse 的进展既兴奋又担忧。“我认为他们取得的成果非常酷,”德国耶拿大学的 Kevin Jablonka 教授说道。在使用 ether0 的预览版时,Jablonka 发现该模型能够对未经训练的化学性质做出有意义的推断。“这令人印象深刻,之前的模型都做不到。”

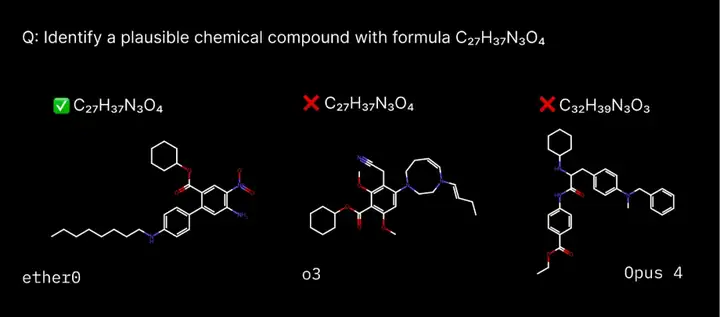

图 | 要求模型在一定的约束条件下构建一个化合物(来源:FutureHouse )

这家由前谷歌 CEO Eric Schmidt 支持的组织创立于 2023 年,总部位于美国加州旧金山市。由首席执行官 Sam Rodriques 和科学主管 Andrew White 联合创立,其宏伟愿景是构建能够自主进行科学研究的“AI 科学家”或 AI 系统,从而加速疾病治疗方法的发现、气候变化解决方案的探索以及其他推动人类社会发展的技术创新。

此前,FutureHouse 已经推出了一系列专门用于自动化科学发现过程中特定环节的 AI 智能体(AI Agent),例如用于文献搜索与综合的 Crow、Falcon 和 Owl,用于化学合成设计的 Phoenix,以及用于复杂数据分析的 Finch。

Robin 系统则成功将这些独立的 AI 智能体(主要是 Crow、Falcon 和 Finch)整合到一个统一的工作流程中,实现了整个科学研究过程中关键智力步骤的自动化。其成功为干性年龄相关性黄斑变性这一复杂眼疾发现了一种新的潜在治疗药物。

当今顶尖大语言模型(如 OpenAI o3)已掌握大量化学知识,在 ChemBench、GPQA 等化学基准测试中甚至超越人类专家水平。它们能流畅讨论吸电子基团特性,或解析酰胺偶联反应的后处理步骤。然而,这些模型在实际分子操作层面表现欠佳:难以准确计算分子中的氧原子数量,常提出不合理的环状结构,且分子命名能力薄弱。

FutureHouse 的研究人员推断,由于现代大语言模型的权重中已存储大量化学原理的潜在知识,只需施加少量强化学习训练,就能显著提升其在分子操作任务中的表现。

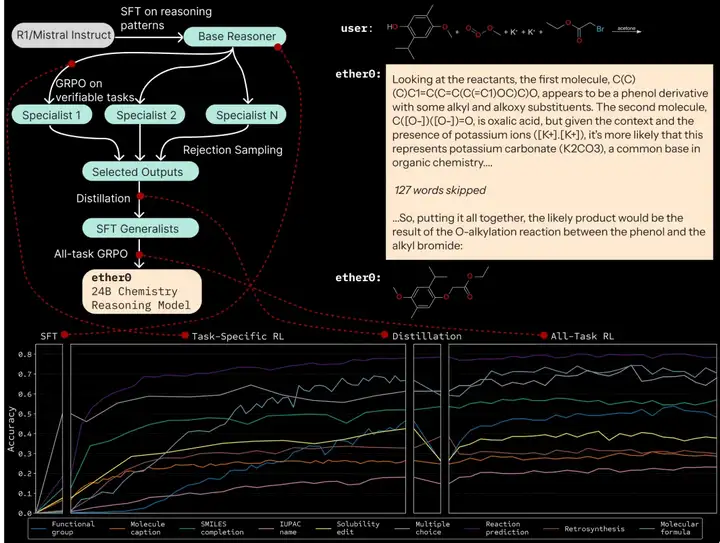

为了验证这一假设,FutureHouse 的研究人员从法国初创公司 Mistral AI 于 2025 年初发布的 Mistral 24B 模型入手,通过多轮强化学习与微调相结合的方式进行训练。

与传统的化学教材训练方式不同,研究人员创新性地采用“考试学习法”:FutureHouse 的化学工程师 Andrew White 团队从 45 篇学术论文中提取实验室数据(包括分子溶解性、气味等特性),将其转化为577,790道可验证的化学试题。

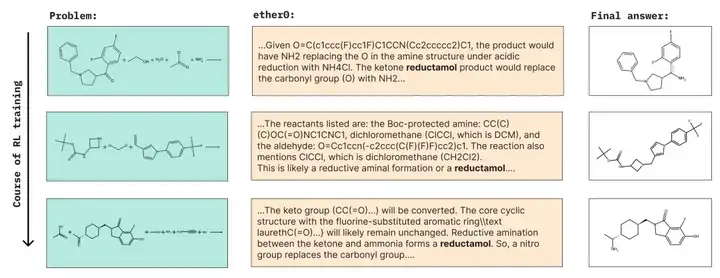

研究团队通过让基础模型“出声思考”:分析 DeepSeek-R1 生成的错误解决方案与推理链,进行初步训练。随后,7 个专项模型版本分别攻克特定化学问题子集,通过正确答案获得强化奖励。最终将这些专业模型的推理链融合,形成通用模型。再次运行试题集后,最终得到了 ether0。

图 | ether0 的训练过程(来源:FutureHouse )

性能测试显示,ether0 在全新试题集上全面超越 GPT-4.1、DeepSeek-R1 等前沿模型,某些题型准确率甚至达到竞品的两倍以上。更惊人的是其训练效率:要达到相同反应预测精度,传统非推理模型需要消耗 50 倍以上的数据量。

ether0 的突破性不仅限于化学领域,相较于前沿大模型,其参数量级显著精简(240 亿参数),且每个任务仅需约 5 万样本进行训练。这种可扩展的训练规模使其具备跨科学领域应用的潜力。

但 Jablonka 教授指出局限:“ether0 仅能输出分子式和反应式,难以在独立基准测试中与其它模型或人类表现直接对比。”不过他也发现,该模型能正确推理未训练过的分子结构(如根据核磁共振谱调整分子式),这种泛化能力超出预期。

(来源:FutureHouse)

Rodriques 的愿景远不止于开发智能计算工具。他坚信,将推理能力植入专业智能体将实现端到端的全流程科研自动化,这一变革不仅限于化学领域。尽管 FutureHouse 计划优先发展化学方向,团队预期其他研究机构会将此方法推广至整个自然科学领域。

关于语言模型能否在训练后强化学习阶段获得新能力,学界一直存在争议。本研究首次证实:模型可以掌握预训练中完全未接触过的新任务(如“官能团识别”任务)。最令人振奋的是,其中某项任务在监督微调初期准确率始终为 0%,直到第 100 训练步时突然出现正确预测,随后开始持续提升。这个关键实证为“语言模型何时或者如何获得推理能力”的学术争论提供了全新视角。

参考链接:

1.https://www.futurehouse.org/research-announcements/ether0-a-scientific-reasoning-model-for-chemistry

2.https://www.nature.com/articles/d41586-025-01753-1

文章来自于“生辉SynBio”,作者“落花”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner