Andrej Karpathy 在 YC AI 创业营的演讲火了。

「我们并非处于智能体之年,而是身处智能体的十年时代。」

从软件和大模型发展开始讲起,阐述了今天做软件开发需要具备什么样的技能,以及 LLM 时代,新的交互和人机关系。

以及,如何真正迈向软件 3.0 时代——提示词即应用的时代。

虽然官方还未发布现场视频,但 Latent Space 对推特上相关推文进行了整理,基本上整理出来了 PPT 的完整内容。我们第一时间进行了编译处理。

第一天的 YC AI Startup School 还有其他一些嘉宾的精彩分享,Sam Altman、李飞飞、马斯克和 Aravind Srinivas 等人的观点,我们一并整理了放在文中。

TLDR:

- Andrej Karpathy 提出,软件 3.0 (提示工程)时代正在取代 1.0(代码编程)和 2.0(神经网络)」,且大量软件将被重写。

- LLMs 是高智能与「认知缺陷」的结合体,可将 LLMs 视为「高智商但存在心智问题」的人类模拟系统,其能力强大但仍存在不可预测的局限性。

- LLMs 目前最大的问题是缺乏「认知自我知识」,这需要更复杂的模型后训练方法,而不是天真的「模仿人类标记者并使其变大」的解决方案。

- LLMs 具备「记忆能力」非常重要,不存储每个用户的随机事实,而是一般/全局的问题解决知识和策略。「记忆能力」会使 LLMs 在效能和数据利用率上显著更强,因为知识引导的「复盘」阶段提供的反馈维度,远比单一的奖励标量丰富得多。

- 在 AI 产品的设计中,Andrej Karpathy 提出了一个名为「Autonomy Slider」 的重要概念,它让我们能够根据具体情境选择自主程度,例如:

- Cursor :Tab -> cmd+K -> Cmd+L -> Cmd+I(agent 模式)

- Perplexity : search -> research -> deep research

- Tesla: Autopilot 自动驾驶仪:1 级至 4 级

01

软件 3.0:

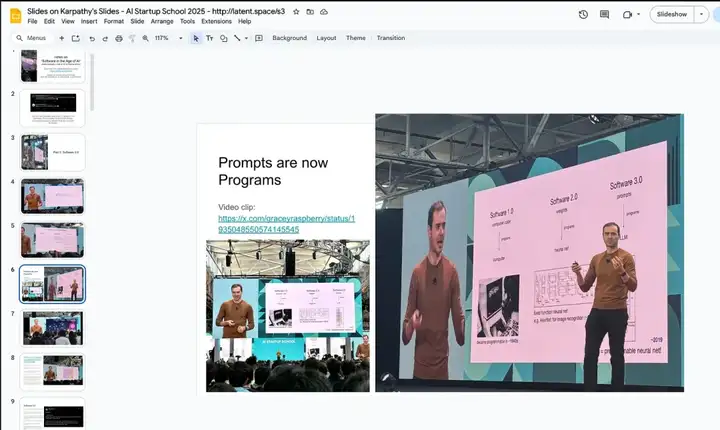

提示词即软件

我们在《AI 工程师的崛起》中首次探讨了「软件 3.0」的概念,而这一概念显然是《软件 2.0》论文与「最热门的新编程语言是英语」这一观点结合的必然产物。

他最初撰写《软件 2.0》论文时,正目睹着这套体系在特斯拉逐步取代传统软件 1.0。而如今他再次回归,针对软件 3.0 进行了内容更新。

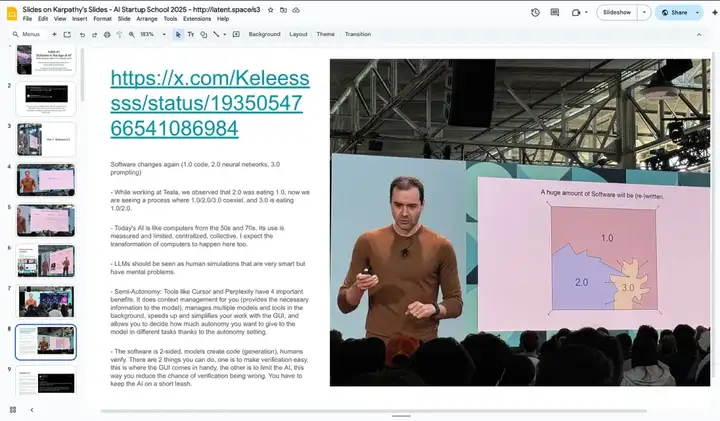

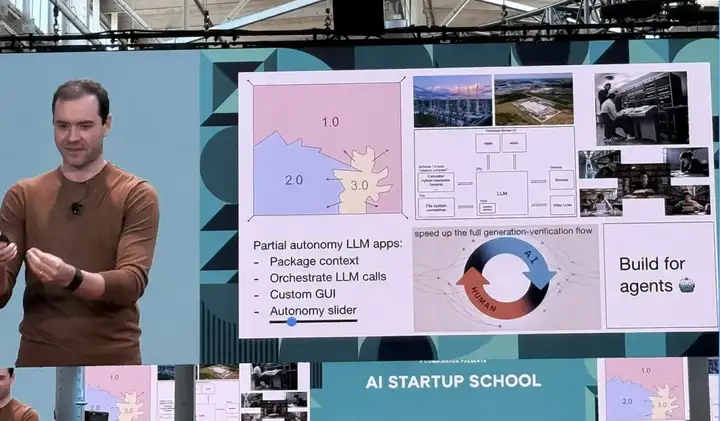

不同于我之前对软件 2.0 图表的修改方式, Andrej 此次推出了全新的示意图,展示了软件 1.0、2.0、3.0 交错共存的状态,并指出「软件 3.0 正在取代 1.0/2.0」,且「大量软件将被重写」。

软件的迭代演进(1.0 代码编程、2.0 神经网络、3.0 提示工程)

在特斯拉工作期间,我们观察到软件 2.0 逐步取代软件 1.0 的趋势;而如今,软件 1.0、2.0、3.0 正处于共存状态,同时软件 3.0 也在逐步取代前两者。具体观点如下:

当下 AI 的发展阶段类似 20 世纪 50 至 70 年代的计算机。

当前 AI 的应用仍受限于集中式、集体化的模式,其使用场景和范围被严格衡量与限制。但正如计算机的演进历程,AI 领域也有望迎来类似的变革。

LLMs 的双重属性:高智能与「认知缺陷」的结合体,可将 LLMs 视为「高智商但存在心智问题」的人类模拟系统,其能力强大但仍存在不可预测的局限性。

半自主工具的四大核心优势(以 Cursor 和 Perplexity 为例)

通过自主性设置与图形用户界面(GUI),这类工具实现了多维度效率提升:

- 上下文管理:自动为模型提供所需信息,避免手动输入的繁琐;

- 多模型与工具调度:在后台无缝管理不同模型与工具的协同工作;

- 交互效率优化:通过 GUI 简化操作流程,加速任务执行;

- 自主性灵活调控:允许用户根据任务需求,精确设置模型在不同环节的自主决策权限。

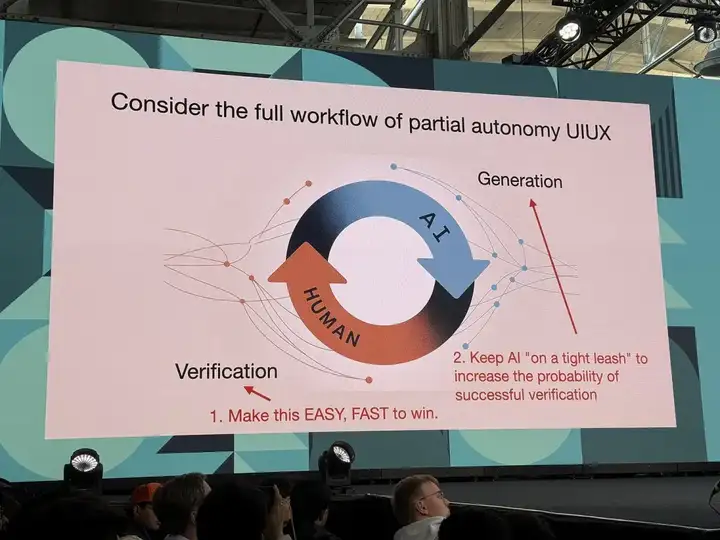

人机协作的双向软件开发模式

- 模型负责代码生成,人类负责结果验证。

- 实现高效协作的两个关键路径:

- 简化验证流程:借助 GUI 等可视化工具降低人工验证的复杂度;

- 限制 AI 权限:通过严格约束 AI 的决策边界,减少验证错误的发生概率,即「必须给 AI 戴上枷锁」。

Andrej 仍将重点放在「提示词即程序」的理念上,但我们在 2023 年就这一问题已经存在细微分歧,而且至今观点仍然没有完全一致:软件 3.0 中「1+2=3」式的逻辑框架,正是过去几年 AI 工程师表现远超提示词工程师,并将持续保持优势的核心原因。

02

重新定义大模型的公共属性

2.1 LLMs 类似于公共基础设施

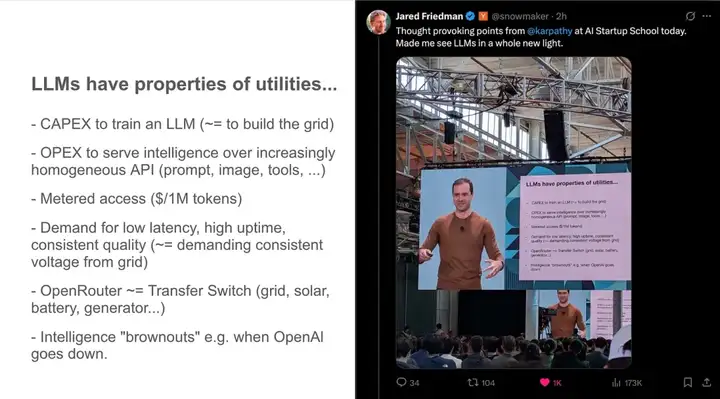

LLMs 具有公用事业的属性

- 训练 LLMs 的资本支出(相当于建设电网)

- 通过日益同质化的 API(提示词、图像、工具等)提供智能服务的运营支出

- 计量访问(每 100 万 tokens 收费)

- 对低延迟、高正常运行时间、质量一致性的需求(相当于要求电网提供稳定的电压)

- OpenRouter 相当于转换开关(电网、太阳能电池、发电机……)

- 智能 「电力不足」,例如当 OpenAI 宕机时

2.2 LLMs 就像晶圆厂

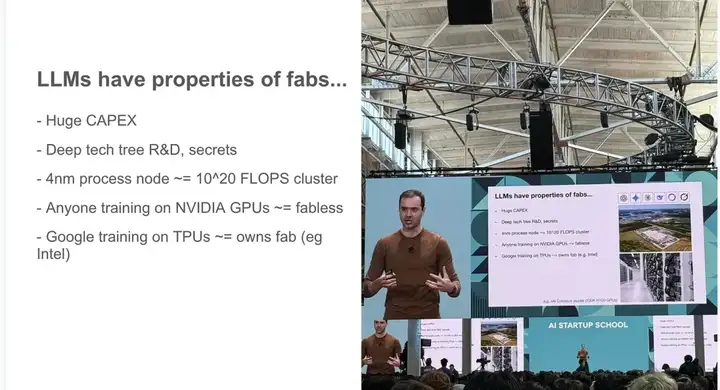

LLMs 具有晶圆厂的特性

- 巨额资本支出

- 深度技术树研发与技术机密

- 4 纳米工艺节点≈10²⁰次浮点运算集群

- 任何使用英伟达 GPU 训练的主体≈无晶圆厂

- 谷歌使用 TPU 训练≈拥有晶圆厂(如英特尔)

2.3 LLMs 类似于操作系统

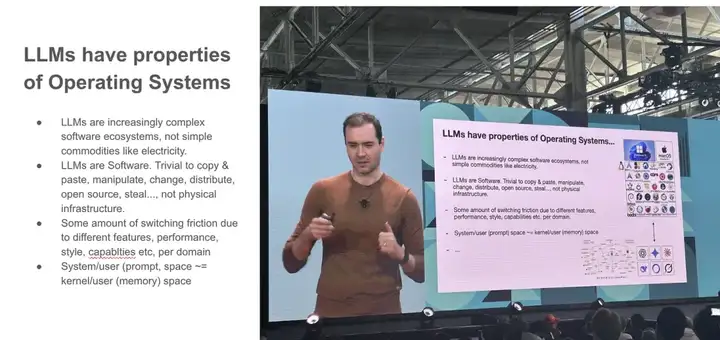

LLMs 具有操作系统的属性

- LLMs 正逐渐成为复杂的软件生态系统,而非像电力一样的简单商品。

- LLMs 是软件,可轻松复制、粘贴、操控、修改、分发、开源、窃取等,并非物理基础设施。

- 由于不同领域的功能、性能、风格、能力等存在差异,会产生一定的切换摩擦

- 系统/用户(提示空间≈内核/用户(内存)空间)

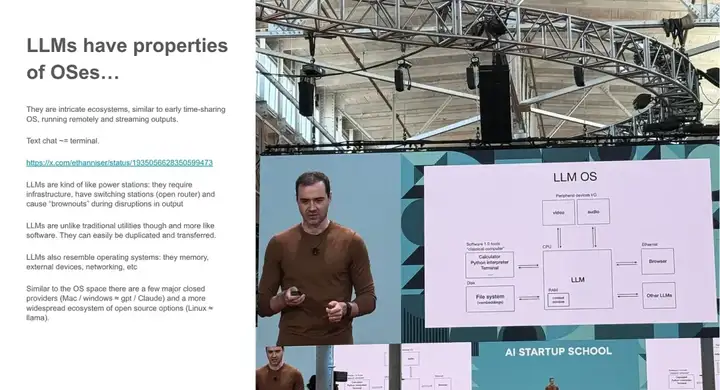

LLMs 具备操作系统的属性

- 它们如同复杂的生态系统,类似早期的分时操作系统,通过远程运行并流式输出内容。

- 文本聊天功能相当于终端界面。

- LLMs 有点像发电站:需要基础设施,有变电站(Open Router),输出中断时会导致「电力不足」。

- 不过, LLMs 不同于传统公用事业,更像软件,可轻松复制和传输。

- LLMs 也类似操作系统:具备内存、外部设备、网络等功能。

- 与操作系统领域类似, LLMs 有少数主要的闭源供应商(Mac/Windows 相当于 GPT/Claude),以及更广泛的开源生态系统(Linux 相当于 Llama)。

2.4 LLMs 类似分时大型机

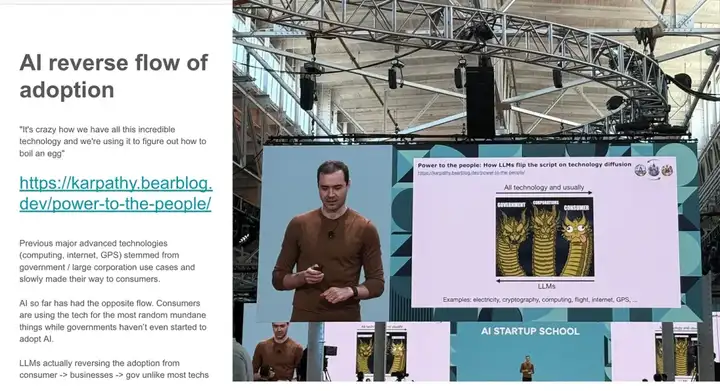

尽管 Andrej 在《Power to the People》中提出, LLMs 还呈现出前沿技术发展的反常趋势:通常昂贵的前沿技术会按既定路径演进,但 LLMs 却打破了这一常规。

「我们拥有所有这些令人难以置信的技术,却在用它来研究如何煮鸡蛋,这太疯狂了。」—— 链接:https://karpathy.bearblog.dev/power-to-the-people!

以往的重大先进技术(如计算、互联网、全球定位系统)通常起源于政府或大型企业的应用场景,随后才逐渐普及到消费者层面。但 AI 的发展路径却恰恰相反:消费者正在将这项技术用于最随机、最平凡的事情,而政府甚至尚未开始采用 AI 。

与大多数技术不同,LLMs 的应用路径实际上是从消费者到企业,再到政府的逆向普及。

随着我们从云端计算转向个人 / 私有 AI ,Exo Labs 的研究成果与苹果 MLX 框架的工作正孕育着 「个人计算 2.0 时代」 的萌芽。

第一部分总结

LLM 实验室:

- 晶圆厂式 LLMs

- LLMs 相当于(20 世纪 60 年代的)操作系统

- 可通过分时共享方式获取,像公用事业一样分布式供应

新动态:数十亿人突然能够使用 LLMs ! 现在是我们为它们编写程序的时代。

03

LLM 心理学

LLM 是「人的精神」:对人的随机模拟,带有一种新兴的「心理学」

Andrej 指出当前 LLMs 在模拟人类时存在两大问题:

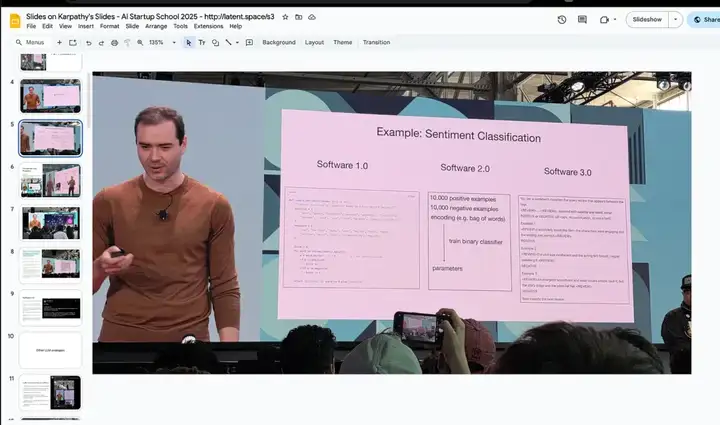

3.1 锯齿状智能(Jagged Intelligence)

这个术语用于描述一种(奇怪且反直觉的)现象:最先进的 LLMs 既能完成极其复杂的任务(如解决高等数学问题),又会在一些简单问题上栽跟头。例如,前两天有个例子——「9.11 和 9.9 哪个更大?」模型给出了错误答案。

某些任务(按人类标准)完成得极为出色,另一些任务却会彻底失败,二者的边界并不总是清晰可辨,尽管长期使用后能积累一定预判直觉。

与人类不同,人类的许多知识和解决问题的能力都是高度相关的,并且从出生到成年都是线性提高的。

我个人认为这些不是根本问题。他们需要在整个堆栈中做更多的工作,而不仅仅是扩展。 我认为最大的问题是目前缺乏「认知自我知识」,这需要更复杂的模型后训练方法,而不是天真的「模仿人类标记者并使其变大」的解决方案,这些解决方案大多让我们走到了这一步 。

有关我所说的内容的示例,请参阅 Llama 3.1 论文中关于减轻幻觉的部分:https://x.com/karpathy/status/1816171241809797335

目前,这是需要注意的事情,尤其是在生产环境中。将 LLM 用于他们擅长的任务,但要注意锯齿状边缘,并让人工参与其中。

3.2 顺行性遗忘症(Anterograde Amnesia)

我喜欢这样解释:LLMs 有点像患有顺行性遗忘症的同事——一旦培训结束,他们就不会巩固或建立长期的知识或专业技能,他们所拥有的只是短期记忆(上下文窗口)。在这种情况下,很难建立关系或工作。

我看到的第一个弥补这种缺陷的方法是 ChatGPT 中的记忆功能,它感觉像是未来可能性的原始粗糙实现,这让我在此提出它可能成为一种新的学习范式:

- 我们缺少(至少一个)LLM 学习的主要范式。不确定该怎么称呼它,可能它有一个名字 - 系统提示学习 ?

- 预培训是为了获取知识。

- 微调 (SL/RL) 适用于塑造习惯性行为。

- 这两者都涉及参数的变化,但人类的学习过程往往更像是系统提示词的更新。你遇到一个问题,弄清楚一些事情,然后以相当明确的方式 「记住」 一些东西,以便下次使用。例如,「似乎当我遇到这样那样的问题时,我应该尝试这样那样的方法/解决方案」。这感觉更像是为自己做笔记,即类似于 「记忆 」功能的东西,但不存储每个用户的随机事实,而是一般/全局的问题解决知识和策略。LLM 就像《记忆碎片》中的那个家伙,只是我们还没有给他们一个便笺簿。请注意, 这种范式在效能和数据利用率上显著更强——因为知识引导的「复盘」阶段提供的反馈维度,远比单一的奖励标量丰富得多。

- 在我看来,这类问题解决知识不该通过强化学习固化到权重中,至少不该立即/完全依赖这种方式。它更不应该来自工程师手工编写的系统提示词。正确的来源应该是系统提示学习——虽然框架类似强化学习,但算法不同(文本编辑 vs 梯度下降)。LLM 系统提示的很大部分可以通过这种学习自动生成,就像 LLM 为自己撰写问题解决指南。若成功,这将形成全新且强大的学习范式。当然还有大量细节待探索:编辑机制如何运作?能否/应该学习编辑系统?如何像人类那样将显性知识逐渐转化为习惯性权重?等等。

04

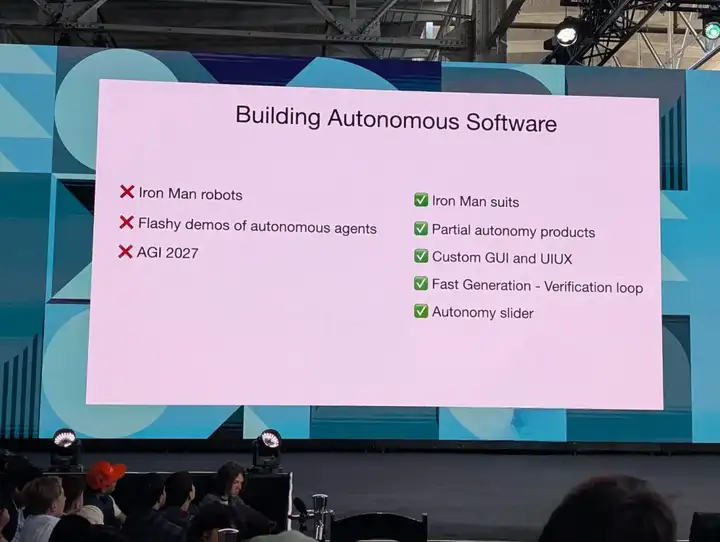

部分自主性设计

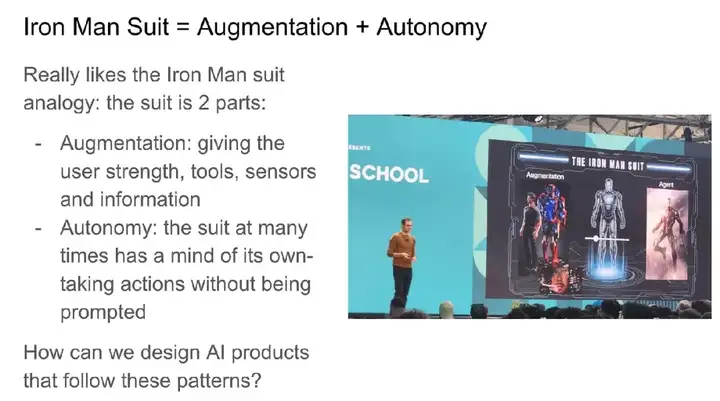

我们喜欢钢铁侠战衣的类比——这套装备在两方面拓展了人类能力:

- 增强:为用户提供力量、工具、传感器和信息

- 自主性:西装很多时候都有自己的想法——在没有提示的情况下采取行动

我们如何设计遵循这些模式的 AI 产品?

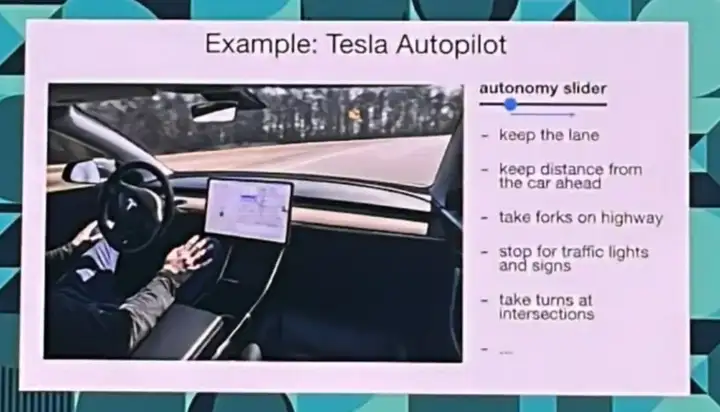

4.1 自主性调节滑块(Autonomy Sliders)

Autonomy Slider 是一个重要的概念,它让我们能够根据具体情境选择自主程度,例如:

- Cursor :Tab -> cmd+K -> Cmd+L -> Cmd+I(agent 模式)

- Perplexity: search -> research -> deep research

- Tesla: Autopilot 自动驾驶仪:1 级至 4 级

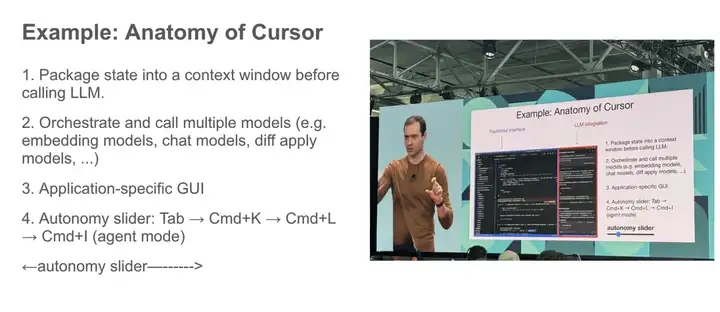

Cursor 的架构解析

- 在调用 LLM 前,将相关状态信息封装到上下文窗口中。

- 对多种模型进行编排与调用(例如嵌入模型、聊天模型、差异应用模型等)。

- 专用应用图形用户界面(GUI)。

- 通过按键组合(Tab - Cmd+K_Cmd+L->Cmd+l)实现从普通模式到 Agent 模式(agent mode)的切换,对应自主性调节滑块的功能。

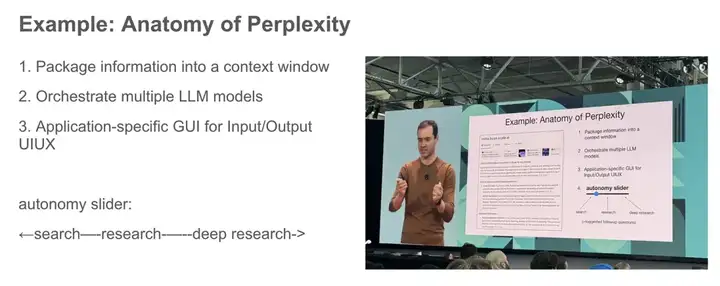

Perplexity 的架构解析

- 信息封装至上下文窗口

- 多 LLM 模型的协同调度

- 针对输入/输出交互设计的专用应用图形用户界面(GUI)

自主性调节滑块:←搜索——研究——深度研究→

特斯拉自动驾驶(Autopilot)的自主性调节示例

- 车道保持

- 与前车保持车距

- 高速公路岔路口选择

- 交通信号灯和标识识别停车

- 路口转弯

4.2 人类与 AI 的生成-验证循环

在生成<->验证的循环中,我们需要一个具备部分自主性的完整工作流程——循环速度越快越好

- 提升验证效率:简化流程,快速制胜

- 为了提升生成质量:严格控制 AI

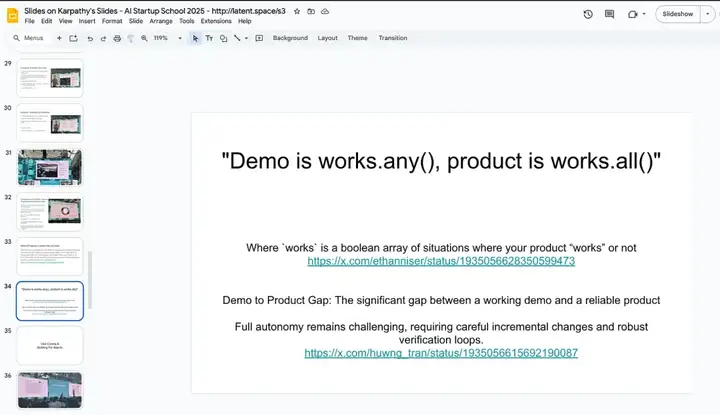

4.3 演示和产品的差距

我们需要部分自主性的原因在于,演示原型与可靠产品之间仍存在巨大差距。

他回忆道,2014 年曾乘坐过一辆全程零干预的 Waymo 原型车,当时认为自动驾驶时代「已经到来」...但后来发现仍有大量技术难题亟待解决。

「演示是 works.any(),产品是 works.all()」

05

Vibe Coding & 为智能体而构建

这条推文催生了上千家初创公司:

现在甚至有了自己的维基百科页面 !

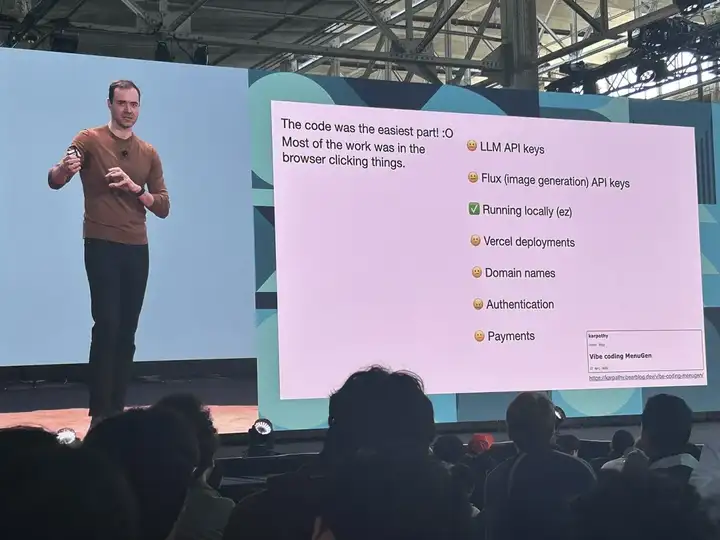

但是,仍存在诸多待解难题。当 Vibe 为 MenuGen 编写代码时,他发现本地代码运行后不久,AI 加速效果就消失了:

在 2025 年,构建 Web 应用的现实状况是一团支离破碎的服务集合——这些服务的设计显然是为了让 Web 开发专家继续保住饭碗,而几乎没有向 AI 敞开大门。

可怜的 Clerk 遭到了负面评价,而 Vercel 的@leerob 则获得了好评,这体现在他们的文档编写方式分别针对人类用户和 AI Agent 所做的不同优化上。

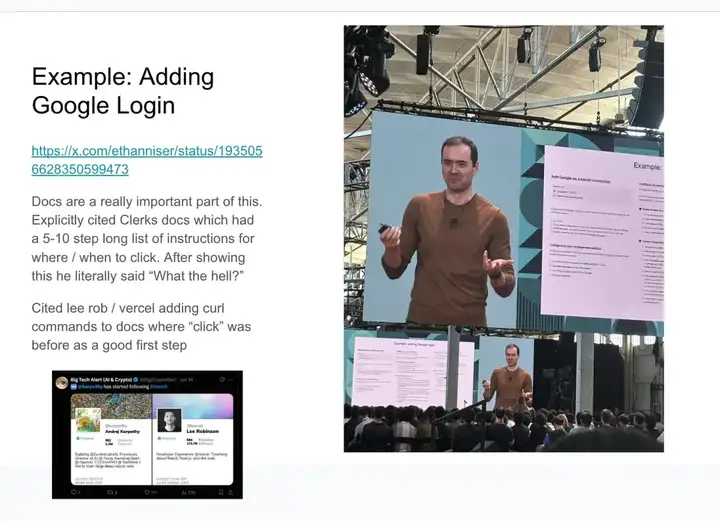

示例:添加谷歌登录

文档在这一过程中至关重要。有人明确引用了 Clerks 文档,其中包含 5-10 步的详细操作说明,标注了点击位置和时机。展示完文档后,他直接说了句「这搞什么?」.

Lee Rob(来自 Vercel)将之前文档中「点击」类操作改为添加 curl 命令的做法,被视为很好的第一步。

他还特别提到了「上下文构建者」类工具,比如我们曾在闪电播客中报道过的 Cognition 公司 DeepWiki。

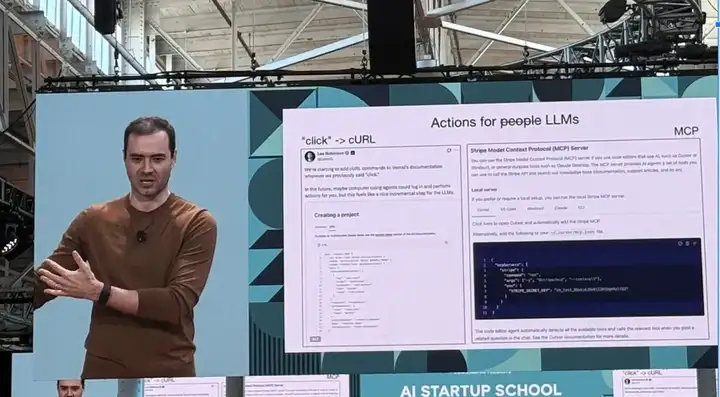

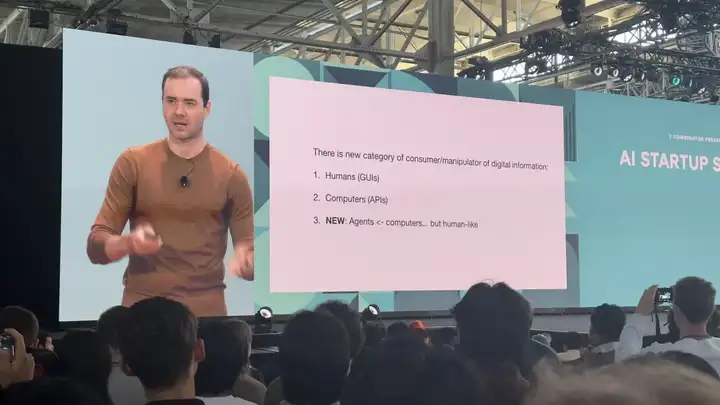

关键在于,工具开发者必须意识到「数字信息的消费者和操纵者出现了一个新类别」:

- 人类(图形用户界面)

- 计算机(API)

- 新概念:智能体 <- 计算机... 但具有类人特性

总结

少谈 2027 年实现通用人工智能,少做华而不实的演示。

更多部分自主功能、自定义图形界面和自主程度调节滑块。

请记住,软件 3.0 正在吞噬软件 1/2,它们的效用/晶圆厂/操作系统特性将决定其命运,改进生成器-验证器循环,并为智能体而构建 🤖

06

其他嘉宾的精彩分享

6.1 Y Combinator CEO: Garry Tan

1. 今年 Y Combinator 的录取率为 0.8%,独角兽公司比例高达 12%。

2. Garry Tan 分享 Y Combinator 青睐的创业者特质:

- 务实,注重实际行动

- 与用户保持密切沟通

- 高效行动

- 将创业过程看作是一场力量的壮举

- 懂得复利的价值,对长期发展保持耐心

3. Garry 的核心观点:

- 自主性决定规模,创业者的自主能动性越大,事业拓展空间也越大。

- 外部工具变迁,但成功所需的基本心智和原则始终如一。

6.2 OpenAI CEO: Sam Altman

1. Sam曾犹豫是否创立 OpenAI,当时通用人工智能(AGI)是遥不可及的梦想,且 DeepMind 等竞争对手遥遥领先。但坚持下去的微小决定,彻底改变了这一切。

2. ChatGPT 起初听起来像是纯粹的科幻概念,这使得它更容易吸引顶尖人才。成为独一无二比在拥挤的空间中竞争更好。

3. 如果你只是跟风,那要招募到优秀人才将异常艰难。因此,要追求大胆且与众不同的方向。

4. 伟大的想法在开始时往往微不足道。但如果方向正确,一旦取得突破,潜力将巨大。

5. 一个实用的思维模式是:选择一个价值 $0 亿而不是 $0 百万的想法。你需要的是高潜在回报。

6. 我们对当前模型的能力还只是冰山一角。未来还有巨大的「产品溢出」空间,而且性价比将继续快速提高。

7. 到目前为止,Sam最喜欢的功能是记忆。它预示着一个未来:个人 AI Agent 能够连接到你的各项服务,并主动提供信息和帮助。

8. OpenAI 的愿景是打造一个全天候在线的个人助理,它能整合记忆、多模态能力并进行可信决策。

9. OpenAI 正在构建一个 Agent 商店——ChatGPT 将演变为一个平台,为第三方工具输送流量。

10. 不要试图通过构建另一个核心聊天助手来正面竞争。最好的创业点子,往往是那些当下无人涉足的领域。

11. 埃隆曾说 GPT-1 是垃圾。 彼得·蒂尔(Peter Thiel)也告诉 Sam,当所有人都不看好时,坚持信念很难。但 Sam 认为,只要坚持下去,事情会随着时间变得更容易。

12. AI Agent 是下一波浪潮。首先,ChatGPT 取代了 谷歌 的部分功能;接着,Codex 扮演了初级开发人员的角色;现在,AI Agent 将能运行完整的复杂工作流程。

13. 世界正在被重塑,包括界面、软件、硬件,甚至制造业。这是有史以来最好的创业时期。

14. 技术的发展轨迹意味着一个人现在可以完成以前整个团队才能完成的工作。因此,要以低成本快速迭代。

15. 招聘那些聪明、有冲劲、且学习成长曲线陡峭的人才,能让你完成 90% 的工作。更要关注他们的 潜力(坡度),而非当前的 完美(完善度)。

16. Sam 说,担任 OpenAI 首席执行官是最困难的,因为他必须掌握大量背景信息,且必须同时应对多重事务。

17. 未来 10-20 年,最令他兴奋的是 科学领域的 AI 应用。

18. 生活水平与人均能源之间存在很强的相关性。这可能比人们想象的更重要。

19. Sam 希望早点学到的一件事是:相信你的直觉。即使你的想法听起来很奇怪,也要有坚定的信念。

6.3 Anthropic 联合创始人:Jared Kaplan

1. 缩放定律——即测试损失如何随模型大小、数据和计算的幂律下降——已经成为了现代 AI 的基石,也是 OpenAI、Anthropic 和 谷歌等巨头的核心指导原则。

2. 2024 年的关键问题在于,这条定律是否也适用于强化学习。早期迹象表明:答案是肯定的。

3. Jared 说,如果缩放效应停止,并非是定律本身失效,而是因为我们在实施过程中出现了瓶颈。。

4. 一个关键指标:AI 模型能完成的任务长度每 7 个月便翻一番,且这种趋势正在加速。

5. 随着模型灵活性提高,它们能为人类节省更多时间。我们正在迈向更长、更复杂的任务链。

6. AI 领域尚待解决的问题包括:深化知识、增强记忆、完善监督机制、实现多模态集成、将能力扩展到更大规模任务以及更紧密的数据协作。

7. 人类数据将持续发挥重要作用,尤其对于提升更长任务表现和记忆能力至关重要。

8. 机械可解释性仍然存在巨大差距。许多基本问题仍未解决。这门学科更接近神经科学而不是工程学。

9. 但我们可以测量模型中的一切。大型语言模型(LLMs)产生了前所未有的大量可观察数据,可以用于认知逆向工程。

10. AI 需求随 AI 供应增长。个人和企业使用它的意愿就越强。

11. 下一波创业浪潮正从辅助性的「协作者(copilots)」转向直接的「替代者(direct replacements)」,尤其是在对一定错误有容忍度的领域。

12. 他对创始人的建议:

- 构建尚未完全成熟的产品

- 思考指数级增长的机会可能在哪

- 准备好深入整合 AI 到实际场景中,

13. 金融、法律 和面向现有业务的 AI 是有前景的领域。这些领域既有较高的错误容忍度,又对自动化有强烈需求。

6.4 Ndea CEO: François Chollet

1. 仅仅依靠模型规模的扩大并不能解锁流动智能(fluid intelligence)。运行时(runtime)的自适应行为并非通过预训练更大的模型就能自然涌现。

2. 对通用人工智能(AGI)有两种愿景:

- 明斯基(Minsky)派:认为 AGI 旨在自动化人类任务。

- 麦卡锡(McCarthy)派:认为 AGI 的核心是测试时的适应性。

第二种愿景更具挑战性,也更为重要。

3. 智能的体现应该是创新,而不仅仅是自动化。技能才是智能的产物。

4. 人类考试是糟糕的基准,因为它们奖励的是死记硬背。我们真正需要的,是具备流动性、广泛操作范围和信息效率的模型。

5. 模型会根据其训练目标进行优化。如果你用考试数据训练,模型就会倾向于记忆。但如果目标是创新,你就需要着眼于泛化能力和适应性。

6. 真正的通用智能 需要从过往经验中提炼出抽象概念,并能即时地将它们重新组合,以应对全新任务。这些抽象概念有两种形式:

- 类型 1-价值层面:通过聚类具体示例来形成模式。

- 类型 2-程序层面:通过组合函数来构建逻辑。

7. Transformer 模型在处理类型 1 抽象方面表现卓越。但要实现流动智能,我们需要利用 类型 1 的直觉来有效地缩小类型 2 的可能性空间。需要构建能够执行离散程序搜索的系统:

- 包含运算符/函数的图结构。

- 通过组合搜索进行学习。

- 通过校正循环进行验证。

8. 核心挑战在于函数组合的组合爆炸。流动通用人工智能必须运用类型 1 的直觉来有效缩小这个搜索空间。

6.5 DeepMind 杰出科学家兼诺贝尔奖获得者:John Jumper

1.在机器学习(ML)中,架构和设计决策对性能的影响往往比仅仅扩展数据大 100 倍。真正的进步取决于洞察力,而不是蛮力。

2.AlphaFold 已被引用 35K 次以上。它证明了小型、专注的团队如何通过正确的想法来增强数据和计算的影响力。

3.不要为了追求形式上的优雅而牺牲实际的进展。美感可以稍后雕琢,成果才是第一位的。

4.为你的 ML 系统定义一个清晰、聚焦的目标。一个领域的突破往往不具备普遍性。例如,AlphaFold 不能直接用于模拟分子动力学。

5.选择构建什么时,问自己一个问题:「我需要预测什么,才能真正打动你?」这就是你的方向。

6.降低失败实验的成本,是提高迭代速度的关键。小规模测试能带来更快的学习。

7.进行大量的小规模实验,并定期进行大规模验证。像梯度下降一样,持续迭代你的想法。

8.开源工具能够放大你的影响力,让更多人能在你的工作基础上进行构建。

9.确保你正在构建的系统是人们需要的。缺乏实际需求,技术上的成功将毫无意义。

6.6 Perplexity CEO: Aravind Srinivas

1. 「我喜欢观看埃隆·马斯克(Elon Musk)的励志视频。」

2. Perplexity 的长远愿景是打造一个集成 AI Agent 的浏览器——旨在并行运行异步任务,并能访问服务器端模型无法获取的信息。

3. 他们的优势在于专注于搜索和浏览器,而不是像 OpenAI 那样追求通用聊天,或者像 谷歌 那样坚持广告驱动的模型。

4. 谷歌在改进核心搜索方面的激励机制很差,因为它们的广告业务运作方式。但创业公司可以更快地行动,并通过 OpenAI 或 Anthropic 的 API 访问更好的模型。

5. Aravind最初尝试构建更好的推特搜索功能,后来才转向了 Perplexity 如今的方向。

6. 产品的持续使用,即在稳定状态下的用户留存率是判断产品真正奏效的最强信号。

7. Perplexity 即将推出的浏览器产品将能够访问云模型无法访问的数据,这使其在知识检索方面具有独特的优势。

8. 关于如何利用 AI 进行开发,Aravind 认为「Vibe coding」是不够的,还需要理解分布式系统等核心概念。

9. 在 Perplexity,工程师被要求至少使用一种 AI 编码工具(例如 Cursor)

10. 「Vibe coding」在前端任务中表现很好,但对更深层次的系统理解仍然很重要。

11. Aravind 对待挫折的看法:「观看埃隆·马斯克的励志视频。」

12. Aravind 对于 AI 创业公司的看法:AI 初创公司需要 2-3 年才能获得真正的市场关注。这是一场持久战。

6.7 斯坦福大学 AI 研究员&World Labs 创始人:李飞飞

1.语言纯粹是生成性的,但世界不是。智能必须扎根于感知,而不仅仅是预测。

2.李飞飞最优秀的学生都有一个共同的特质:无畏的求知精神,敢于提出根本性问题并有追求大胆构想的勇气。

3.「有一段时间,我感觉自己像个机器人。但技术应该让我们更人性化,而不是更少。」

4.我们的目标不是取代人类,而是提升我们。

5.「你只管去做就好。」

6.8 特斯拉/SpaceX CEO:Elon Musk

1. 「我从没想过自己能做出什么技术上极其伟大的东西。从概率上讲,这似乎不太可能。但我至少想尝试一下。」

2. 谈及创业的开端,Elon Musk 曾向 Netscape 投递简历,但石沉大海。于是他决定自己动手——最终创办了 Zip2。

3. Zip2 在发展过程中受到了董事会利益冲突,特别是来自传统媒体的阻力。带来的教训是:不要让自负或政治因素阻碍反馈。

4.「不要追求荣耀,要追求工作本身。」

5. 如果团队中自我意识与能力的比例过高,创新就会停滞。

6. 谈及成功,Elon Musk 表示要理性看待自我。不惜一切代价把事情搞定。

7. 第一性原理思维(First principles thinking):从最基本的真相出发,向上推导。在零或无穷的极限下思考,以发现事物的特殊情况。

8. 2001 年,Elon Musk 曾试图从俄罗斯购买洲际弹道导弹。当谈判失败后,他决定自己制造火箭。这是 SpaceX 的缘起。

9. 为何离开 Dogecoin:「这就像在清理一个满是垃圾的海滩,同时却有一场千尺高的 AI 海啸正在逼近。是时候把精力放在那场海啸上了。」

10. Grok-3.5 正在训练中,它将是一款推理模型。

11. Elon Musk 相信,超级智能可能会在今年或明年出现。

12. Neuralink 的首批视力植入物将在 6-12 个月内进行人体测试。此前,一只猴子已使用该植入物超过 3 年。

13. 地球距离卡尔达舍夫(Kardashev) Level 1,即能利用其行星全部能源潜力,仅需 1%-2% 的路程。

14. 火星:预计需要 30 年才能建成一个自给自足的殖民地。

15. 我们不太可能只有一个占主导地位的智能。更有可能的是,未来将有大约 10 个主要的 AI 实体——其中 4 个将在美国。

文章来自于“Founder Park”,作者“Founder Park”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0