最近,Ai2耶鲁NYU联合推出了一个科研版「Chatbot Arena」——SciArena。全球23款顶尖大模型火拼真实科研任务,OpenAI o3领跑全场,DeepSeek紧追Gemini挤入前四!不过从结果来看,要猜中科研人的偏好,自动评估系统远未及格。

如今,用AI大模型辅助写论文早已成为科研工作者的家常便饭。

ZIPDO 2025教育报告显示,AI已经无缝融入70%的研究实验室,并在五年内推动相关科研论文数量增长了150%。

AI在辅助科研的路上一路狂飙,但一个关键问题却长期悬而未解:

「大模型科研能力究竟怎么样?」

传统benchmark静态且片面,难以衡量科研任务所需的上下文理解与推理能力。

为此,Ai2联合耶鲁大学和纽约大学推出了科研界的Chatbot Arena——SciArena,正式开启科学智能的「擂台赛」时代!

论文链接:https://arxiv.org/pdf/2507.01001

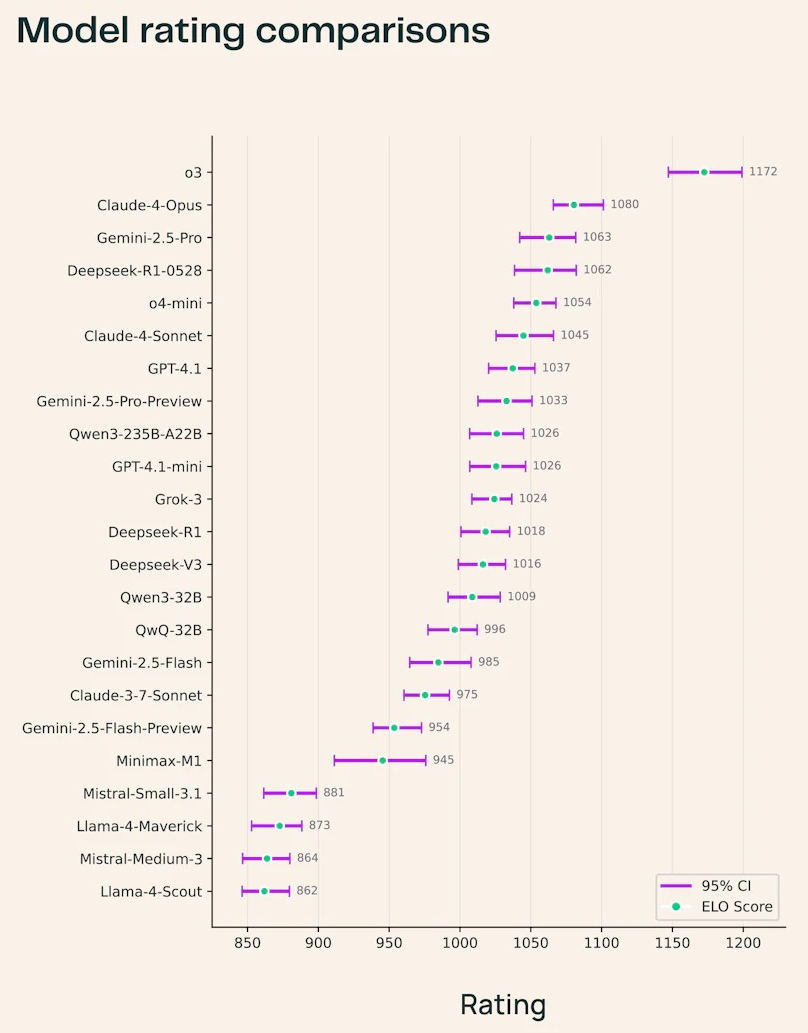

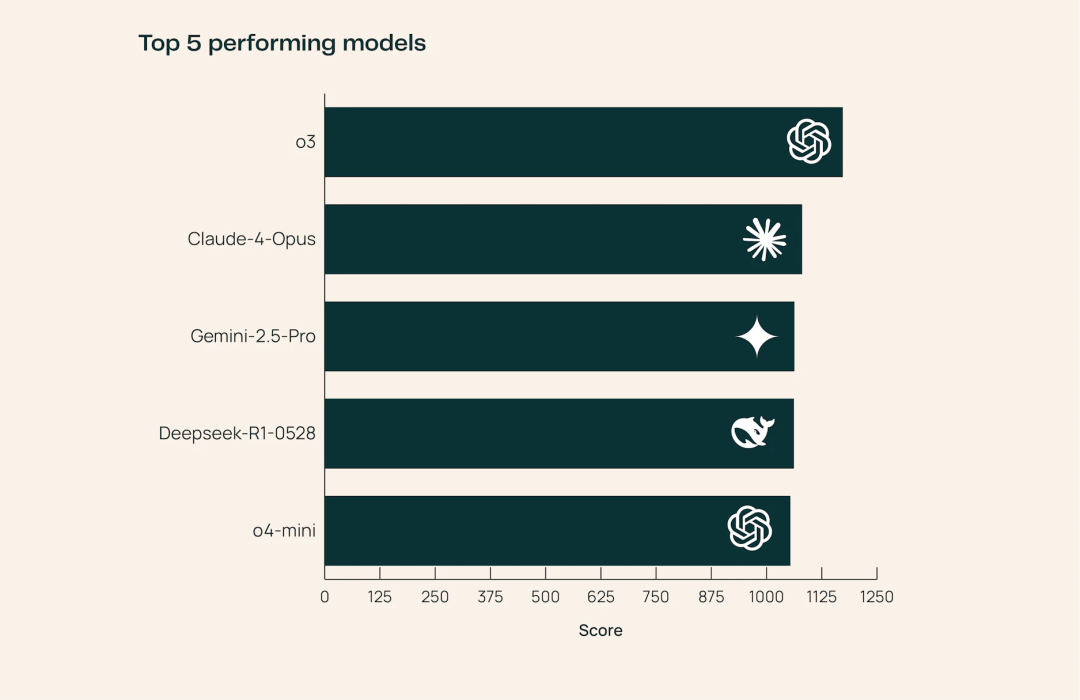

目前,已有23个最前沿的大语言模型登上SciArena的擂台,涵盖OpenAI、Anthropic、DeepSeek、Google等巨头产品。

其中,OpenAI o3断崖式领先,坐上了科学任务的头把交椅,在所有科学领域都稳居第一,输出的论文讲解也更有技术含量。

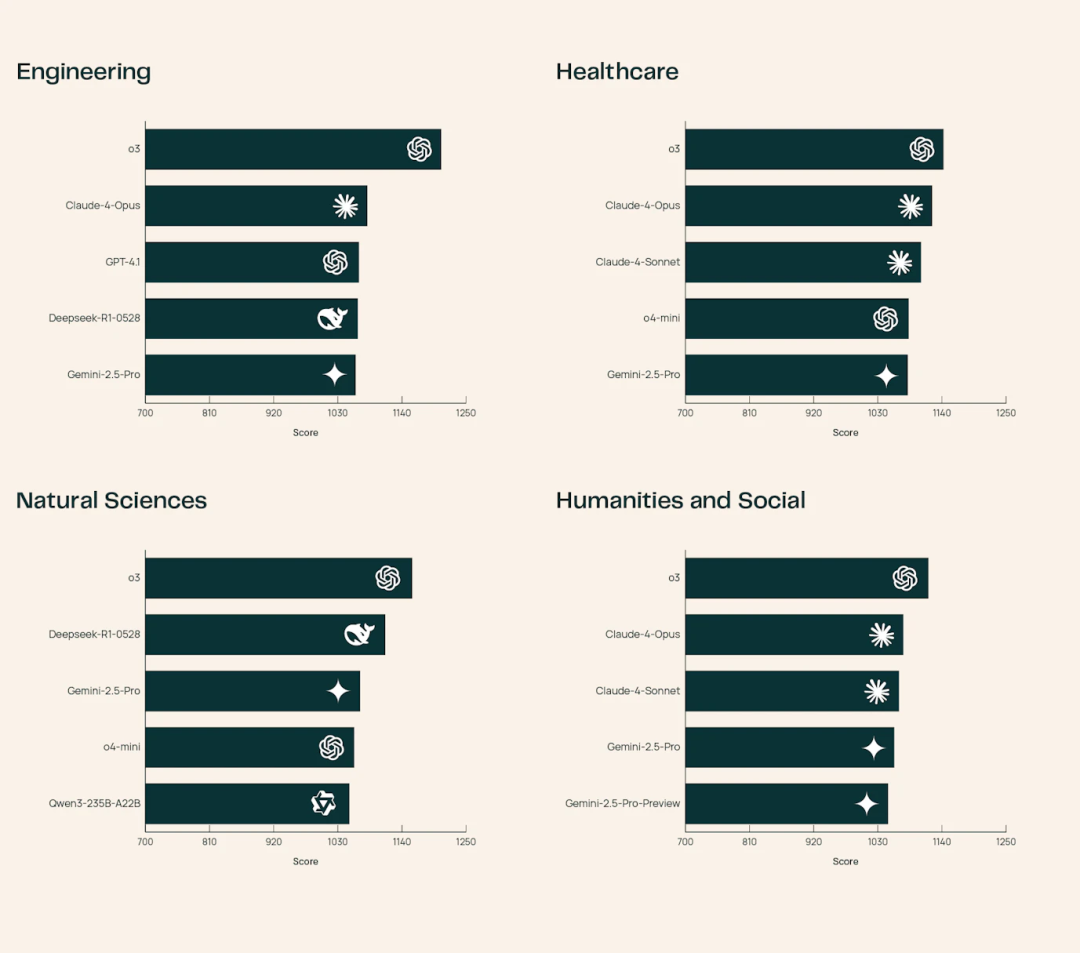

其他模型在不同领域各有千秋:

例如Claude-4-Opus的医疗健康知识很强,而DeepSeek-R1-0528在自然科学表现抢眼。

值得一提的是,SciArena刚发布没多久就得到了Nature的特别报道,并被盛赞为「解释大模型知识结构的新窗口」。

下面我们就来看看,评估基础模型科研能力,SciArena究竟靠谱在哪里?

SciArena:科研AI新「试金石」

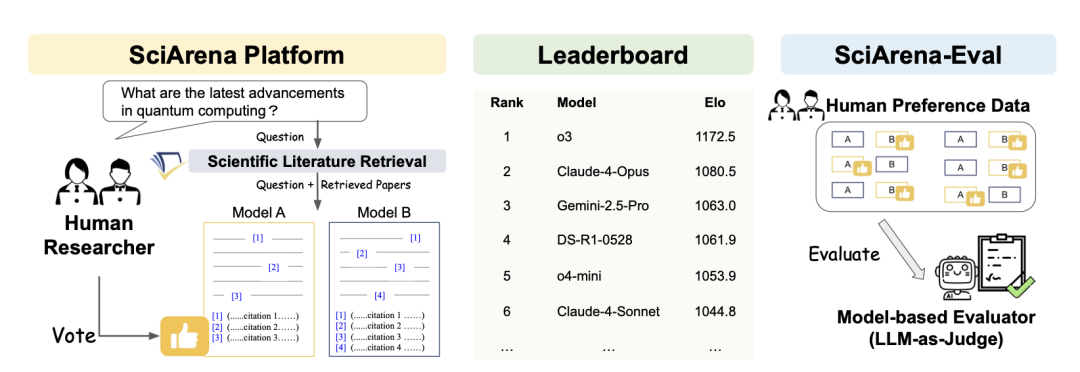

SciArena是首个专为科学文献任务量身定制的大模型「开放式评估平台」。

在这里,科研人员可以对不同基础模型处理科学文献任务的表现进行比较和投票。

团队引入了Chatbot Arena式的众包、匿名、双盲对决机制,用真实科研问题来验货大模型。

SciArena专门针对科学探究的复杂性与开放性进行了优化,解决通用基准测试在科研场景中「失效」的问题。

该平台主要由三大核心组件构成:

- SciArena平台: 科研人员在此提交问题,并「同台对比」查看不同基础模型的回复,选出自己更偏好的输出。

- 排行榜: 平台采用Elo评分系统对各大模型进行动态排名,从而提供一份实时更新的性能评估报告。

- SciArena-Eval: 基于SciArena平台收集的人类偏好数据构建的元评估基准集,其核心目标是检验用模型来猜测人类偏好的准确性。

对决背后:评测机制大揭秘

从提问到投票:SciArena评估全流程

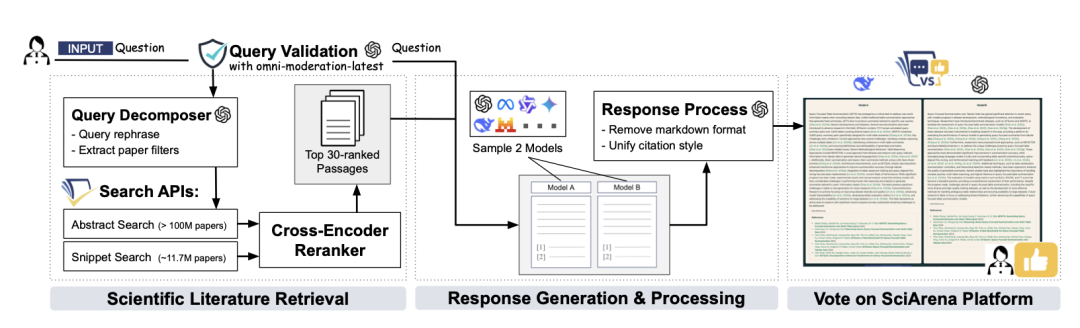

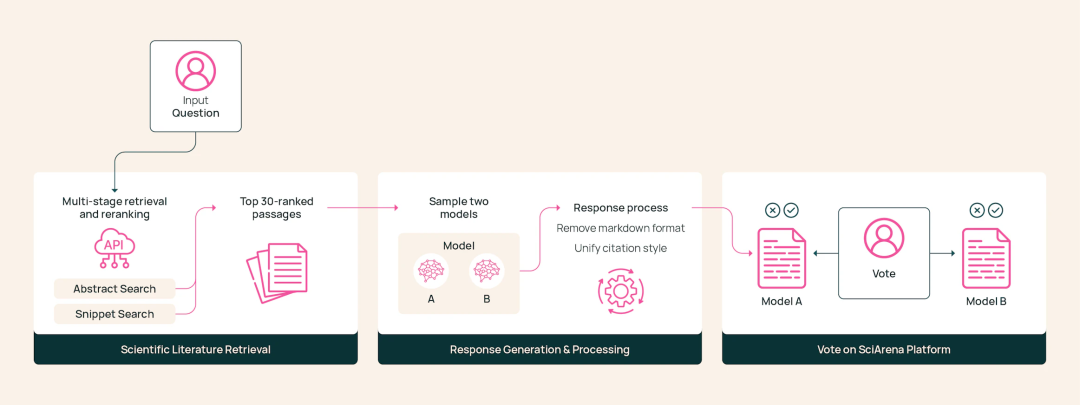

SciArena的工作流程包括检索论文、调用模型回复、用户评估三个环节。

与通用问答相比,科研问答最大的壁垒在于要以严谨的科学文献为依据。

为了确保检索信息的质量与相关性,团队改编了Allen Institute for AI的Scholar QA系统,搭建了一套先进的多阶段检索流水线。

该流水线包含查询分解、段落检索和结果重排序等多个步骤。

收到用户提交的问题后,平台启用流水线,检索相关的科学论文作为上下文。

随后,平台把上下文和用户的问题合在一起,同时发送给两个随机选择的基础模型。

两个模型各自生成内容详实、附带标准引文的长篇回复。

平台会统一处理两份回复,变成格式一致的标准化纯文本,以免用户「认出」模型的回答风格。

最后,用户对这两个纯文本输出进行评估,并投票选出自己偏好的答案。

值得注意的是,SciArena的注意力主要集中于可横向评估的「通用基础模型」。

至于OpenAI Deep Research等定制型智能体或闭源研究系统,则不在平台的考虑范畴内。

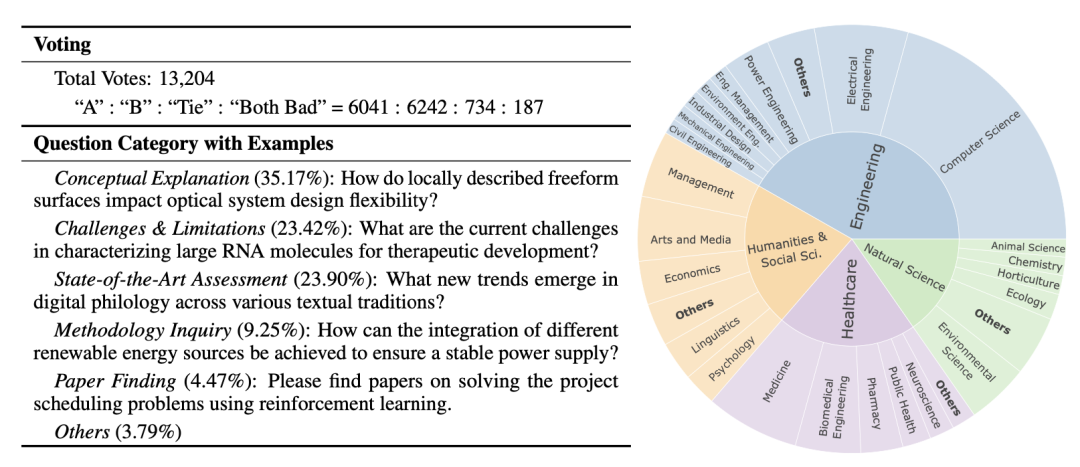

102位专家,13000票

要想评测准,数据必须信得过。

SciArena团队对数据的把关严格得令人发指。

在平台上线的前四个月里,他们收集了不同科研领域的102位专家的13000多次投票。

这102位专家绝非随意参与的路人,而是科研一线的在读研究生,人均手握两篇以上论文。

而且,所有的标注员都接受了一小时的线上培训,确保评价标准一致。

再加上盲评盲选机制,SciArena的每一条评估结果都有据可依。

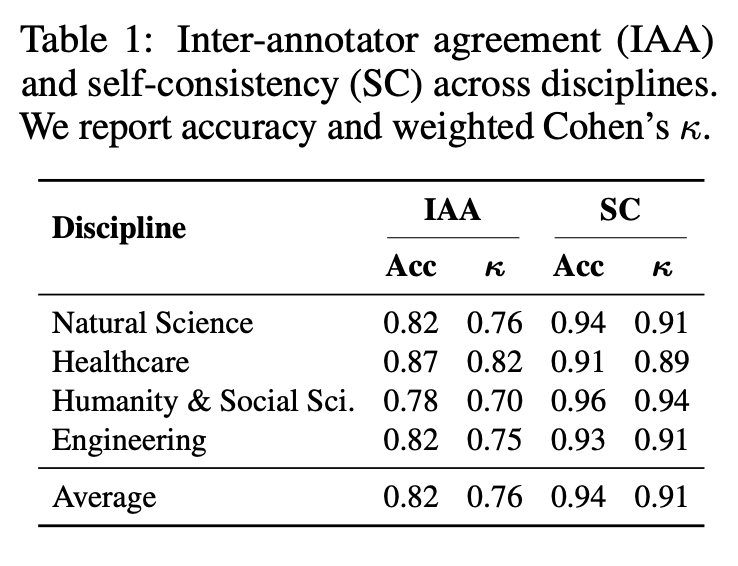

在SciArena的高标准和严要求下,平台的标注数据自我一致性极高(加权科恩系数κ=0.91),标注者间一致性也达到了较高水平(κ=0.76)。

这13000多次投票为SciArena平台打下了值得信赖的评估基础。

最强AI,猜不透科研人的心

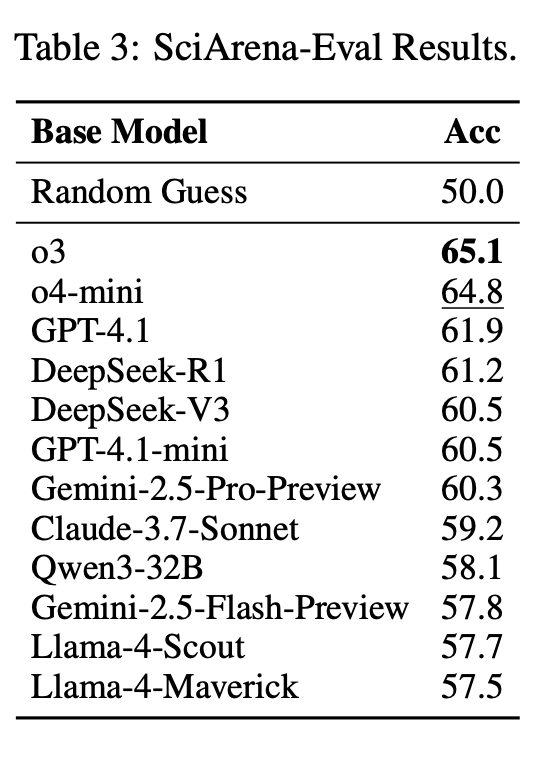

在SciArena平台上,研究团队基于元评估基本集SciArena-Eval,测试了「模型评模型」的自动评估方法:

给一个评估模型一条科研问题和两个模型的回答,让它猜哪个更可能被人类选中。

结果很扎心。

哪怕是表现最好的o3模型,准确率也只有65.1%,而像Gemini-2.5-Flash和LLaMA-4系列,几乎跟「掷硬币选答案」的准确率差不多。

对比一下通用领域,像AlpacaEval、WildChat这些基准的评估模型,准确率都能跑到70%以上,相比之下,科研任务显得难多了。

看来,「让模型理解科研人的偏好」并非易事。

不过也不是全无亮点。

加入了推理能力的模型,在判断答案优劣上普遍表现更好。

例如,o4-mini比GPT-4.1高出 2.9%,DeepSeek-R1也小胜自家模型DeepSeek-V3。

这说明,会推理的AI更懂科研问题的本质。

研究团队表示,SciArena-Eval未来有望成为科研AI评估的「新标准」。

它能帮我们看清AI到底有没有真正「读懂」科研人的心思。

参考资料:

https://allenai.org/blog/sciarena

https://arxiv.org/pdf/2507.01001

https://the-decoder.com/sciarena-lets-scientists-compare-llms-on-real-research-questions/

文章来自于微信公众号“新智元”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md