随着大模型的崛起,AI编程领域正在发生翻天覆地的变化。

各种编程大模型、编程工具涌现,通过自动补全代码、自动 debug 等实用的功能为开发者的日常工作提供极大便利,并在一定程度上提升了开发效率。

不过,问题来了,AI 编程工具带来的影响真是如此吗?

近日,一家非营利性 AI 调研机构「METR」进行了一项随机对照实验,旨在了解 AI 编程工具如何加速经验丰富的开源开发者的工作效率。

结果却是非常令人意外:开发者本来坚信使用使用 AI 工具后速度可以提升 20%,但实际上速度却比没有使用 AI 工具时慢了 19%。这一结论在社交媒体 X 上爆了,阅读量几乎要突破 300 万。

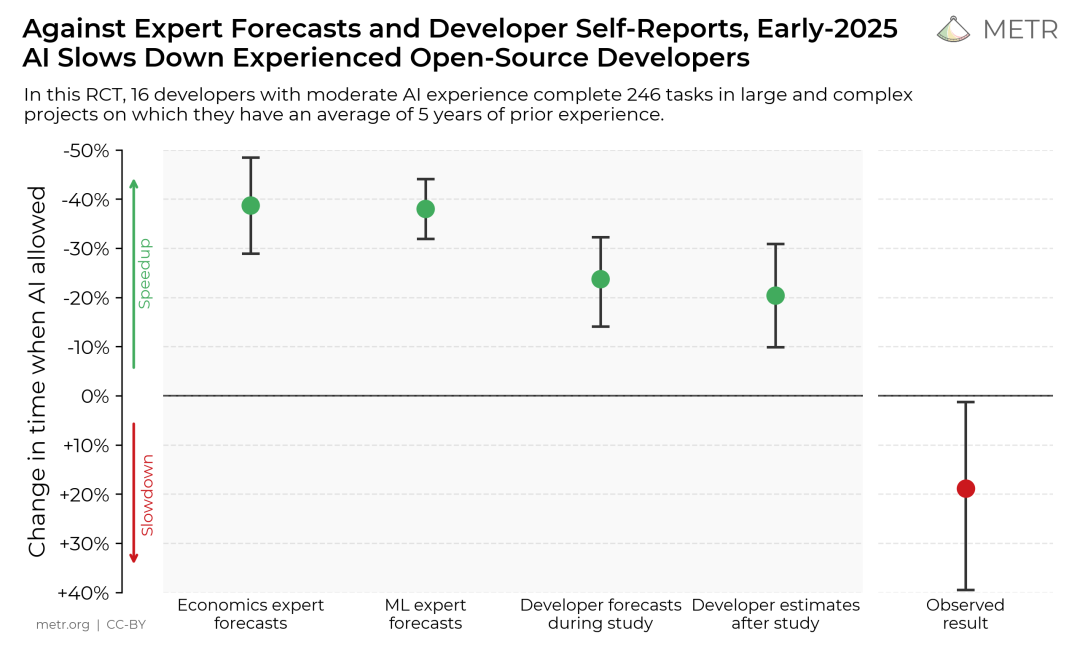

如下图所示:与专家预测和开发者本来的直觉相反,2025 年初的 AI 编程工具将减缓经验丰富的开发者的开发速度。在本次随机对照实验中,16 位拥有中等 AI 编程经验的开发者完成了 246 项大型复杂项目的任务,他们平均拥有 5 年开发经验。

对于这项调研,网友反应不一。有人感同身受,表示赞同。

有人则对 METR 的测量指标产生了质疑,表示「完成任务的时间」不能与「生产力」划等号,并且中等 AI 经验与复杂项目测试同样是糟糕的设置。

「应该调研普通人(非开发者)使用 AI 编写软件的速度快了多少」,也有人提出了这样的建议。

研究动机

虽然编码 / 智能体基准测试已被证明有助于理解 AI 能力,但它们通常为了规模和效率而牺牲了真实性 —— 这些任务自成一体,不需要理解先前的上下文,并且使用算法评估,无法捕捉许多重要的能力。这些特性可能导致基准测试高估了 AI 的能力。

另一方面,由于基准测试是在没有真人实时交互的情况下运行的,模型可能尽管取得了实质性进展却未能完成任务,比如一些在真实场景中人类会轻松修复的小瓶颈。总的来说,直接将基准测试分数转化为现实世界的影响是困难的。

METR 表示,评估 AI 对软件开发人员生产力的影响,可以为基准测试提供补充证据,有助于了解 AI 对 AI 研发加速的整体影响。

方法、结果与原因分析

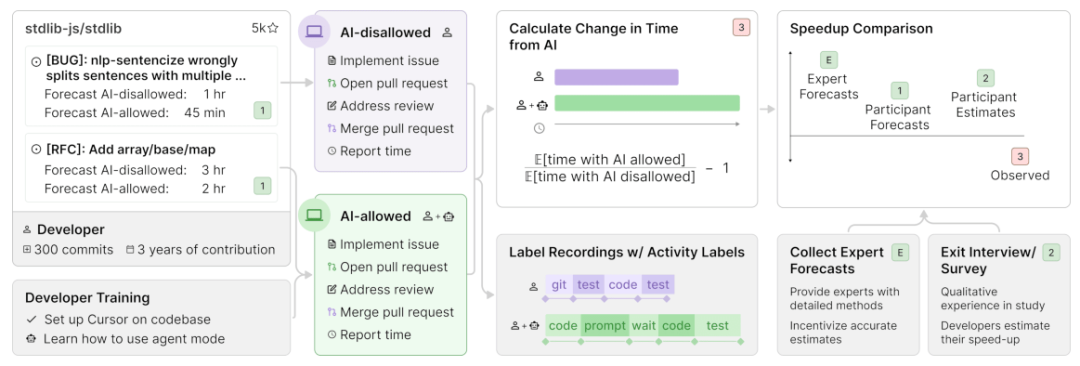

为了直接测量 AI 工具在软件开发中的现实影响力,METR 招募了 16 位经验丰富的开发者,他们来自大型开源仓库(平均拥有 22k+star 和 100 万 + 行代码),并已贡献多年。

这些开发者提供了他们认为对仓库有价值的真实问题列表(总计 246 个)—— 即通常属于他们日常工作范畴的 bug 修复、功能开发和重构任务。

接下来,METR 随机分配每个问题,允许或禁止开发者在处理该问题时使用 AI。当允许使用 AI 时,开发者可以选择他们喜欢的任何工具(研究期间主要使用 Cursor Pro 搭配 Claude 3.5/3.7 Sonnet)。

当禁止使用时,他们则在没有生成式 AI 辅助的情况下工作。开发者在完成任务(平均每个耗时约两小时)时录屏,并自行报告完成所需的全部时间。

当然,METR 按每小时 150 美元(约合人民币 1080 元 / 小时)的标准向开发者支付参与研究的报酬。

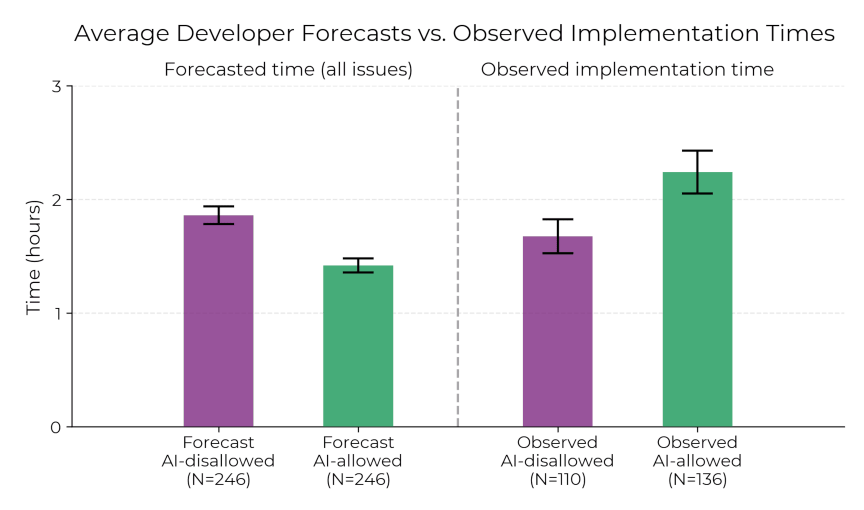

结果显示:当开发者被允许使用 AI 工具时,他们解决问题所需的时间反而增加了 19%—— 这一显著的效率下降与专家预测以及开发者的感知背道而驰。

这种感知与现实之间的差距令人震惊:开发者预期 AI 能将其速度提升 24%,即使在经历了效率下降之后,他们仍然相信 AI 可以为他们提速 20%。

下文展示了开发者预测的平均时间和实际观察到的实现时间。我们可以清晰地看到,当开发者被允许使用 AI 工具时,他们花费的时间明显更长。

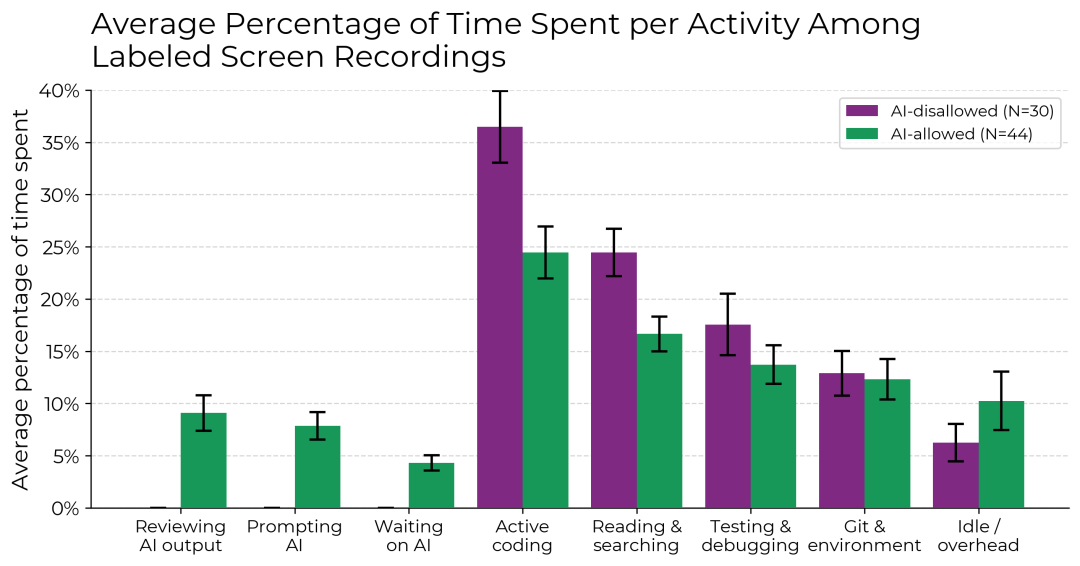

当允许使用 AI 时,开发者在主动编码和查找信息上的时间减少了,取而代之的是花更多时间撰写提示词、等待或审查 AI 输出,以及处于空闲状态。METR 发现,开发进度的放缓并不是单一原因,而是由多种因素共同导致的。

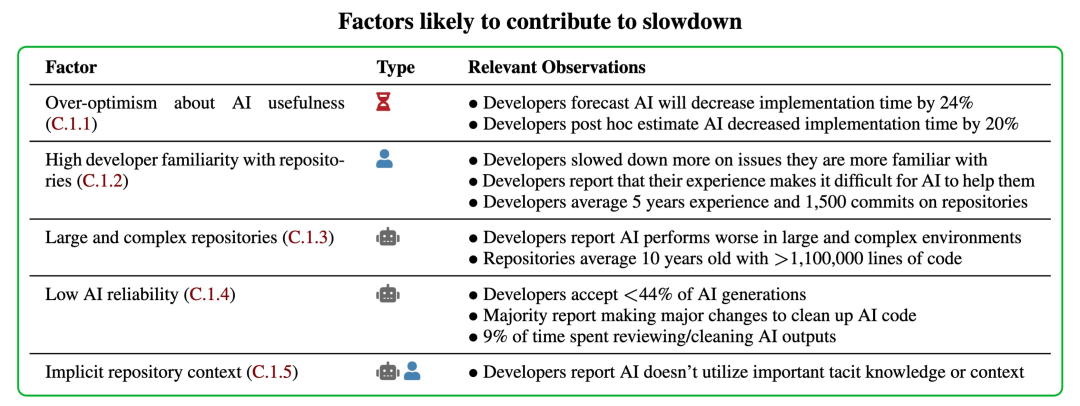

为了更好地理解这些因素,METR 考察了实验环境中的 20 项属性,发现其中有 5 项很可能是造成开发速度放缓的原因,另外有 8 项则表现出混合或不明确的影响。

过程中,METR 排除了许多实验干扰因素,比如开发者使用了前沿模型、遵守了处理分配规则、没有选择性地放弃问题(例如放弃困难的不使用 AI 任务从而降低不使用 AI 组的平均难度),并且在使用和不使用 AI 的情况下都提交了质量相近的 PR(Pull Request)。

结果发现:无论是采用不同的结果指标、估计方法,还是对数据进行各种子集 / 子分析,开发速度的放缓现象依然存在。

更详细的调研结果请参考原论文:

- 论文标题:Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity

- 论文地址:https://metr.org/Early_2025_AI_Experienced_OS_Devs_Study.pdf

局限性与未来展望

此次调研得出了两个重要结论,分别是:

- 在某些重要场景下,近期的 AI 工具有可能并未提升生产力,甚至可能导致效率下降。

- 关于效率提升的自我报告并不可靠 —— 要真正理解 AI 对生产力的影响,我们需要真实环境中的实验数据。

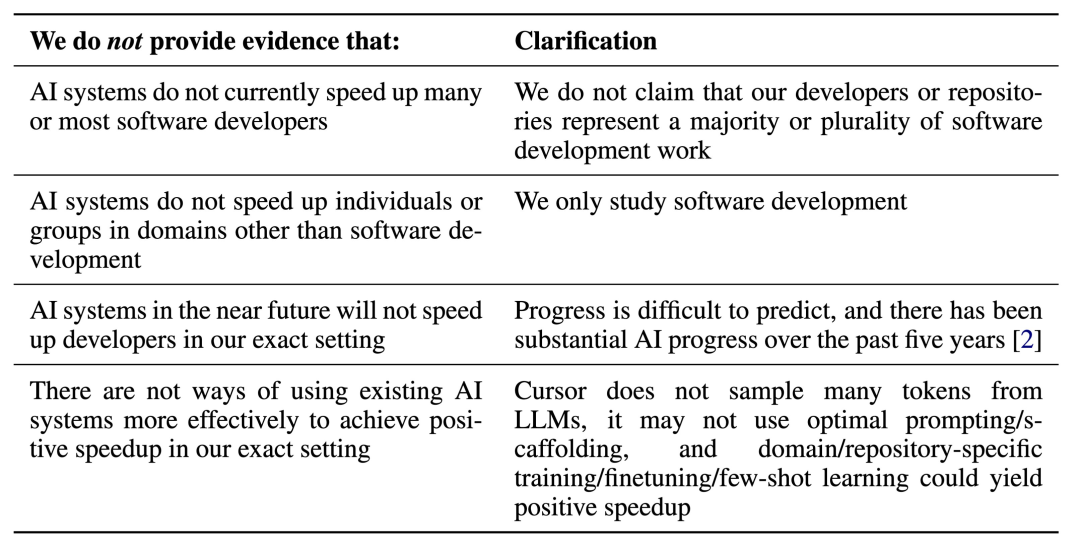

不过,METR 也表示,他们的设置并没有代表所有(甚至可能是大多数)软件工程,同时声明当前的模型也能更有效地利用起来,未来的模型可能会变得更好。

当然,没有哪种测量方法是完美的 —— 人们希望 AI 系统完成的任务是多样、复杂且难以严格研究的。各种方法之间存在有意义的权衡,继续开发和使用多样化的评估方法以更全面地描绘 AI 的现状和未来发展方向,将至关重要。

未来,METR 期待运行类似的 AI 调研,以追踪 AI 带来的加速(或减速)趋势,这类评估方法可能比基准测试更难被「玩弄」。

博客地址:https://metr.org/blog/2025-07-10-early-2025-ai-experienced-os-dev-study/

文章来自于微信公众号“机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0