几百年前开普勒通过观测数据,总结出了行星运动的规律,例如行星沿椭圆轨道运行,这让他能精确预测行星未来的位置。这就像今天的基础模型,通过学习海量数据,可以很好地进行序列预测(比如接下一句话)。

后来牛顿提出了万有引力定律和运动三定律。牛顿的理论不仅能同样精确地预测行星位置,更能解释这背后的根本原因(力、质量、加速度的关系),并且能被应用到行星轨道之外的各种物理场景(比如苹果落地)。这代表了一种从“知其然”到“知其所以然”的飞跃,也就是形成了一个 “世界模型”(World Model)。

自2022年ChatGPT横空出世以后AI浪潮正以前所未有的速度席卷全球,AGI的实现好似就在明天。但在这片喧嚣之中,一个幽灵般的问题始终挥之不去:来自哈佛和MIT的研究者们想知道我们今天强大的基础模型,究竟是像开普勒一样,只是一个高明的预测者,还是像牛顿一样,已经在内部形成了对世界深层结构的理解?这并不是一个轻松的话题,因为这个问题的答案关系到我们对LLM产品开发边界的认知。

归纳偏差探针:一把解锁AI内心的钥匙

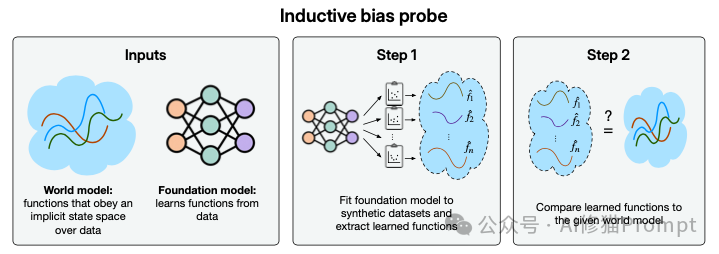

为了回答上述问题,研究者们提出了一种名为 “归纳偏差探针”的评估方法

这个方法的核心思想很简单:研究者认为,我们无法直接“打开”AI的大脑看到那个模型,但可以通过它的行为来探测。一个模型内隐的“世界模型”会通过它的“归纳偏差”表现出来,具体来说就是观察模型如何从少量新信息中进行推理和泛化。

- 第一步:首先,研究者先假设一个“世界模型”比如牛顿定律。然后基于这个世界模型生成大量小型的、合成的训练任务(比如,给出轨道上的几个点,要求预测这些点上的“力”),再让基础模型在这些小任务上进行微调fine-tune。

- 第二步:观察模型在完成这些小任务后,学到的函数或说规则是怎样的,然后将模型学到的规则与我们预设的真实“世界模型”进行比较。如果两者高度一致,说明模型的归纳偏差与真实世界模型相符,它可能真的“理解”了。反之则说明它没有。

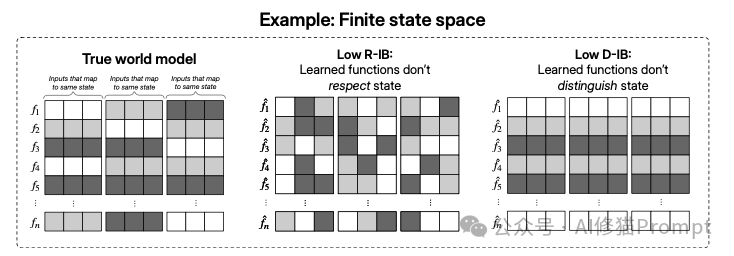

为了量化这个过程,论文还定义了两个关键指标(主要用于离散状态空间):

- 尊重状态(R-IB): 如果两个不同的输入情况对应着真实世界模型中的同一个状态(比如两个不同的Othello棋局序列,但最终棋盘局面完全一样),模型对它们的预测是否也趋于一致,高R-IB是好的。

- 区分状态(D-IB): 如果两个输入对应着不同的状态,模型的预测是否也倾向于不同?高D-IB也是好的。

左图(True world model / 真实世界模型): 这是最理想的情况。在一个状态分组内(比如前三列),所有方块的颜色都是一样的。这说明模型做到了 “同态同果”,只要状态相同,无论输入的具体过程如何,输出结果都一样。这代表了完美的尊重状态(R-IB。

中图(Low R-IB / 低R-IB):这是第一种失败。在一个状态分组内(前三列),方块的颜色有深有浅。这说明模型没能做到“同态同果”,对于本应是相同状态的输入,它却给出了不同的预测。研究者之为模型“切分状态”(divides states)。

右图(Low D-IB / 低D-IB):这是第二种失败。在不同的状态分组之间(比如前三列和后三列),方块的颜色模式竟然完全一样了。这说明模型没能做到“异态异果”,对于本应是不同状态的输入,它却给出了相同的预测。研究者称之为模型“合并状态”(merges states)。

一句话总结:这张图用可视化的方式说明,一个好的世界模型应该既能 “认同”(相同状态给相同结果,高R-IB),又能“分辨”(不同状态给不同结果,高D-IB)。

归纳偏差:AI理解世界的"密码本"

归纳偏差"(Inductive Bias) 是理解这篇论文乃至整个机器学习领域的基石概念。简单来说,归纳偏差是学习算法(无论是机器学习模型还是人类大脑)在面对不完整信息时,为了做出推断和泛化,所依赖的一套内置的“假设”、“偏好”或“倾向”。

假设您面前出现一个数字序列 2, 4, 6, 8, ... ,请问下一个数字是什么?

可能您会毫不犹豫地回答“10”。

但为什么是10?从逻辑上讲,下一个数字可以是任何数。

- 也许这是一个重复序列:2, 4, 6, 8, 2, 4, 6, 8, ... 那么下一个就是2

- 也许它背后是一个更复杂的多项式函数,恰好前四项是2, 4, 6, 8,但第五项是100

之所以选择10,是因为人的大脑有一个强大的归纳偏差:偏好更简单、更常见的模式。在这里,大部分人会默认假设这是一个“公差为2的等差数列”,因为这是最简洁、最符合日常经验的解释。

在机器学习中,这个概念是完全一样的。

一个机器学习模型看到的训练数据,相较于世界上所有可能的数据,永远是极其有限的。为了能对它从未见过的新数据做出预测(这个过程叫“泛化”),模型必须做出一些假设。这些假设就是它的归纳偏差。

归纳偏差的来源

不同的模型有不同的内置偏好。

- 卷积神经网络 (CNN): 具有“空间局部性”和“平移不变性”的偏好。它假设图片中邻近的像素关联更紧密,且一个物体(比如猫)无论出现在图片的左上角还是右下角,它仍然是猫。这使它在图像识别任务中非常成功。

- 循环神经网络 (RNN): 具有“时间序列性”的偏好。它假设数据中的顺序很重要,前面的信息会影响后面的信息。这使它天然适合处理语言和时间序列数据。

- 目标函数: 用来训练模型的目标(比如最小化误差)也包含偏差。例如,正则化项(Regularization)就是一种明确的归纳偏差,它“偏好”更简单的模型(比如权重更小的模型),以防止过拟合。

- 算法本身: 像“决策树”这样的算法偏好将数据切分成层级结构。

归纳偏差是必需品,而非缺点

正如“No Free Lunch Theorem,NFL定理”,世界上不存在一个在所有问题上都表现最好的通用学习算法。一个算法之所以在某个特定任务上表现出色,正是因为它的归纳偏差恰好与该任务的内在结构相匹配。感兴趣您可以看下这篇《没有银弹,没有免费午餐!KtR用算法思维重构Multi-Agent设计》

这也是研究者想探讨的核心问题:当一个Transformer模型学习了海量轨道数据后,它的归纳偏差是偏向于牛顿那种“简洁、普适的物理定律”,还是偏向于某种“复杂、只在特定情况下有效的死记硬背模式”?实验结果在下方揭晓。

轨道力学实验:当AI遇见牛顿定律

这是论文中最引人注目的实验,模型能发现万有引力定律吗?

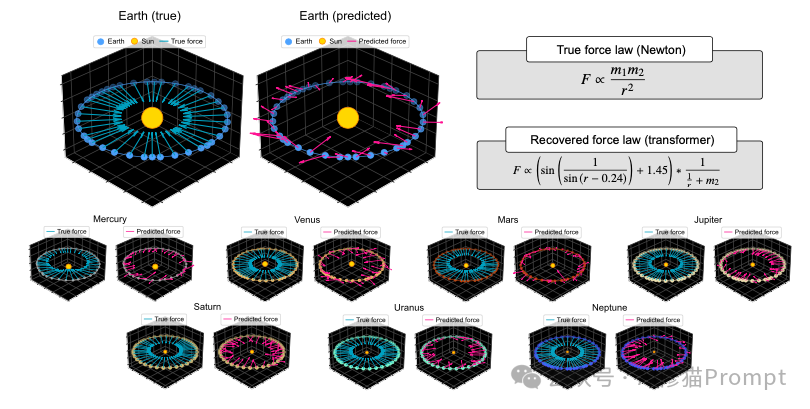

模型训练: 研究者训练了一个Transformer模型,让它学习预测行星围绕太阳运动的轨道序列。这个模型表现得非常好,预测精度极高($R^2$ > 0.9999),能够准确生成长长的轨道。从表面看,它似乎已经掌握了轨道力学。

探针测试: 研究者对这个模型进行了“归纳偏差探针”测试,其“世界模型”是牛顿力学,即由行星质量、相对位置、相对速度等构成的状态向量,但结果:模型的归纳偏差与牛顿力学完全不符 。如上图所示,模型的表现(红点)远远偏离了理想的45度线(代表与真实世界模型完美校准)

预测“力”: 为了更直观地展示模型的失败,研究者让模型去完成一个基于牛顿力学的新任务:预测行星在轨道上每一点所受的引力。

- 他们只给了模型1%的真实引力数据进行微调。

- 结果如上图所示,模型预测的引力方向和大小(右侧图)与牛顿定律计算出的真实引力(左侧图)相比,可以说是一塌糊涂、毫无规律。

- 研究者更进一步,使用“符号回归”技术,试图从模型预测的引力大小中反推出它所遵循的“物理定律”。牛顿的真实定律是 F / mm2,而模型反推出来的定律却是一个荒谬且毫无意义的公式。

也就是说当面对不同的星系样本时,模型每次都会"发明"一个不同的、错误的引力公式。这说明模型并没有学到一个统一的物理定律,而是针对不同的数据样本,学习了一套套支离破碎、无法泛化的“启发式规则”或“快捷方式”。

Othello棋盘游戏实验

研究者还将这套方法应用到了其他领域,比如Othello(奥赛罗棋)。

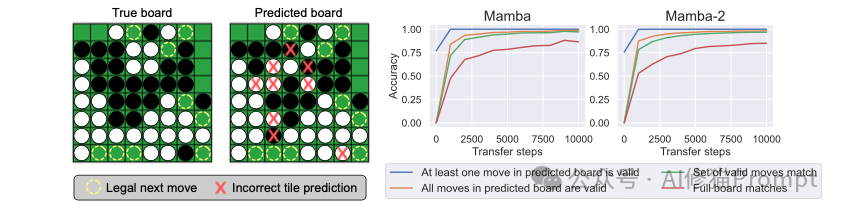

模型训练: 他们训练了包括Transformer、RNN、Mamba在内的多种序列模型来玩Othello。这些模型在下一步预测任务上同样表现出色,几乎总能下出合法的棋步。

探针测试: 测试结果显示,所有模型在“世界模型”(即真实的8x8棋盘状态)上的归纳偏差都非常差。

那么模型到底学到了什么?: 论文提出了一个深刻的洞见。模型可能没有学习精确的棋盘状态,而是学习了一个更粗糙的、与任务直接相关的状态,即“当前合法的下一步棋有哪些”。

- 如上论文题图所示,研究者让模型直接预测棋盘。模型预测出的棋盘(Predicted board)经常是错的(红色X表示错误棋子位置),但是,基于这个错误棋盘所能得出的“合法下一步”集合,却和真实棋盘的“合法下一步”集合完全一样。

这说明模型找到了一条“捷径”:它不需要完全理解棋盘,只需要学到足以判断下一步合法性的信息就够了。

研究结果:AI的"启发式陷阱"

这项研究得出了三个重要结论。

1.表面熟练不等于深度理解: 基础模型在序列预测任务上取得的巨大成功,并不意味着它们已经自动获得了对世界深层结构的、可泛化的理解 。

2.归纳偏差探针是一种有效工具: 论文提出的“归纳偏差探针”框架,是一种有效的评估工具,能够超越传统的准确率评估,真正审视模型的内在“世界模型”。

最后,也是最重要的发现:模型倾向于学习"启发式捷径"而不是统一的世界模型。在没有被强制要求学习通用规则时,模型更倾向于学习一些支离破碎的、针对特定任务的启发式规则或捷径,这些规则在训练任务上有效,但无法泛化到新的情况。

对AI工程师的启示:重新审视模型能力

这项研究对正在开发AI产品的人来说意义重大。仅仅通过扩大数据和模型规模进行序列预测,可能无法自动实现通往"真正理解"的飞跃。当模型在某个任务上表现出色时,不要急于认为它已经掌握了该领域的深层原理。

更重要的是,这项研究为我们指出了一个新的评估方向:不仅要看模型做得对不对,还要看它是怎么做对的。如果您希望构建真正可靠和可信赖的AI系统,就需要更加关注如何引导模型形成正确、鲁棒的归纳偏差,而不是让它们依赖那些看似有效但实际脆弱的启发式规则。

写在最后:从模仿到理解的漫长之路

这项研究冷静地指出了当前基础模型发展路径上的一个潜在瓶颈。我们距离真正"理解"世界的AI还有很长的路要走,但至少现在有了一把钥匙来打开AI内心世界的大门。研究者指出未来的研究需要更加关注如何设计具有正确归纳偏差的AI系统,让它们不仅能预测,更能理解。

毕竟,人们要想的不是更精密的开普勒,而是真正的牛顿。

文章来自于微信公众号“AI修猫Prompt”。

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0