Deep Cogito,一家鲜为人知的 AI 初创公司,总部位于旧金山,由前谷歌员工创立,如今开源的四款混合推理模型,受到大家广泛关注。

- 2 款中型 ——700 亿参数稠密模型、1090 亿 MoE 模型;

- 2 款大型 ——4050 亿参数稠密模型、6710 亿 MoE 模型。

每个模型都可以直接作答(标准 LLM 模式),也可以在作答前进行自我反思(类似推理模型)。

其中,最大规模的 671B MoE 模型是目前全球最强大的开源模型之一,其性能与最新的 DeepSeek v3 和 DeepSeek R1 模型相当甚至超越,且接近 o3 和 Claude 4 Opus 等闭源前沿模型。

Deep Cogito 的核心方法是迭代蒸馏与增强(Iterated Distillation and Amplification,简称 IDA),它不依赖手工设计的提示词或静态教师模型,而是利用模型自身不断演化的洞察力来引导训练。

这一过程不是通过延长推理时间来提升性能,而是让模型通过迭代式策略改进内化推理过程。

这是一个全新的扩展范式,使模型逐渐形成更强的直觉,并成为 AI 自我提升(AI 系统自我改进)概念的有力验证。

由于 Cogito 模型在搜索过程中对推理路径有更好的直觉,其推理链比 DeepSeek R1 缩短了 60%。

与普遍认为技术创新需要大量基础设施投入的观点相反,这种方法效率极高 —— Cogito 系列模型(总共 8 个,本文是其中的 4 个)的训练总成本不足 350 万美元,其中已包含合成与人工数据生成、超过一千次训练实验的所有成本。

现在,用户可以在 Huggingface 上下载模型,或者直接通过 Together AI、Baseten 或 RunPod 上的 API 使用它们,或者使用 Unsloth 在本地运行它们。

Huggingface 地址:https://huggingface.co/collections/deepcogito/cogito-v2-preview-6886b5450b897ea2a2389a6b

说到 Deep Cogito,可能许多 AI 从业者近期才刚刚开始接触这家公司,Deep Cogito 实际上已经默默耕耘了一年多的时间。

它于 2025 年 4 月正式走出隐身状态,并发布了一系列基于 Meta 的 Llama 3.2 训练的开源模型。那些早期发布的模型就已展现出颇具前景的表现。

当时最小的 Cogito v1 模型(3B 和 8B)在多个评测基准上都超越了同尺寸的 Llama 3 模型,有时差距甚至相当明显。

Deep Cogito 的联合创始人兼 CEO Drishan Arora,此前是谷歌大语言模型核心工程师。他将公司的长期目标描述为:构建能够像 AlphaGo 那样通过每次迭代不断进行推理和自我提升的模型。

方法介绍

该研究最主要的目标是:将推理步骤蒸馏回模型的参数中,也就是把推理时的搜索过程转化为模型的直觉,融入其内在能力中。

今年早些时候,Cogito v1 模型上线,该模型当时就使用了「迭代蒸馏与增强 」技术。

今天发布的 Cogito v2 模型在这一研究路径上进一步拓展到了更大规模的系统上,并将重点放在 IDA 的另一个关键部分上 —— 通过蒸馏实现自我改进。

在多个特定领域(如国际象棋、围棋和扑克),AI 通过两步循环(two-step loop)实现了超人类表现:

- 推理时计算:通过消耗算力来搜索解决方案;

- 策略迭代优化:将搜索发现的知识蒸馏到模型参数中,使得下次搜索更容易。

在这一模式下,AlphaGo 是典型代表,LLM 可视为同类系统,其推理时间计算虽比游戏系统更非结构化(通过生成答案前的「思考过程」实现),但要完成智能迭代提升的闭环,同样需要关键的第二步骤 —— 策略迭代优化。

也就是说,需要将推理过程蒸馏回模型参数中,使模型拥有更强的智能先验。这意味着应当能够以某种方式利用推理阶段的思考过程,使模型本身变得更有能力或更聪明。模型应该能够直接预测出推理的结果(而不是真的执行整个推理过程),并预判自身推理可能产生的结果。

尽管近期的 LLM 在推理方面取得了一些进展,但这些进展大多是依赖于延长推理链条,而不是增强模型本身的智能先验。因此,LLM 性能的提升主要依赖于给模型更大的思考预算(即更多的推理 token),也就是多试几种可能,而非模型对哪条搜索路径更合适有真正的直觉。同样地,LLM 在非思考模式下的改进,也主要依赖于加入回溯等启发式策略,其本质上与穷举更多路径没有本质区别。

提升模型本身的智能是一个更加困难的根本性问题,尤其是面对语言模型中那种非结构化的推理路径。要解决这个问题,需要在迭代式策略改进方面取得技术性突破。Cogito v2 就是该研究在这个方向上迈出的下一步。

该研究相信,在迭代式策略改进方向上持续研究,将有望实现远超单纯增加推理 token 所能带来的模型能力跃升。

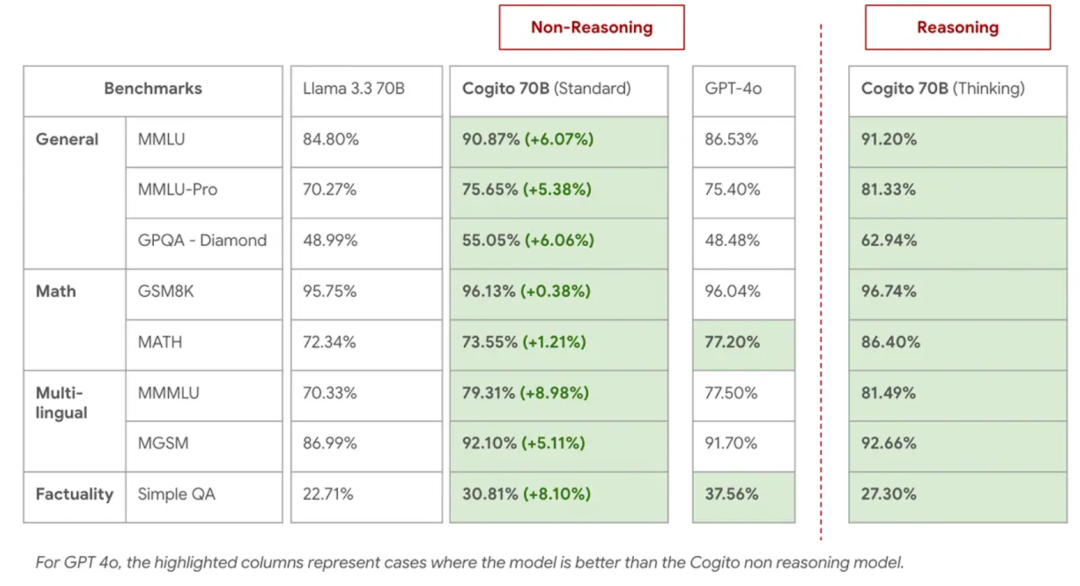

评估

团队公布了一些标准基准测试的评估结果,但特别强调,这些公开基准测试固然有其参考价值,但它们的结果与团队的内部评估时常存在差异。

在他们的内部评估中,Cogito 模型的表现持续优于大多数开源模型。因此他们相信,自家模型在应对真实世界的应用和评估时会表现出色。

此外,像 o3 和 Claude 4 Opus 这类前沿的闭源模型,它们的实力也早已超越了这些基准测试所能衡量的范畴。

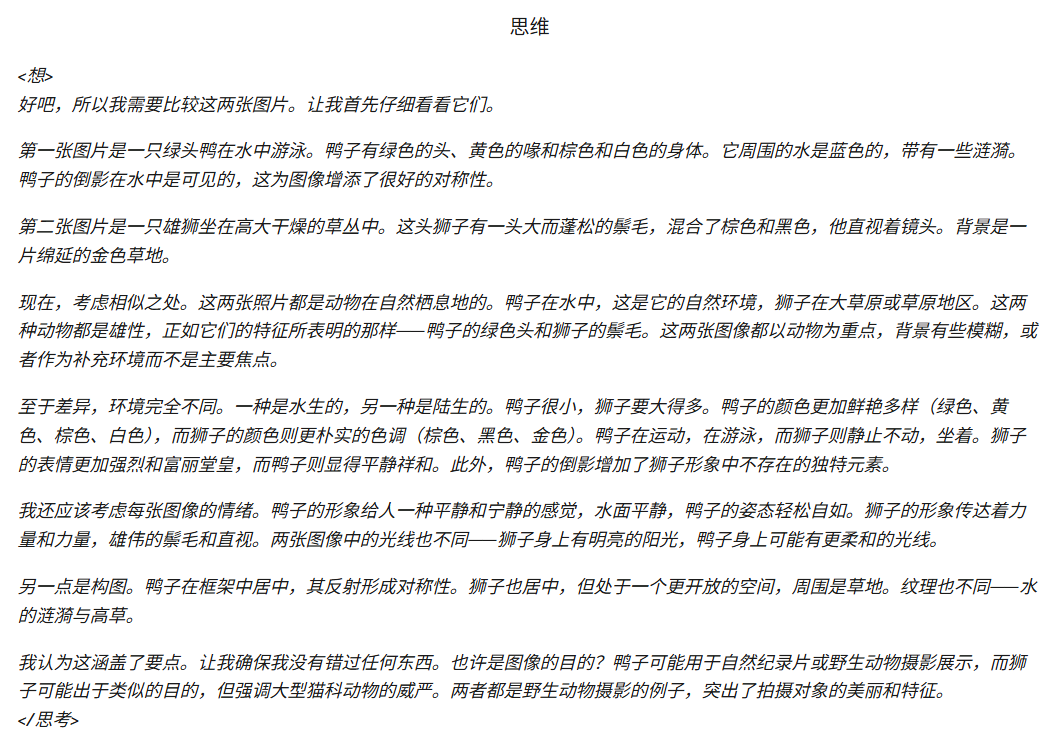

报告中还提到了一个有趣的「涌现能力」。尽管 Cogito v2 的训练数据完全是文本,但由于其基座模型具备多模态能力,它似乎通过纯粹的迁移学习,学会了对图像进行复杂的逻辑推理。

在一个示例中,模型在被要求对比两张风马牛不相及的图片(一张鸭子和一头狮子)时,其内部的「思考」过程清晰地展示了它如何分析图像的构图、色彩、主体、环境乃至情感氛围,并最终给出了条理清晰的对比。

这种未经专门训练而自发产生的能力,为研究 AI 的泛化与学习机制提供了新的有趣视角。不过团队尚未通过视觉基准测试评估此功能。

基准测试结果

70B Dense

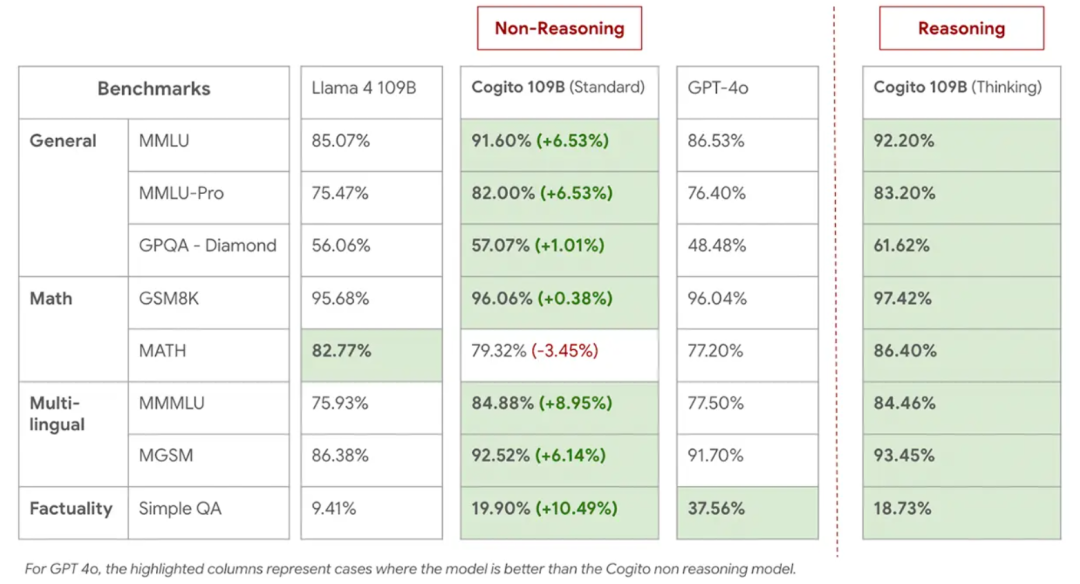

109B MoE

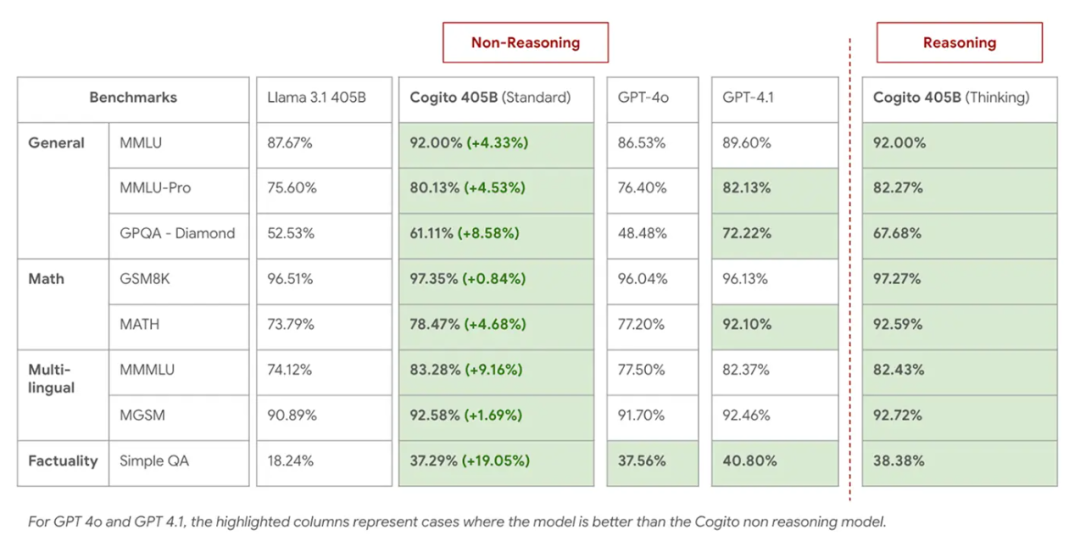

405B Dense

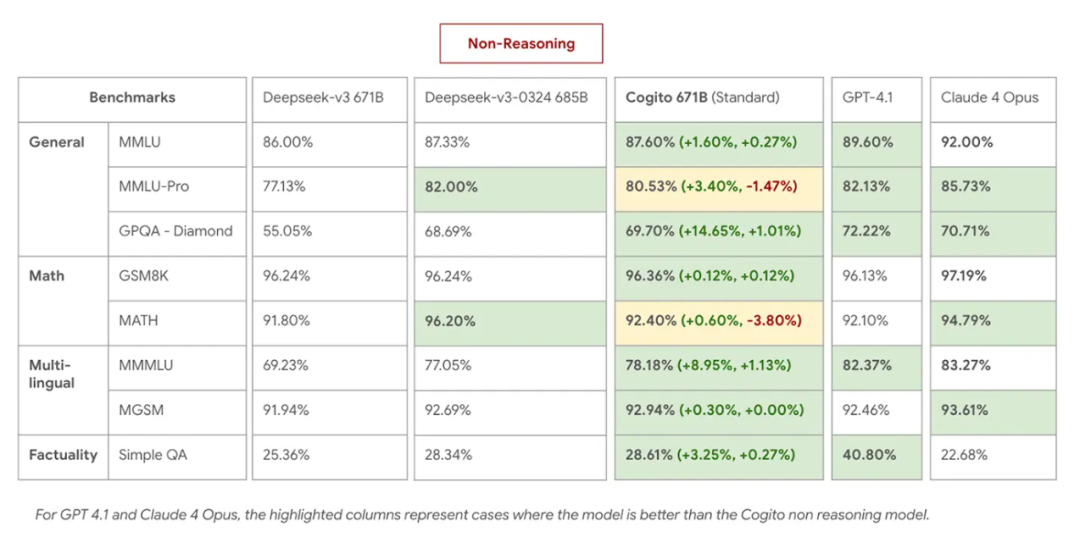

671B MoE(非推理)

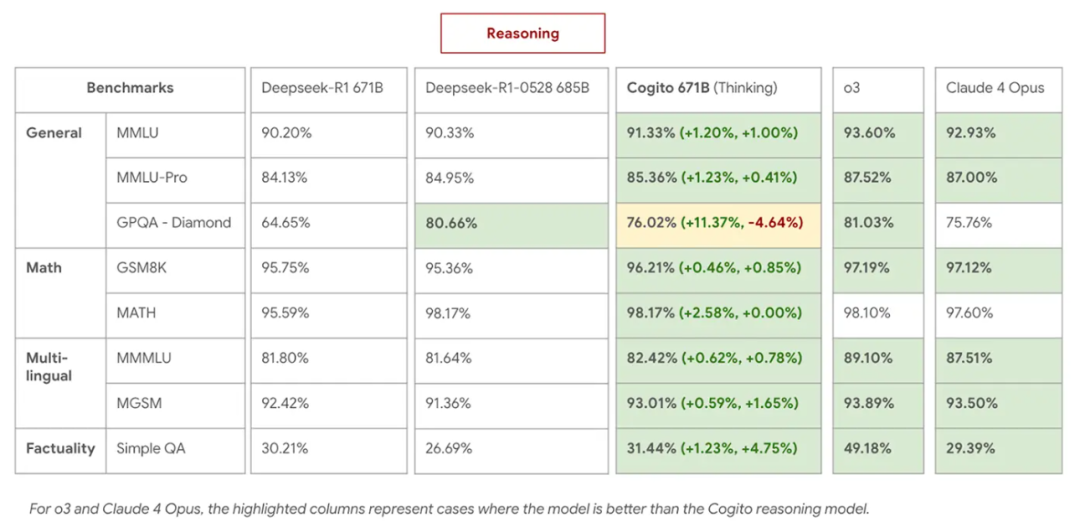

671B MoE(推理)

参考链接:

https://www.deepcogito.com/research/cogito-v2-preview

文章来自于微信公众号“机器之心”。

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0