AI图像编辑技术发展迅猛,扩散模型凭借强大的生成能力,成为行业主流。

但这类模型在实际应用中始终面临两大难题:一是“牵一发而动全身”,即便只想修改一个细节,系统也可能影响到整个画面;二是生成速度缓慢,难以满足实时交互的需求。

针对这些痛点,智象未来(HiDream.ai)团队开辟了新路径:提出全新的自回归图像编辑框架VAREdit。

它引入了视觉自回归(VAR)架构,能够在遵循指令的前提下做到“指哪打哪”,大幅提升编辑精准度与生成速度,推动图像编辑进入新的阶段。

模型与代码均已开源,具体链接可见文末。

全新自回归图像编辑框架VAREdit

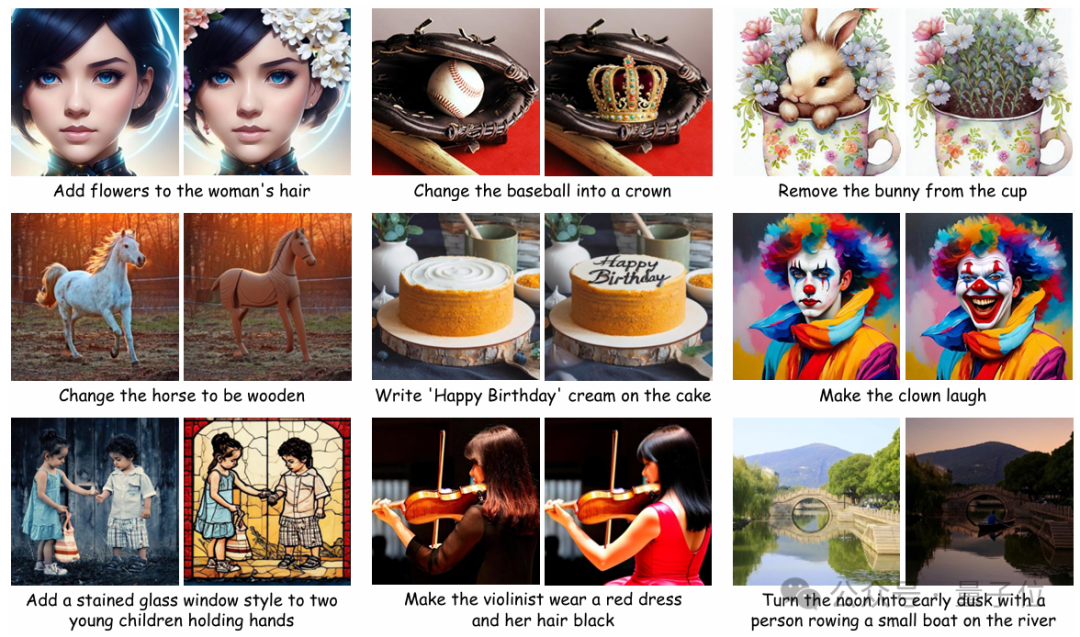

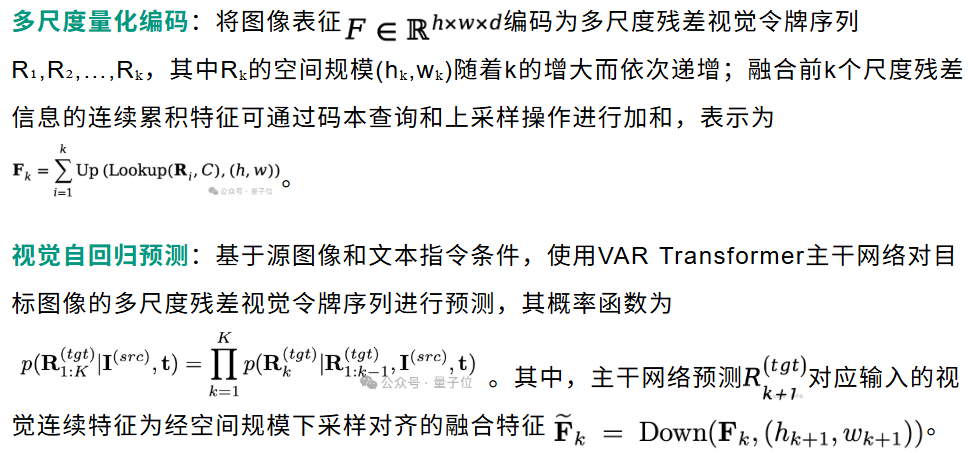

智象未来提出的VAREdit将视觉自回归建模引入指令引导的图像编辑中,将图像编辑定义为下一尺度预测问题,通过自回归地生成下一尺度目标特征残差,以实现精确的图像编辑。

设计VAREdit的一个核心挑战是如何将源图像信息引入主干网络中,作为目标尺度生成的参考信息。

智象未来团队首先探索了两种组织方案:

尺度对齐参考模块

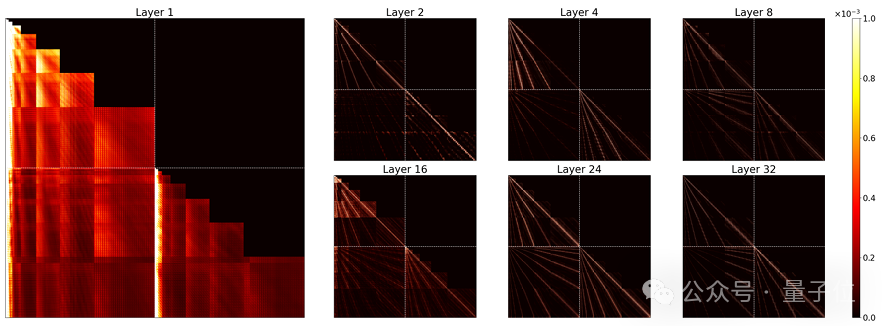

对全尺度条件模型的自注意力分析发现:

在首层,注意力分布范围广,主要集中于较粗尺度特征,用于建立整体布局和长程依赖;

而在更深层,注意力逐渐局部化,呈现明显的对角结构,说明其功能已转向空间邻域的细化与局部优化。

上述探索促使智象未来提出一种混合方案——尺度对齐参考(SAR)模块:在第一层提供多尺度对齐参考,后续层仅关注最细尺度特征。

通过上述SAR模块优化,使得VAREdit能够更好地捕捉源图像与目标图像之间的多尺度依赖关系,同时实现最大尺度条件模型的生成效率。

基准测试表现出色

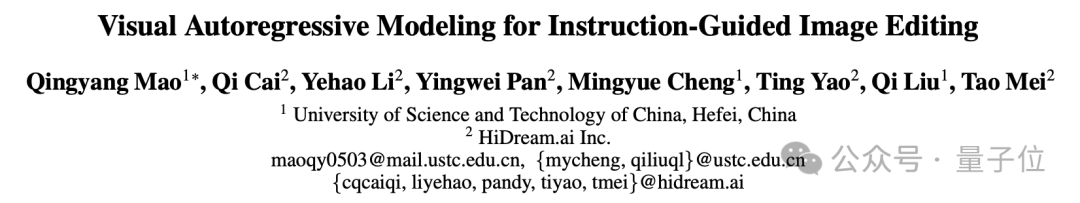

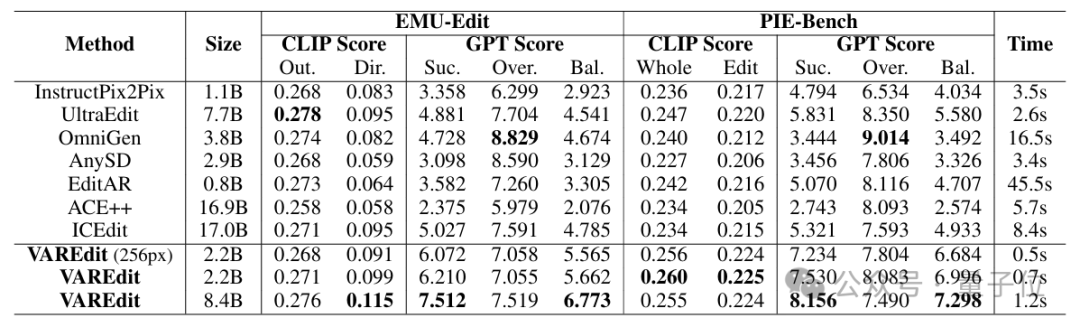

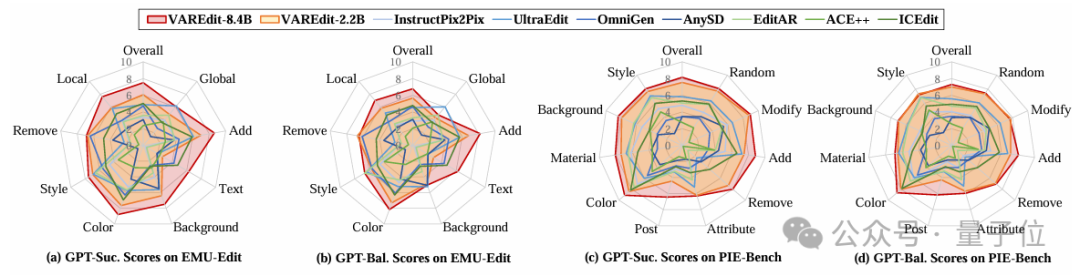

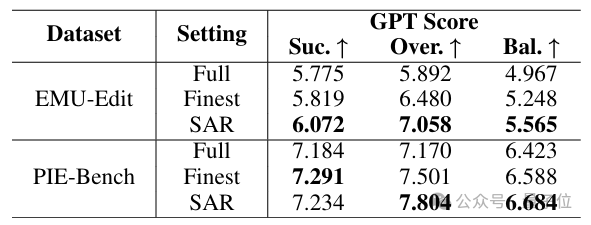

在业内权威的EMU-Edit和PIE-Bench基准测试中,VAREdit在CLIP与更能衡量编辑精准度的GPT指标上均表现突出。

其中,VAREdit-8.4B在GPT-Balance指标上相较于ICEdit和UltraEdit分别提升41.5%与30.8%,而轻量级的VAREdit-2.2B也取得了显著提升。

在速度上,VAREdit同样优势明显。

基于下一尺度预测机制,8.4B模型可在1.2秒内完成一张512×512图像的编辑,较同类扩散模型快2.2倍;2.2B模型则仅需0.7秒,在保持高质量的同时实现了即时编辑体验。

此外,VAREdit适用范围广,在大多数编辑类型上均取得最佳效果。虽然小模型在全局样式和文本编辑方面略有不足,但大模型有效弥补了差距。

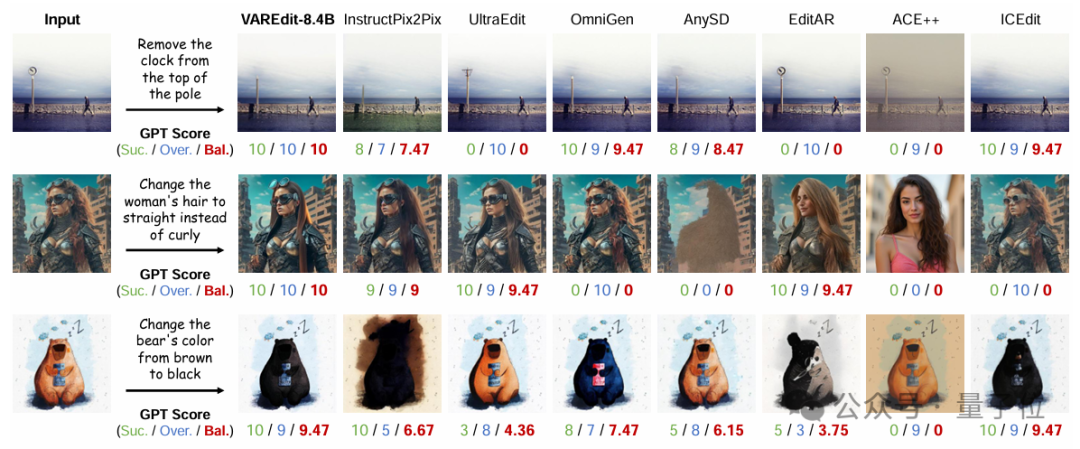

视觉对比显示,VAREdit编辑自然、保真度高,过度修改更少。

值得一提的是,引入SAR模块后,模型在精准性指标上进一步提升,凸显其优化价值。

总的来说,VAREdit将下一尺度预测范式引入指令引导图像编辑框架,基于文本指令和量化源图像特征预测目标图像多尺度视觉残差。通过分析不同条件组织形式并引入新颖SAR模块,实现了图像编辑在精准性与效率上的提升。

智象未来团队表示,未来将继续探索新一代多模态图像编辑架构,推动指令引导图像生成技术向更高质量、更快速度、更强可控性发展。

GitHub: https://github.com/HiDream-ai/VAREdit

在线使用: https://huggingface.co/spaces/HiDream-ai/VAREdit-8B-1024

论文链接:https://arxiv.org/pdf/2508.15772

文章来自于微信公众号“量子位”。