“如果一个问题只需小模型就能回答,为什么还要让更贵的大模型去思考?”

在大语言模型(LLM)种类爆炸的时代,这个看似简单的问题,正成为 AI 系统设计的关键瓶颈。面对性能、延迟与成本的多重平衡,如何智能地在不同 LLM 之间分配任务,已经成为 AI 基础设施的新挑战。

近日,来自伊利诺伊大学香槟分校(UIUC)的研究团队在 NeurIPS 2025 上发布了新作:《Router-R1:Teaching LLMs Multi-Round Routing and Aggregation via Reinforcement Learning》,本文提出了首个多轮 LLM Router 框架 Router-R1,让 LLM 不止会 “回答”,还会 “思考、调度与协调其他模型” 来达到可控的性能与成本平衡。

- 论文标题:Router-R1: Teaching LLMs Multi-Round Routing and Aggregation via Reinforcement Learning

- 作者团队: Haozhen Zhang, Tao Feng, Jiaxuan You

- 机构: University of Illinois at Urbana-Champaign

- 论文地址: https://arxiv.org/abs/2506.09033

- 代码地址: https://github.com/ulab-uiuc/Router-R1

🧭 背景:从「一个模型回答所有问题」到「智能调度」

ChatGPT、Claude、Gemini、Qwen、LLaMA……,短短两年,LLM 家族已从寥寥数个增长到百余种。不同模型各有优势,有的擅长逻辑推理,有的在知识问答上精准,有的响应快、成本低。

但如今的 AI 应用,大多依赖单一模型推理,即用户问题会直接被送入某个固定的 LLM 中进行回答。这种方式虽然简单,但却意味着:简单问题可能导致算力浪费;复杂问题又可能因模型能力不足而回答错误。

因此,“LLM Router” 应运而生并正在成为 AI 系统的新前台大脑:不同于 Token-level Router(如 MoE),LLM Router 在 Query-level 层面进行路由,它能够判断一个问题的复杂度、匹配最合适的模型,甚至动态组合多个模型完成推理。

然而,现有的 LLM Router(如 GraphRouter、RouterDC 等)大多采用单轮决策机制:给定一个问题,只路由到一个候选模型完成回答,这种单轮路由机制难以处理多跳推理或跨领域的复杂任务。

🚀 Router-R1:让 Router 本身成为一个「会思考的 LLM」

本文提出的 Router-R1 的核心创新在于让 Router 自身成为一个具备推理能力的 Policy LLM。

也就是说,Router-R1 不再只是一个 “Query 分发器”,而是一个拥有思维链,能主动进行 “思考 — 选择模型 — 聚合” 的智能体,可以在思考,路由,聚合几种行为之间反复切换并进行多轮路由迭代,逐步构建最终答案:

- 1️⃣ Think(思考):在接收到 User Query 后,Router-R1 会首先执行 “思考” 阶段进行内部推理分析,并判断是否需要外部信息进行辅助;

- 2️⃣ Route(路由):若发现需要额外信息,Router-R1 则触发 “路由” 指令根据每个 LLM 的 Descriptor Prompt 动态调用合适的外部候选模型(如 Qwen、LLaMA、Gemma、Mixtral 等)进行回答子问题;

- 3️⃣ Aggregate(聚合):外部模型调用的回复结果返回后继续插入 Policy LLM 的 Evolving Context 进行聚合,并继续进行后续的多轮推理逐步生成最终答案。

这种 “思考–路由–聚合” 的交替机制,使 Router-R1 能充分利用不同 LLM 的互补优势(例如一个擅长数学推理、另一个擅长知识检索),潜在实现真正的多模型协同推理。

🎯 用强化学习教 Router 平衡性能与成本

Router-R1 将整个多轮路由过程形式化为一个序列决策问题,并通过强化学习训练 Router 使之学会在复杂决策空间中优化 Performance-Cost Trade-off。论文中设计了三类直观的奖励函数:

1️⃣ Format Reward:输出 Format 正确性奖励

确保模型输出严格遵守如 <think>、<answer> 等格式约束,防止训练早期生成无效文本。

2️⃣ Final Outcome Reward:结果正确性奖励

采用 Exact Match(EM)指标衡量生成答案与标准答案是否完全一致,直接激励 Router 输出正确结果。

3️⃣ Cost Reward:成本约束奖励

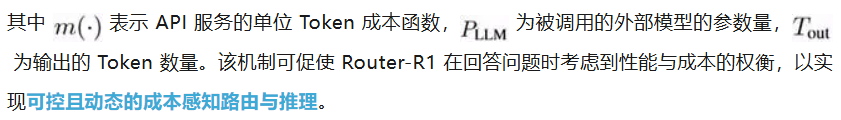

Router-R1 创新地引入了计算成本奖励机制,根据被调用模型的参数规模及输出 Token 数设计反比例奖励函数:

综合三者后,Router-R1 的总奖励为:

其中超参 α 控制性能与成本的权衡程度。

🧪 七大基准全面领先:准确率 + 泛化性双提升

研究团队在 7 个 QA Benchmark 上对 Router-R1 进行了系统评测,涵盖单跳与多跳推理任务,包括 NQ、TriviaQA、PopQA、HotpotQA、2WikiMultiHopQA、Musique 和 Bamboogle。Router-R1 仅在 NQ 与 HotpotQA 数据集上进行训练,在其余数据集上执行 Out-of-domain Evaluation。

如上图所示,当 α=0 时(即只优化 performance 不考虑 cost),Router-R1 在所有数据集上达到了综合最强的性能,击败了如 GraphRouter/RouterDC 等单轮路由方法,并展现出了对 Unseen Dataset 的较强泛化性。

如上图所示,当继续改变超参 α 来探究性能成本权衡时,随着 α 增加,调用成本显著下降,为可控成本的 LLM 智能调度策略开辟了新的范式。

同时,为了检测 Router-R1 对外部候选 LLM 的泛化性,如上图所示在未参与训练的外部模型加入后,无需重新训练即可保证性能的相对稳定并在此基础上实现提升,显示出 Router-R1 优异的零样本迁移能力。

🧩 总结:迈向「多模型协同智能体」的时代

本文提出的 Router-R1 不是又一个 “更大的模型”,而是让多个模型协同工作的新范式。Router-R1 通过强化学习,让 LLM 从 “单一回答者” 进化为「多智能体协调者」,在性能与成本之间实现动态平衡。得益于此,Router-R1 能在减少算力和成本开销的同时保持高质量输出,降低大模型部署的环境与资源压力。Router-R1 天然支持模型重用与模块化组合,只需添加新模型描述即可快速集成,为构建可扩展、多模型共生的 AI 基础设施奠定了基础。

值得注意的是,最新的 GPT-5 技术报告也已明确采用 LLM Router 机制来进行不同版本模型的动态调度,这进一步印证了 Router-R1 所代表的趋势:多模型协同路由将成为未来大模型生态不可或缺的底层基础设施。

文章来自于“机器之心”,作者“Haozhen Zhang”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0