多模态大模型首次实现像素级推理,指代、分割、推理三大任务一网打尽!

AI“看图说话”现在已经so easy,但即使是GPT-5、Gemini 2.5 Pro,也只能“看个大概”,难以进行更精确的目标识别和推理。

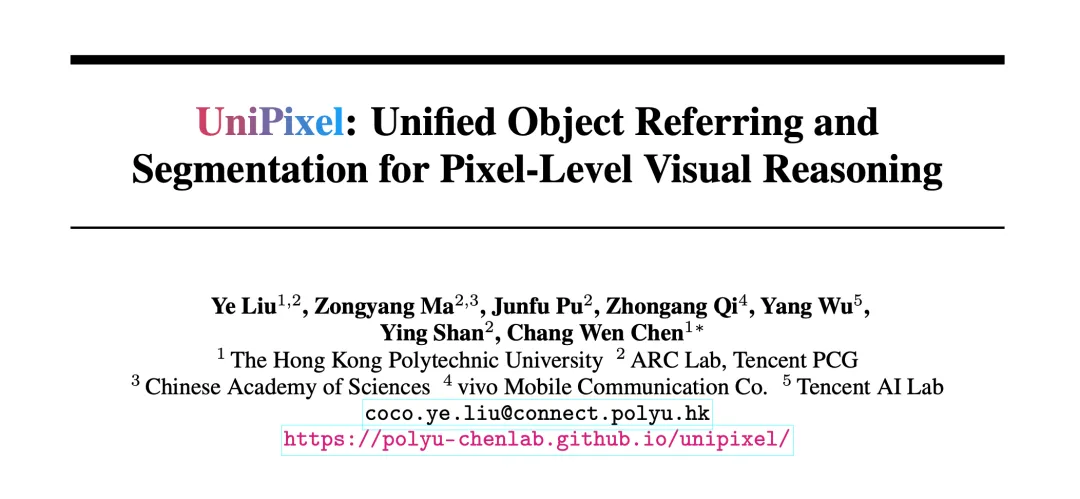

对此,来自香港理工大学和腾讯ARC Lab的研究团队提出了首个统一的像素级多模态大模型——UniPixel。

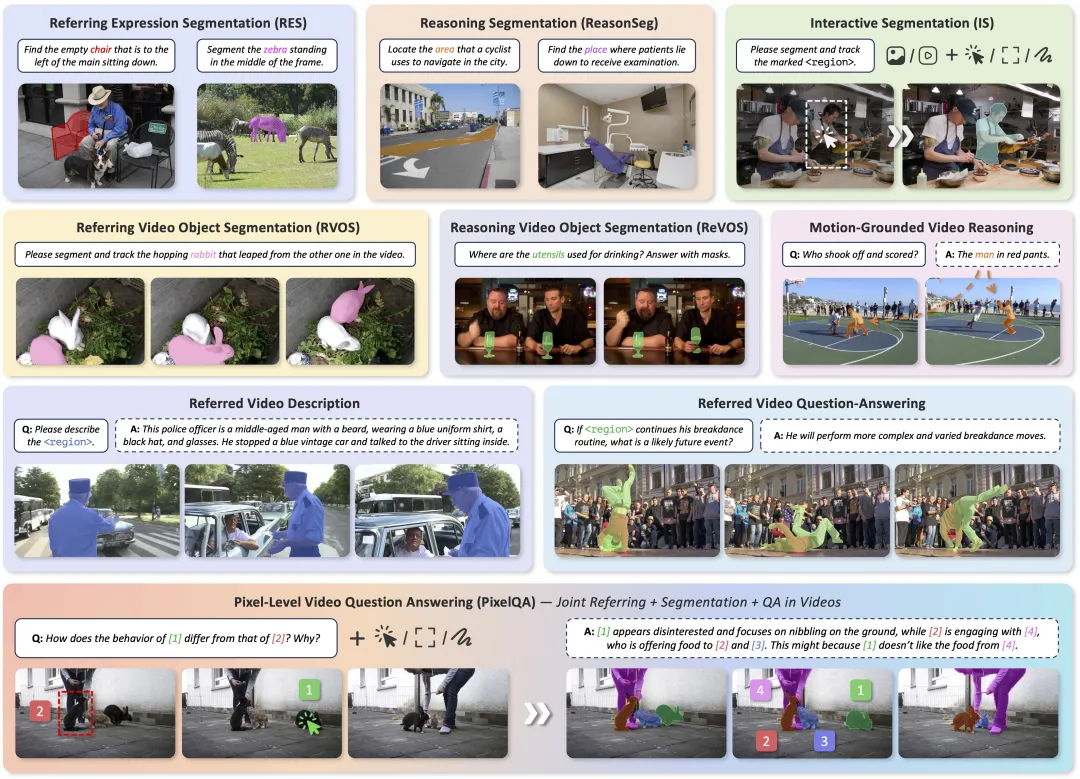

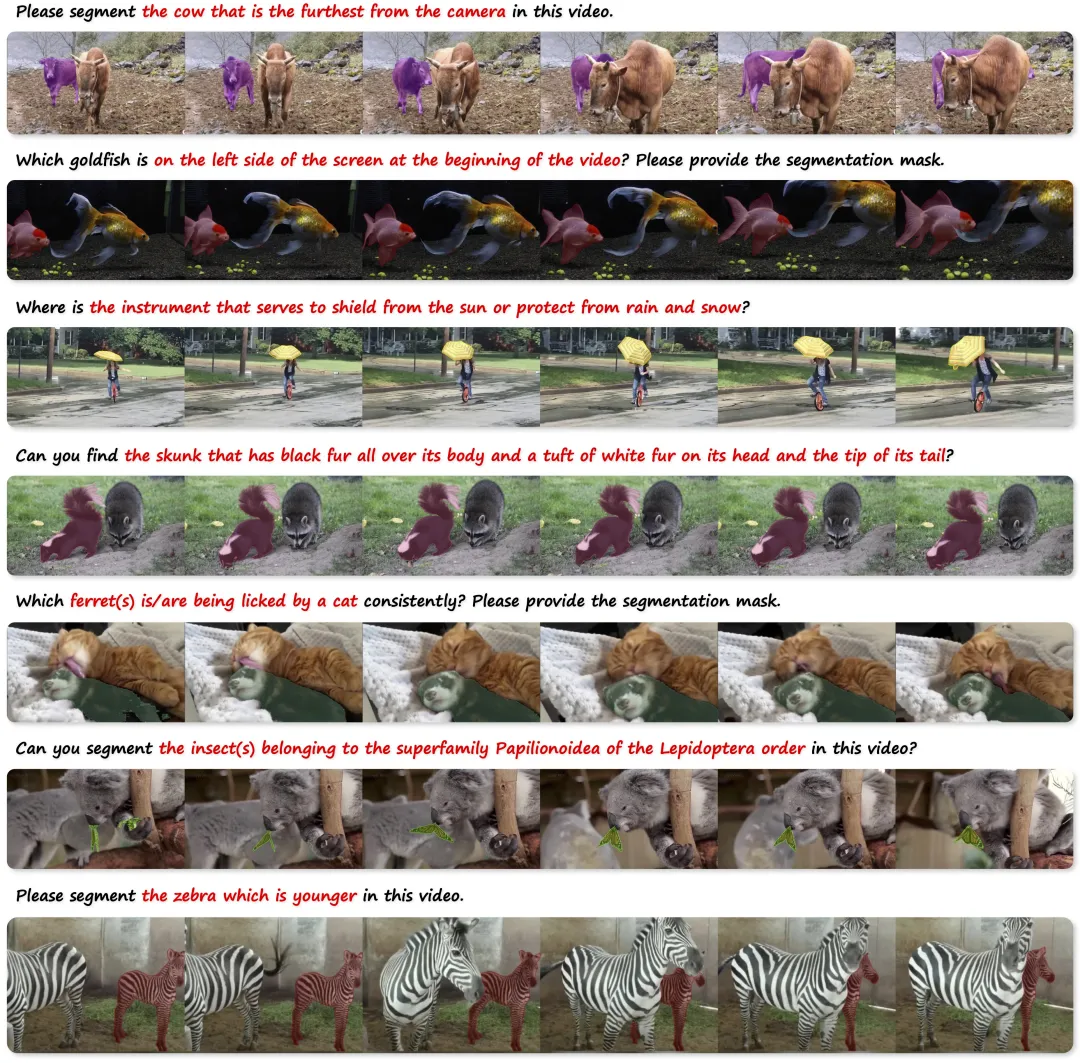

话不多说,先来康康UniPixel的效果:

只需UniPixel一个模型,就能完成目标指代(Referring)、像素级分割(Segmentation)与区域推理(Reasoning)三大任务,兼具灵活性、精确性与可扩展性。

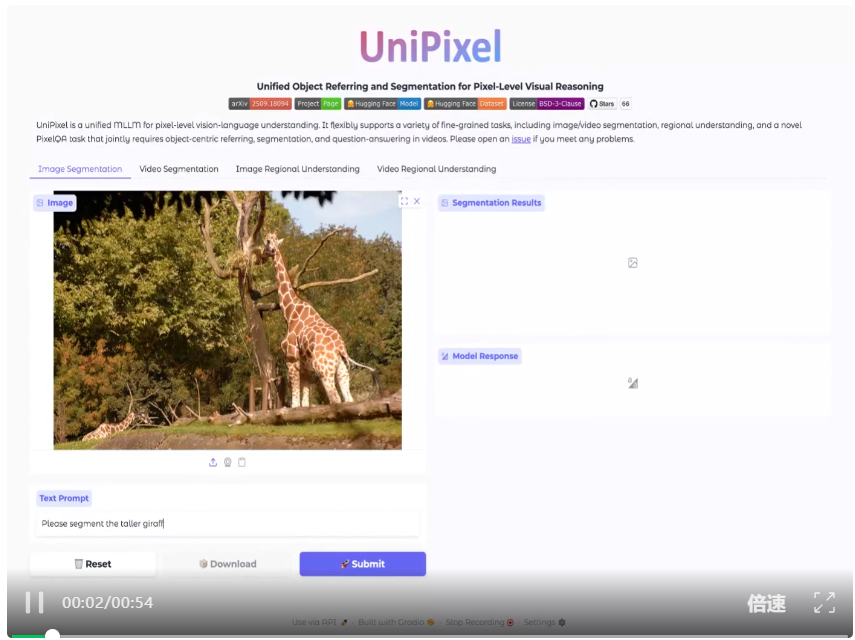

目前该论文已被NeurIPS 2025接收,而且代码、数据、Demo全开源!

下面是更多详细信息。

UniPixel重新定义视觉推理

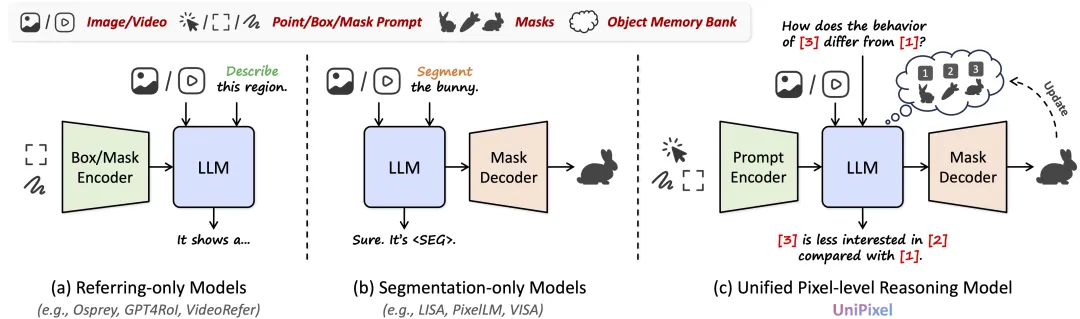

传统的视觉问答或描述系统,多数基于整体的图像或视频信息进行推理,缺乏对图中“具体区域”或“指定目标”的精确感知。

这不仅限制了其在医疗诊断、自动驾驶、人机交互等场景中的实际应用,也难以满足用户对“可控性”与“可解释性”的高阶需求。

以一个日常任务为例:“请指出图中坐在左侧的人并描述他在做什么。”对于人类来说,我们会迅速聚焦至左侧目标,通过视角、行为和上下文进行判断与描述,但对于传统LMM,这样的问题往往因缺乏区域指引与显著性建模而难以作答准确。

UniPixel通过引入“对象记忆机制(Object Memory Bank)”与支持三类视觉提示(点、框、掩码)的统一视觉编码方式,实现了对用户提示的“感知—记忆—推理”全过程支持。

区别于现有的简单分割和区域级理解模型,UniPixel不仅能识别用户所指的目标,还能将该目标作为上下文显式纳入后续对话中,并输出与之强关联的分割结果、语言回答或描述内容。

为实现这一目标,UniPixel 在架构设计上进行了系统性的革新。

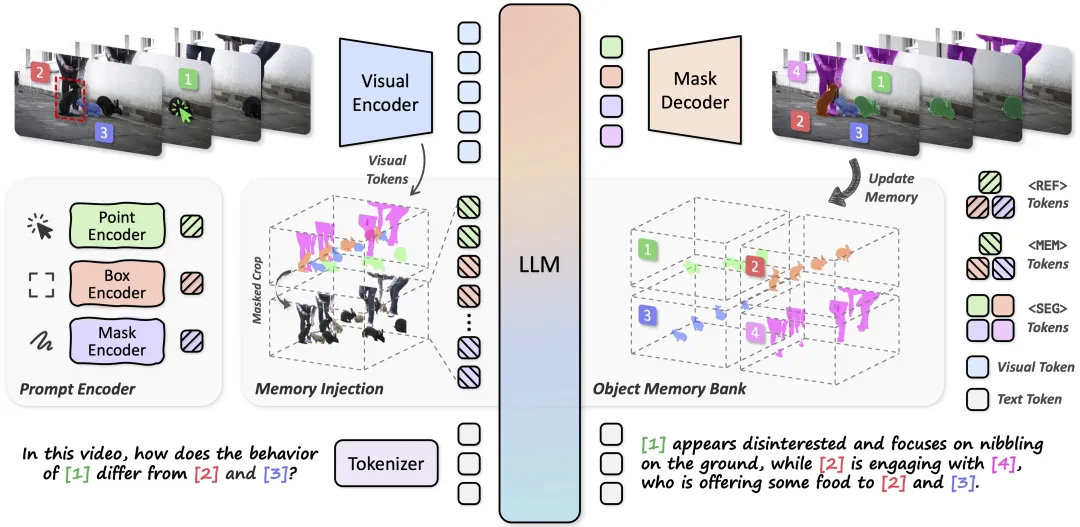

如下图所示,其整体框架基于Qwen2.5-VL模型,支持图像与视频输入,并具备对文本、点、框、掩码等多种提示的感知与处理能力。

用户可输入一个图像或视频、一条文本提示,以及若干个可选的视觉提示,模型则输出自然语言回答与可选的时空掩码(spatial-temporal mask),实现基于视觉细节信息的交互。

为了让这一框架真正具备“像素级推理”的能力,UniPixel 进一步引入了三大关键模块:

- 提示编码器:支持点、框、掩码三种视觉提示;

- 对象记忆体:用于存储用户指定目标并支持多轮引用;

- 掩码解码器:实现精确的时空掩码生成。

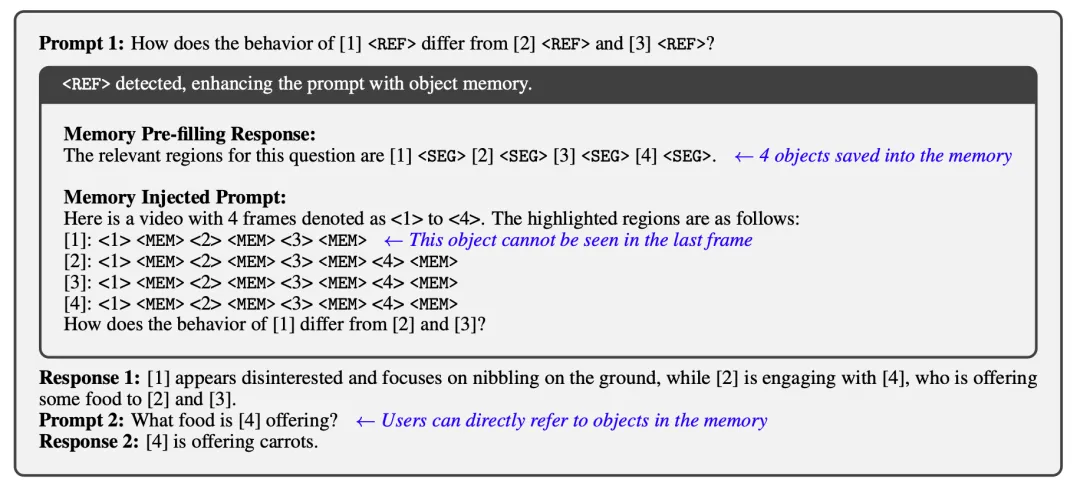

此外,UniPixel对语言模型词表进行了扩展,增加了<REF>、<MEM>与<SEG>等特殊Token,用于引导视觉提示的注入、对象记忆的调用与掩码生成过程,从而在语言生成与像素感知之间建立了紧密连接。

具体可包括三大技术亮点:

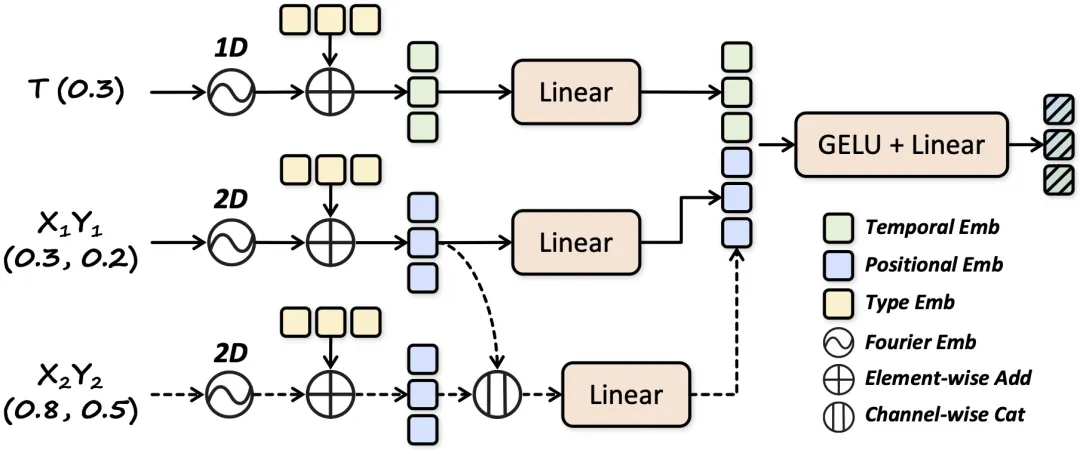

三类视觉提示统一编码

为实现最大程度的自由交互,UniPixel设计了Prompt Encoder模块对三类视觉提示进行统一编码。

无论是点、框,还是掩码,均可被统一编码为同一空间中的高维向量。

这一编码方式融合了空间坐标、时间位置、提示类型等信息,并借助编码投影层与视觉Token进行对齐。

相比以往模型仅接受文本提示或简化的图像区域,UniPixel可处理更复杂的用户输入,例如:在视频第5s处点击某个目标,并对其前后发生的事件进行提问,而这类场景可以通过点提示+时间标识的组合被准确解析和处理。

对象记忆体机制,赋予模型记住目标的能力

UniPixel的最核心设计之一是其对象记忆体(Object Memory Bank)模块,这是一个可动态更新的哈希结构,用于在推理过程中存储与管理用户指定的目标区域,其运行机制如图所示。

具体来说,每当用户在输入中使用如等标记指代某一目标,模型就会自动触发一个“记忆预填充(memory pre-filling)”流程,智能识别并生成对应的时空掩码,然后将其作为对象信息写入记忆体中。

这一机制允许模型在多轮对话中不断复用这些记忆对象,实现真正意义上的“上下文可控推理”。

后续若用户再次提及某一目标,只需使用之前定义的编号即可自动激活相应区域,通过“记忆植入(memory injection)”机制将其特征插入到prompt中,供LLM进行推理。

这种机制打破了传统方法中“提示-响应”一次性交互的局限,让模型具备了类似人类的“关注-记忆-归纳”能力。

例如,当用户问“[1]和[2]之间有什么互动?”时,模型可以将两者的行为轨迹通过掩码抽象出来,并从原图片或视频中重新感知以生成合理回答。

掩码引导推理,将理解与分割进行深度融合

除了精准识别目标区域外,UniPixel还将掩码生成这一过程嵌入到语言模型推理流程中,实现了“语言引导分割,分割反哺理解”的双向闭环。

具体而言,模型在推理过程中生成<SEG> Token作为掩码触发标志,每个<SEG> Token会被输入到掩码解码器,根据上下文及已知提示生成对应的目标掩码。

这些掩码随后通过对原图片或视频进行池化,转化为LLM可识别的对象特征,用于回答更复杂的语义问题。

这一机制极大提升了模型在视频理解任务中的表现,以一个实际任务为例:“[1]和[2]的行为有何差异?”通过对[1]、[2]的行为区域建模与掩码特征对比,UniPixel可以准确给出回答,并指出每一帧中的对应区域。

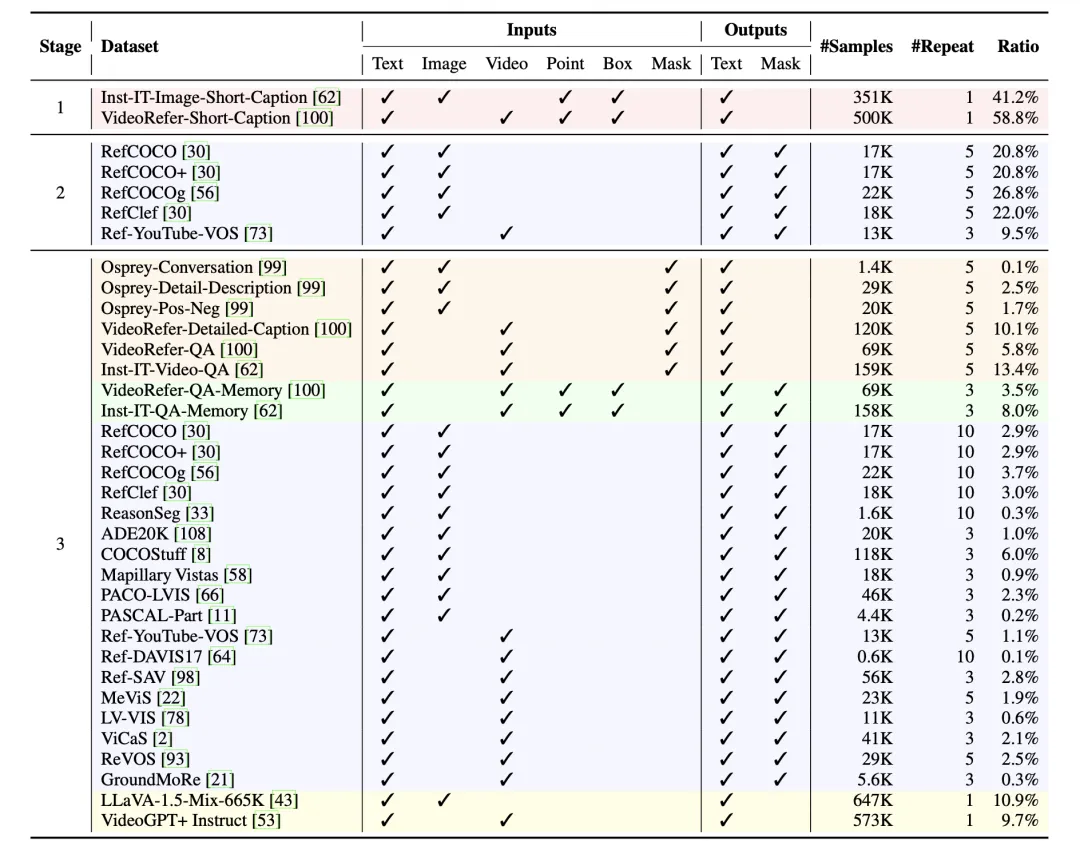

另外在训练流程上,UniPixel采用了模块化、分阶段的训练策略。

模型首先对视觉编码器和语言模型进行预训练,再逐步引入Prompt Encoder、Object Memory Bank和Mask Decoder等组件进行联合训练,使各模块能够协同工作而不过拟合到特定任务。

此外,作者还构建并整合了多个数据集,涵盖文本、图像和视频三种数据,以及多种视觉提示类型(点、框、掩码)。

整个训练数据规模达到约100万条样本(具体见下表),支持从静态对象指代到时序掩码生成等多种任务类型。这些数据为模型提供了统一、多样的训练环境,提升了其在不同任务设置下的适应能力。

实验与评估

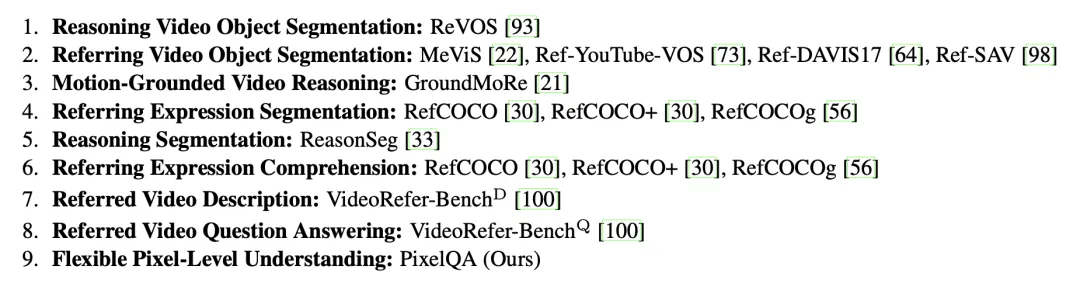

为了验证UniPixel框架的有效性,作者在10个公开基准测试集上进行了广泛的实验,涵盖9大视觉-语言理解任务,具体任务和数据集设置如图所示。

△用于UniPixel评测的基准测试集

目标分割任务

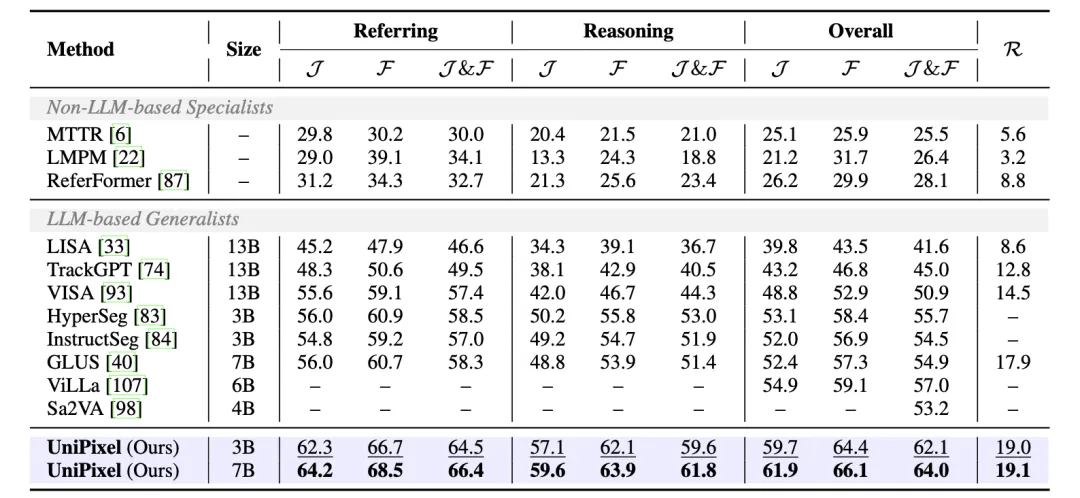

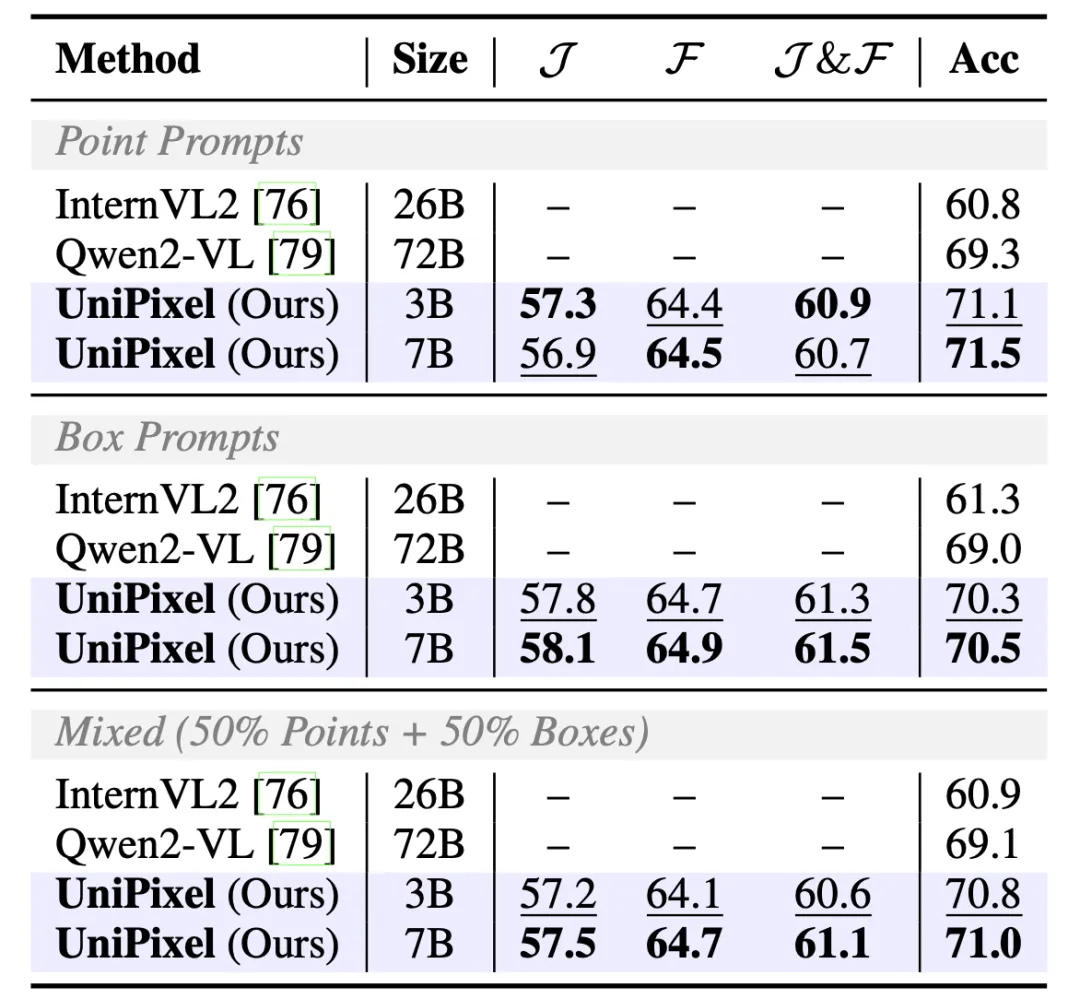

得益于统一的框架设计和渐进式的训练范式,UniPixel在分割任务上展现出显著性能优势。

其中,在较为困难的ReVOS推理分割基准上,UniPixel-3B达到62.1 J&F,超过现有所有模型,表明其在理解复杂文本提示与像素级掩码生成之间具有更强的关联建模能力,完整的ReVOS数据集测试结果如下表所示:

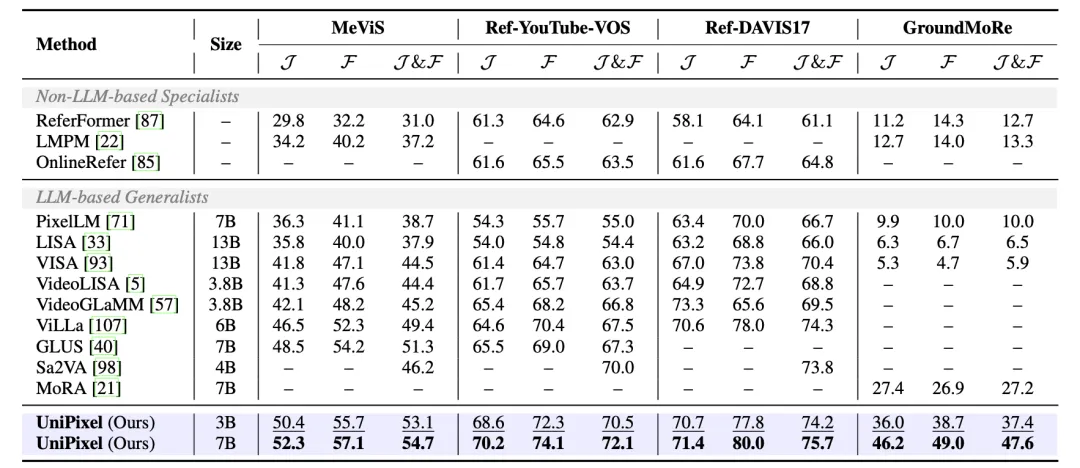

在MeViS、Ref-YouTube-VOS和RefCOCO/+/g等其他数据集上,UniPixel也展现出了最佳性能,其中MeViS、Ref-YouTube-VOS、Ref-DAVIS17和GroundMore数据集的测试结果如表所示:

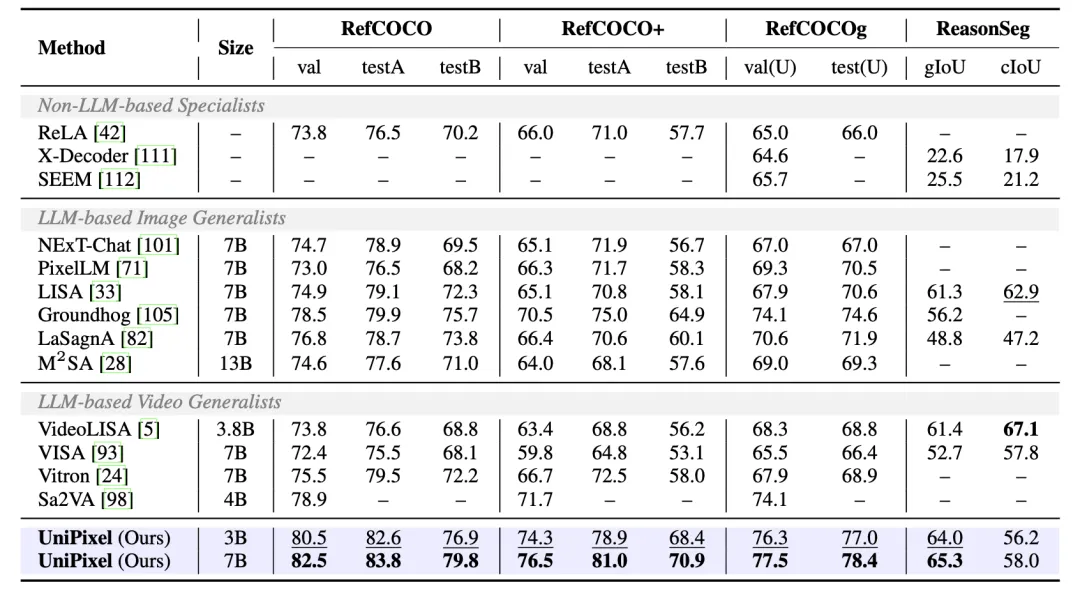

而RefCOCO/+/g(cIoU)和ReasonSeg数据集的测试结果如下表所示:

区域理解任务

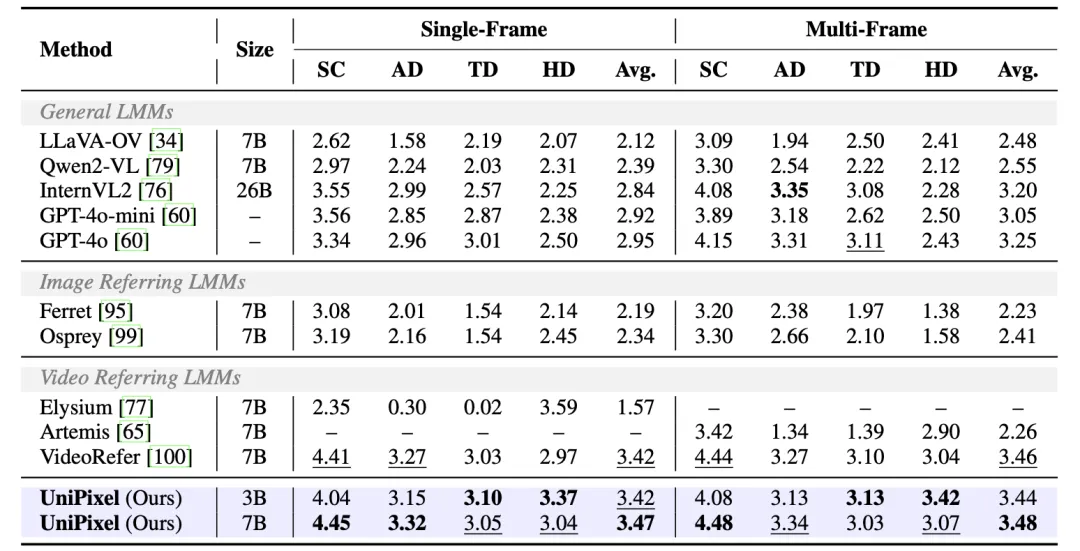

在VideoRefer-Bench基准上,UniPixel同样在掩码提示的视频区域理解上取得领先表现,显示出其对视觉提示的适应性与鲁棒性。

该任务要求模型根据复杂的语言描述,理解用户所指定的掩码区域,并在视频中正确解析其动态变化与语义关系。

UniPixel借助其对象记忆机制和多模态协同编码能力,能够准确捕捉目标区域的边界与行为变化。

其中,VideoRefer-Bench-D数据集的测试结果为:

VideoRefer-Bench-Q数据集的测试结果为:

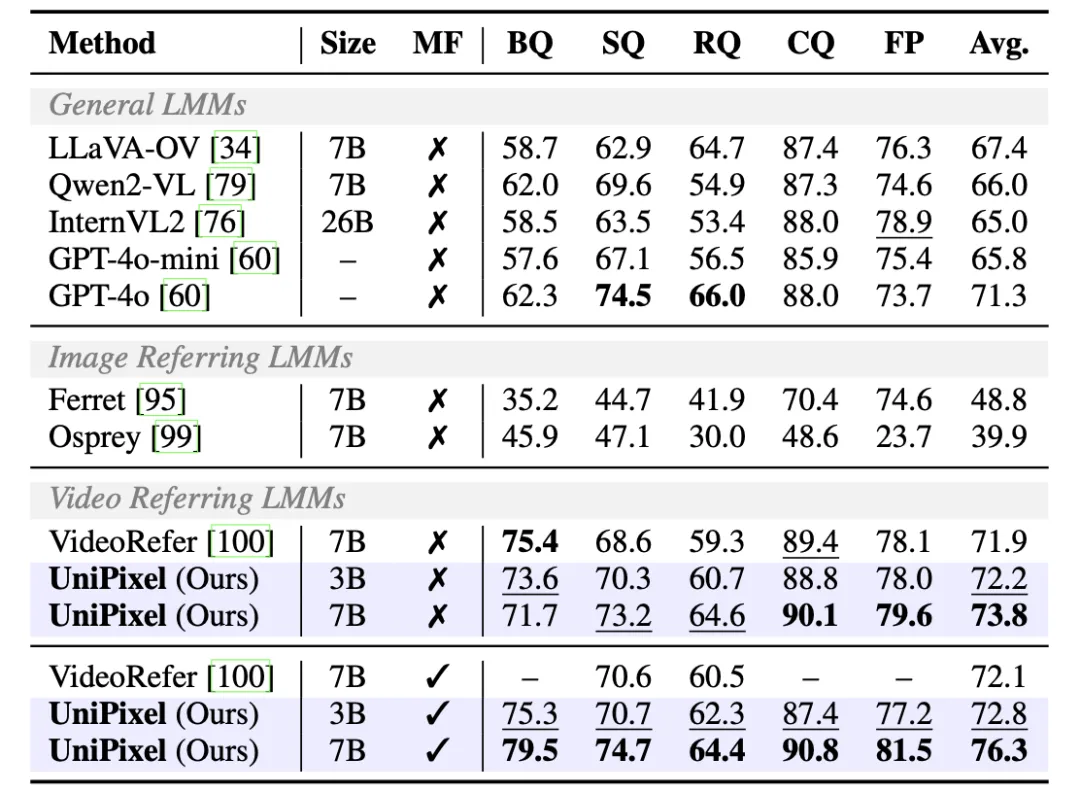

PixelQA任务

为了进一步验证模型的指代-分割统一建模能力,作者还提出了全新的PixelQA任务,该任务要求模型理解视频中的点或框指代的对象,并且:

- 分割该目标在所有帧中的掩码;

- 回答问题。

在本任务上,UniPixel展现出了出色的多任务建模能力,如表所示,其性能超越72B的传统模型。

△PixelQA任务的测试结果

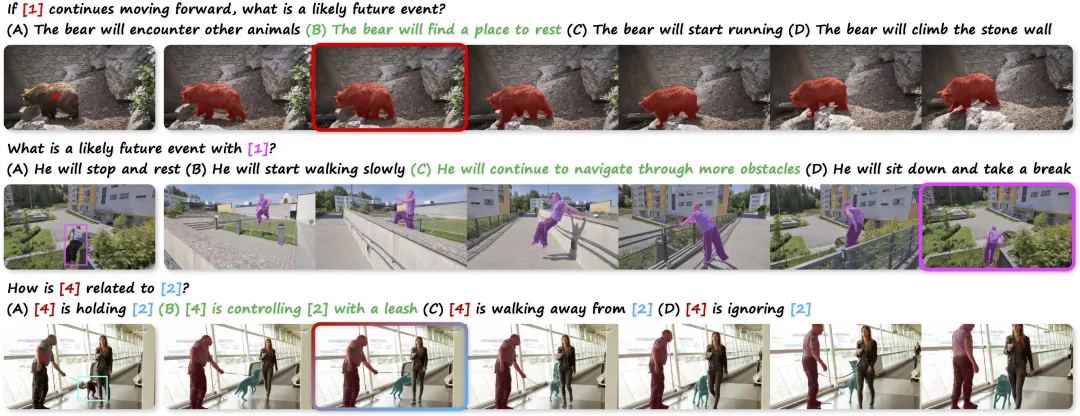

可视化

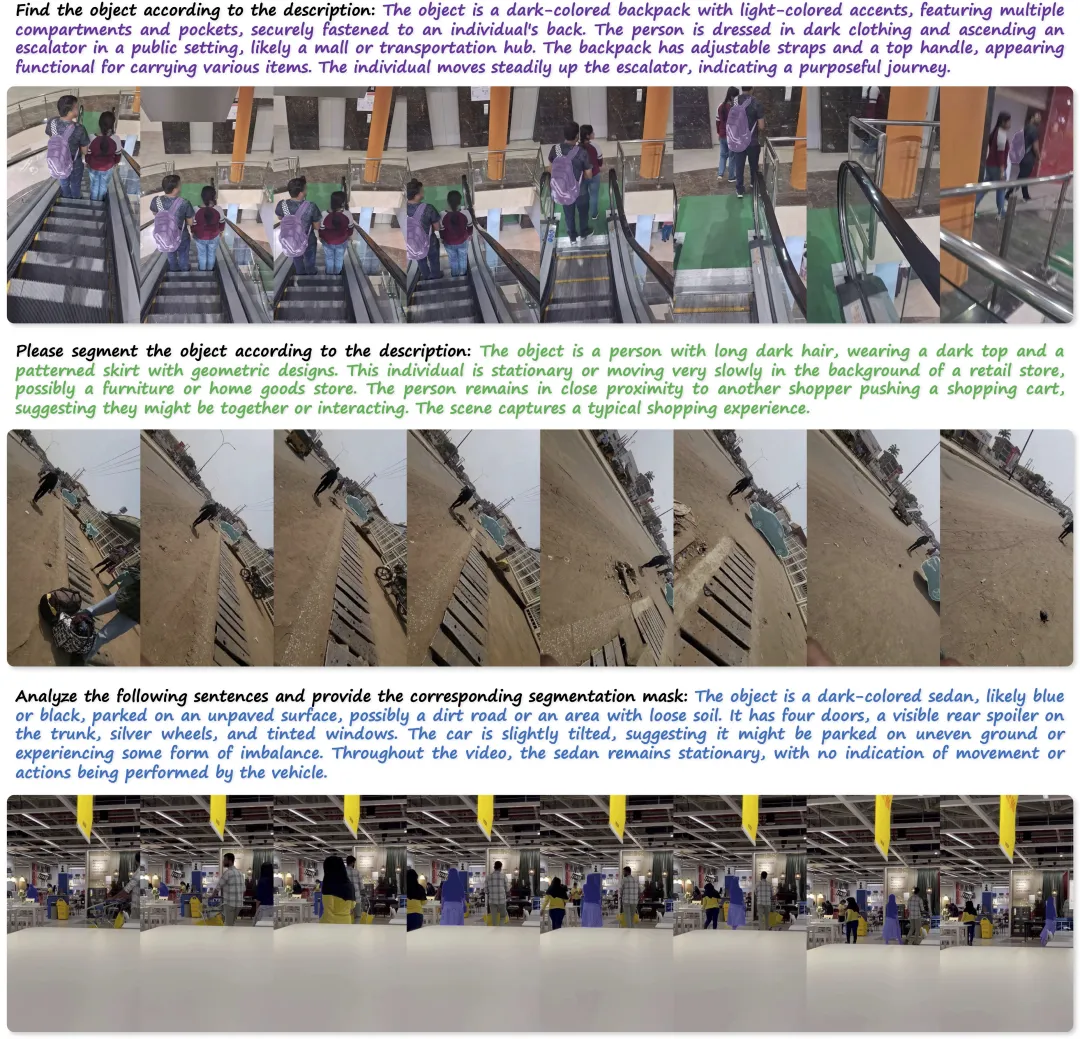

以下例子展现了UniPixel在实际场景中的分割和推理结果。

得益于其端到端掩码生成能力以及语言与视觉模块的深度协同,该模型能够在理解复杂问题的基础上,精准地定位出问题所指向的目标区域,并将其用于帮助推理。

△PixelQA任务的可视化

△ReVOS数据集上结果的可视化

△ReasonSeg数据集上结果的可视化

△Ref-SAV数据集上结果的可视化

UniPixel的提出,是多模态AI从“模态对齐”走向“细粒度理解”的重要里程碑。它不仅打通了对象指代与分割之间的技术壁垒,更将区域感知与语言推理有效融合,在像素层面实现了真正的理解与互动。

通过这种全新范式,可以看出多模态大模型在未来的发展中,可能不再只是“全局通感”的超级大脑,而是能精准聚焦、灵活应对、自然交互的智能体。

而UniPixel,或许就是这种新型AI形态的原点。

项目主页:https://polyu-chenlab.github.io/unipixel/

论文链接:https://arxiv.org/abs/2509.18094

代码链接:https://github.com/PolyU-ChenLab/UniPixel

开源数据:https://huggingface.co/datasets/PolyU-ChenLab/UniPixel-SFT-1M

在线Demo:https://huggingface.co/spaces/PolyU-ChenLab/UniPixel

文章来自于“量子位”,作者“UniPixel团队”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0