自回归(AR)大语言模型逐 token 顺序解码的范式限制了推理效率;扩散 LLM(dLLM)以并行生成见长,但过去难以稳定跑赢自回归(AR)模型,尤其是在 KV Cache 复用、和 可变长度 支持上仍存挑战。

Fast-dLLM v2 给出了一条务实路线:将预训练 AR 模型适配为适配为能并行解码的 Block-dLLM—— 且只需~1B tokens 量级的微调即可达到 “无损” 迁移,不必训练数百 B tokens(如 Dream 需~580B tokens)。在 A100/H100 上,它在保持精度的同时,将端到端吞吐显著拉高,最高可达 2.5×。

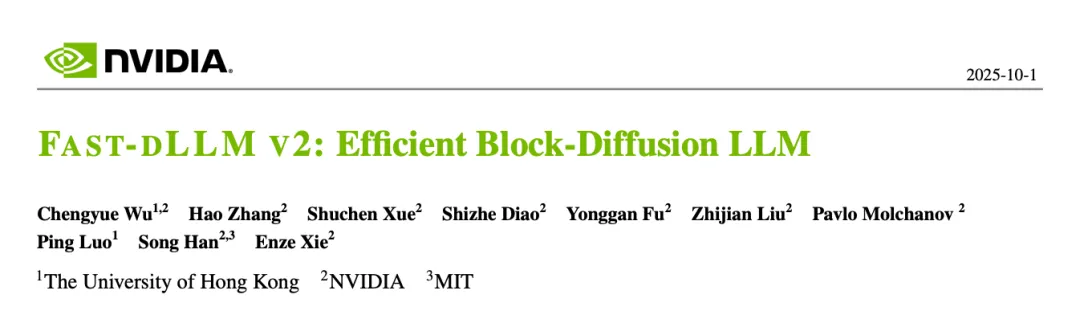

- 作者单位:HKU、NVIDIA、MIT。

- 论文链接:https://arxiv.org/pdf/2509.26328

- 项目网站链接:https://nvlabs.github.io/Fast-dLLM/v2/

- 代码链接:https://github.com/NVlabs/Fast-dLLM

核心看点

- 少量数据适配(~1B tokens):已有的 AR 模型(如 Qwen2.5-Instruct 1.5B/7B)用约 1B tokens 的微调就能适配成 Block Diffusion LLM,不必训练数百 B tokens(如 Dream 需~580B tokens)。

- 架构上 “AR 友好”: 设计上 块内双向、块间因果;配合互补掩码与 token-shift,让模型既保留 AR 的语义组织与可变长度能力,又获得块内并行带来的效率增益。迁移过程更自然、数据效率高。

- 层级缓存 + 并行解码:块级 KV Cache + 子块 DualCache,配合置信度阈值的并行解码,端到端最高 2.5× 提速。

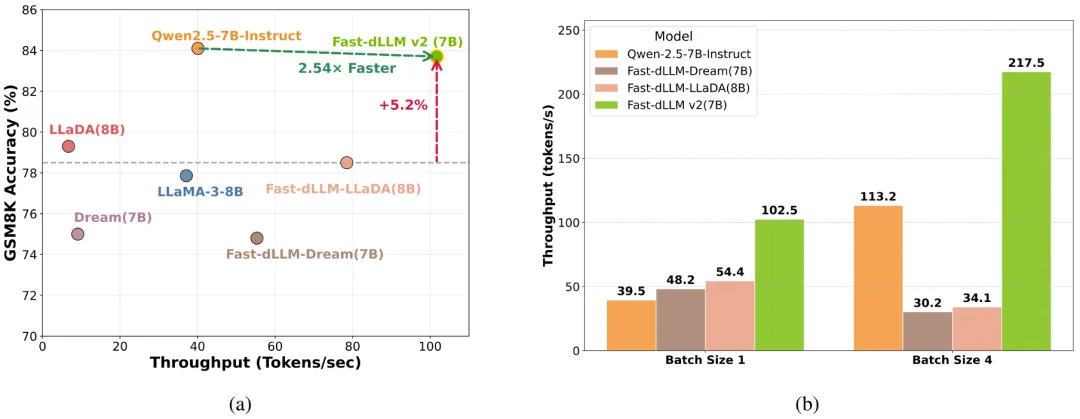

- 大模型验证:在 7B 规模上保持与 AR 相当的生成质量下,吞吐对比 Qwen2.5-7B-Instruct 提升 2.54×。

原理与做法:从 AR 到 Block Diffusion

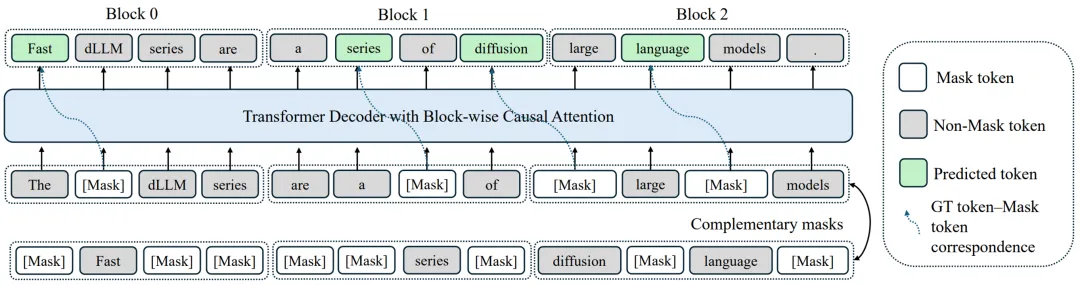

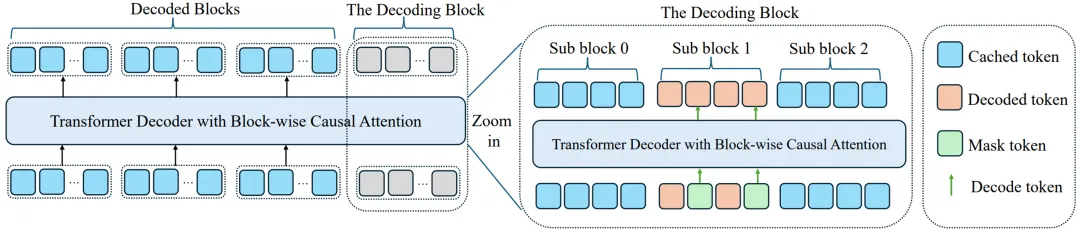

1)块式扩散与 AR - 友好注意力

Fast-dLLM v2 按固定块大小把序列切成若干块:块内双向注意力以并行去噪,块间保持左到右的因果关系,从而既能并行、又能沿用 AR 的语义组织、可变长度和 KV Cache;配合互补掩码(complementary masking)与 token-shift,保证每个 token 都在 “可见 / 被遮” 两种视角下学习,稳定恢复 AR 语义表征。

2)层级缓存(Hierarchical Cache)

- 块级缓存:已解码块的 KV 直接复用,天然支持 KV Cache。

- 子块缓存(DualCache):在部分解码的当前块内部,同时缓存前缀与后缀的 KV 激活,减少迭代去噪揭示 / 复原时的重复计算,贴合并行细化流程。

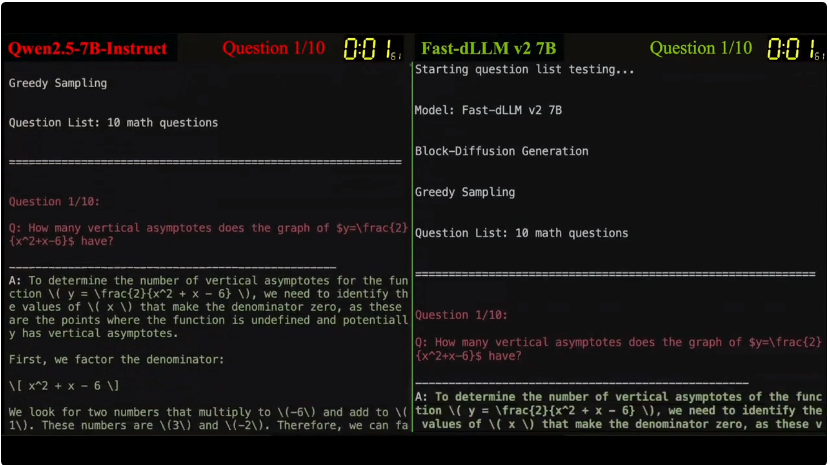

3)置信度感知的并行解码

延续 v1 的思路:当某位置的预测置信度超过阈值(如 0.9),即可并行确定多个 token,其余不确定位置保留待后续细化。在 GSM8K 上,阈值 0.9 时吞吐从 39.1→101.7 tokens/s,提速约 2.6×,精度影响可忽略。

性能结果

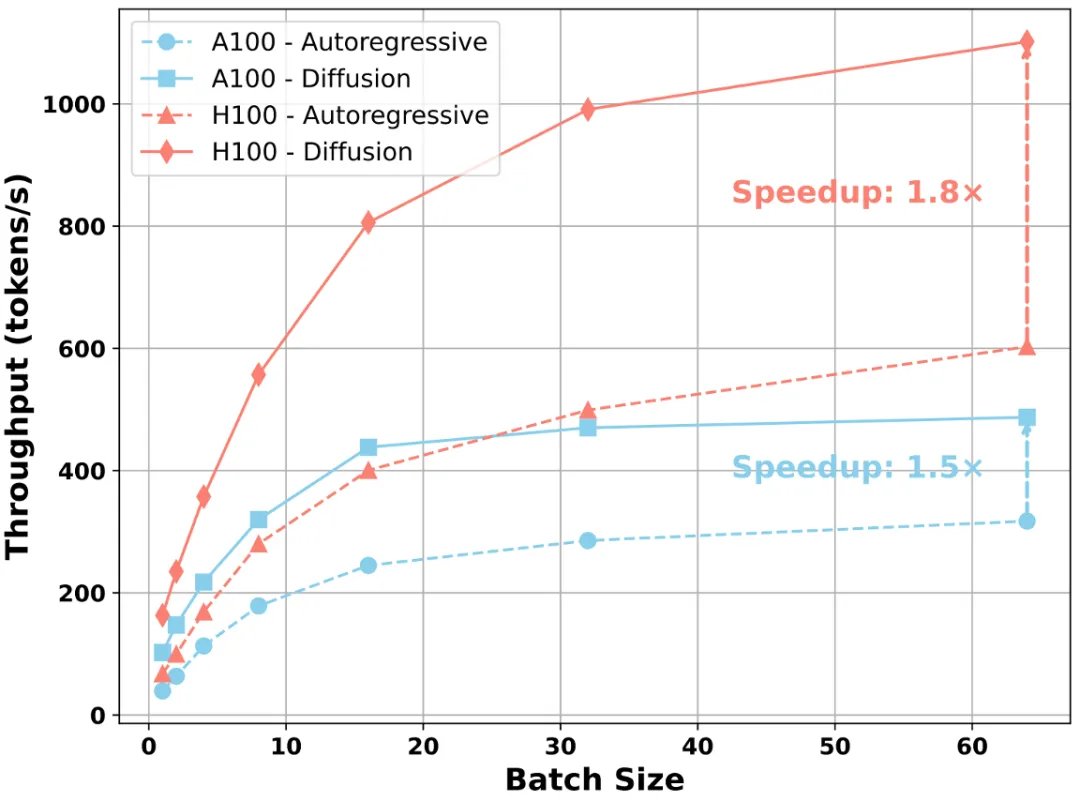

- 端到端加速:综合实验显示,对标准 AR 解码最高 2.5× 提速,同时维持生成质量。

- 7B 规模吞吐与精度:在 A100 上,Fast-dLLM v2(7B)吞吐为 Qwen2.5-7B-Instruct 的 2.54×;同时对比 Fast-dLLM-LLaDA 还有 +5.2% 的准确率提升(GSM8K)。

- Batch / 硬件可扩展性:在 A100/H100 上随 batch 增大,扩散解码的并行优势更明显;A100 上可达~1.5× 吞吐加速,H100 上最高可达~1.8× 加速。

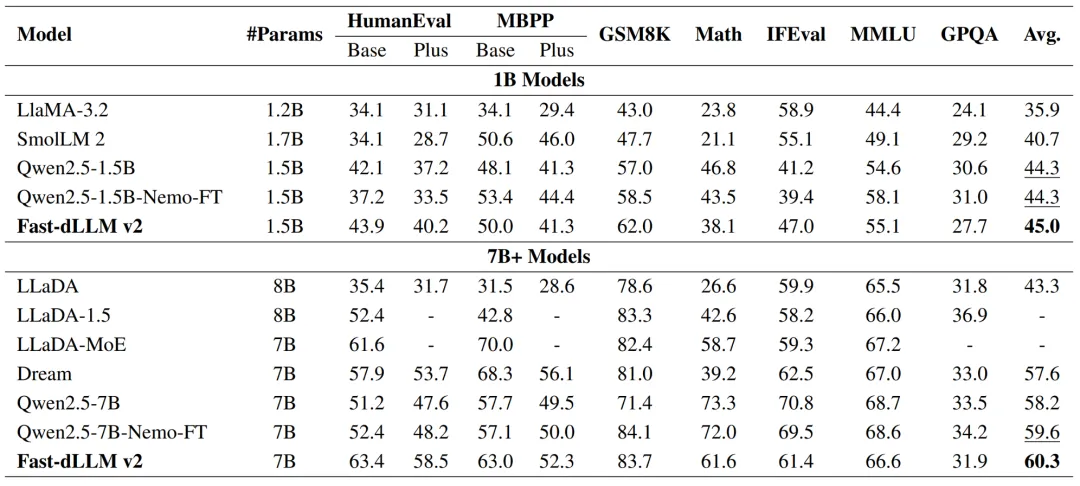

- Benchmark 综合得分:

- 1.5B:平均分 45.0,超过 Qwen2.5-1.5B 与 Qwen2.5-1.5B-Nemo-FT(使用相同的 LLaMA-Nemotron 后训练数据集上对 Qwen 做的标准 NTP 微调 baseline);在同量级(≈1B 规模)的扩散类与 NTP 训练的 AR 类模型里,属于新的 SOTA。

- 7B:平均分 60.3,超过 Qwen2.5-7B-Nemo-FT(59.6) 和 Dream(57.6);多数单项基准上持平或更好。评测覆盖 HumanEval/MBPP、GSM8K/MATH、MMLU/GPQA、IFEval 等多项基准。

训练成本

数据 / 算力成本:以~1B tokens 量级微调把 AR 模型适配为 Block Diffusion LLM(对比 Dream 的~500B tokens),门槛显著降低;论文给出了 Qwen2.5-Instruct 1.5B/7B 在 64×A100 上的具体训练步数与配置,只需要几个小时即可完成训练,可复现性强。

总结

Fast-dLLM v2 提供了一条务实路线:用很少的数据(~1B tokens)把 AR 模型适配为 Block Diffusion LLM,相较等规模 AR 的端到端吞吐量约提升 2.5×,精度保持可比,并且关键开关(块大小、阈值、缓存)都能工程化地按目标调优,这是一个成本与收益比较均衡的解法。

文章来自于“机器之心”,作者“机器之心”。

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner