「一个很有主体性的模型」

过去一年,AI圈的词语通货膨胀是不是有点太严重了?

动辄「又一个DeepSeek时刻」,动辄「开启XX时代」,随便一个产品或功能的推出或更新,都要逼着历史的车轮滚滚向前。

我只想说时光时光慢些吧不要再让我变老了🎶

最近害我离退休更近一步的是PixVerse R1。

此产品一出,AI视频的DeepSeek时刻也到来了,无限流时代也开启了,网友家人们又震撼激动不已了。

于是我也跟风试了试咱们这个全球首个支持最高1080P分辨率通用实时视频生成模型。

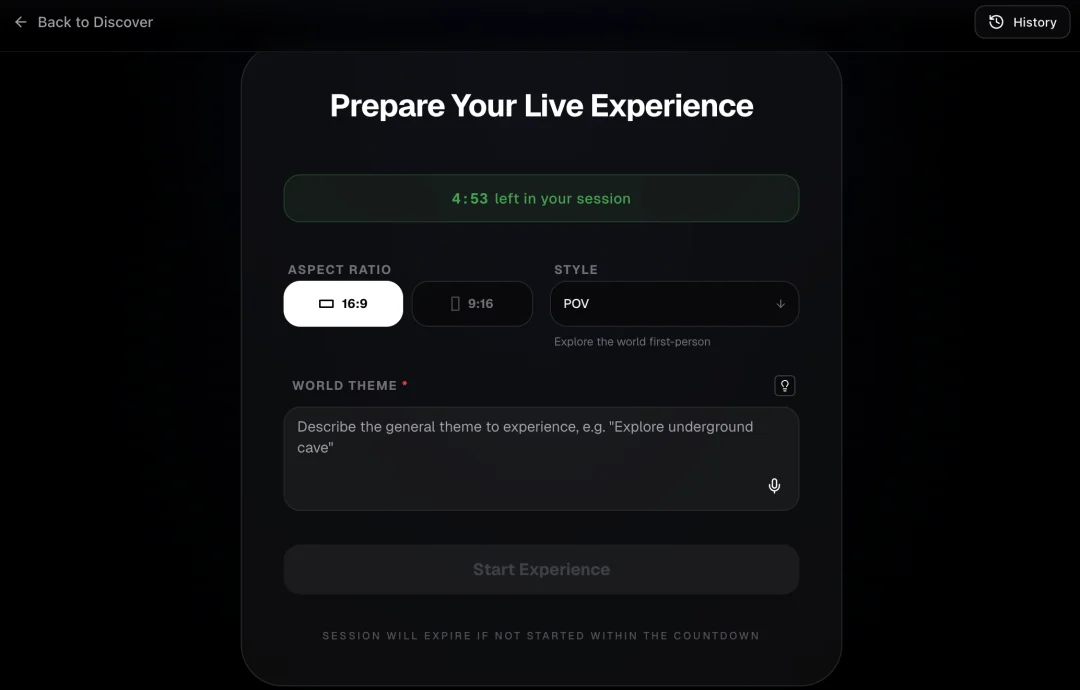

至于这个实时视频生成是什么意思,我们后面再详细讲。

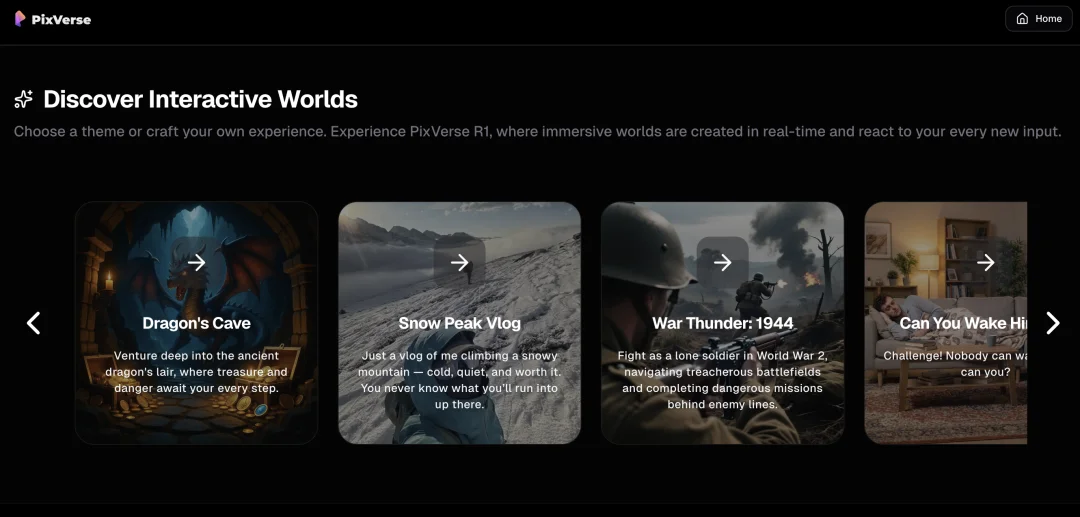

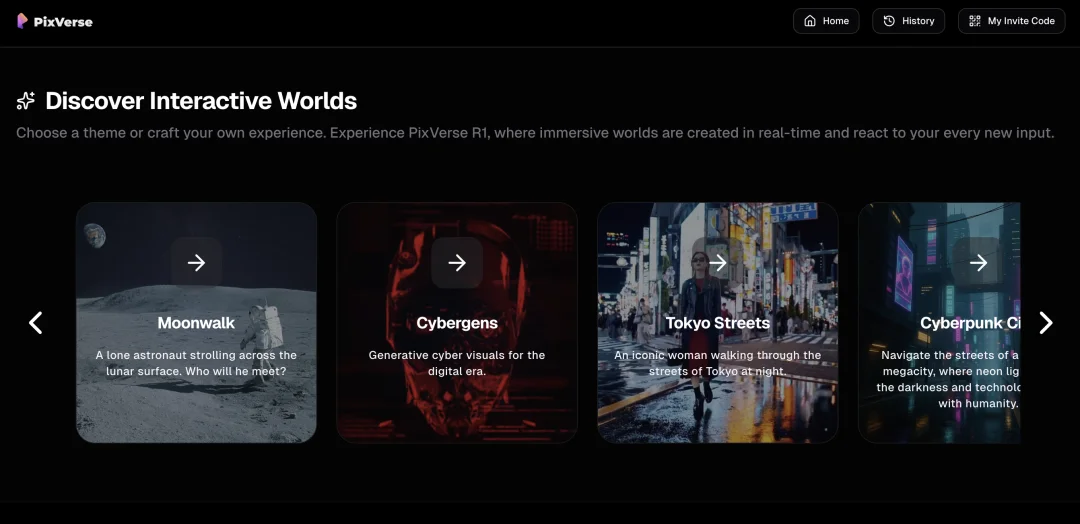

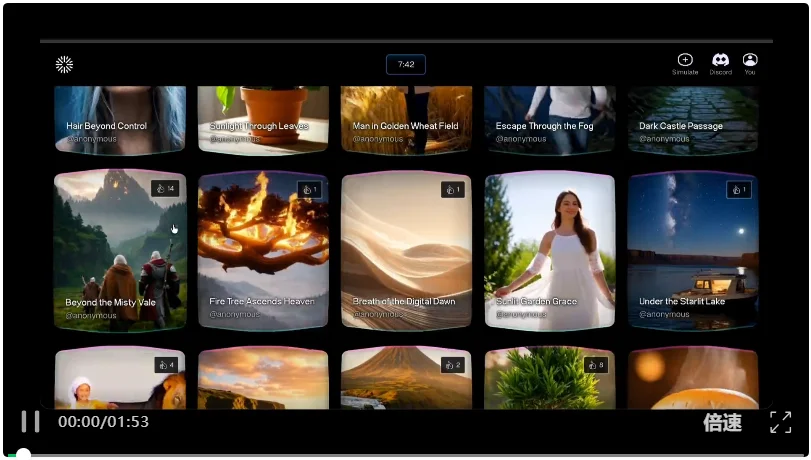

输入邀请码点进来之后,看到PixVerse R1贴心地给我们准备了几个世界观模板。

从龙与地下城到塞尔达,从滑雪潜水到月球行走,文艺b、真假中产、二次元哥姐们以及各类小众爱好者都能在这里找到自己的一席之地。

哪怕没找到,也能输入提示词定制属于自己的世界观。

不仅能选择画面比例,还能选择视角。

我嫌麻烦,直接点进那个叫Tokyo Streets的模板,尝试在东京街头嘎油嘎油。

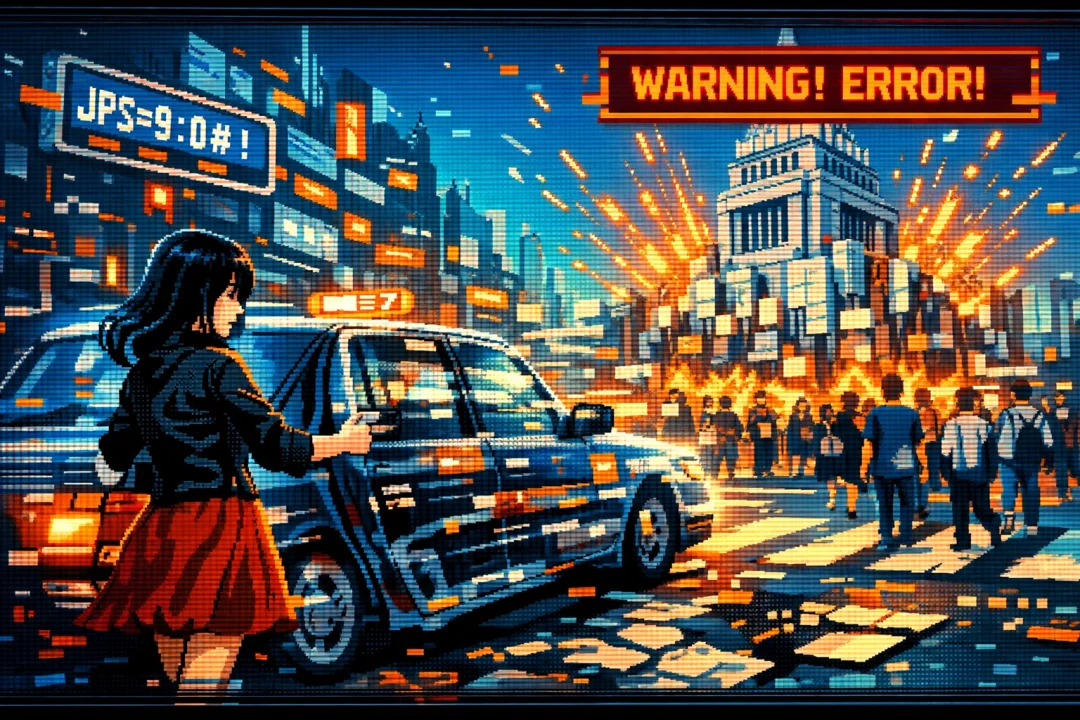

按下开始按钮,视频就自动开始生成,一个黑衣红裙女子在川流不息的十字路口漫步。

而且是一直漫步,同时移步换景,周围的高楼大厦和路人甲都实时生成出来。

这也是PixVerse R1宣传的一个重点:无需人工干预,视频自动无限流生成。

现在因为给大伙免费体验所以限时5分钟,技术上可以实现生成到永远。

一个很有主体性的视频模型。

然后如果你也有一些主体思想,就可以在页面下方的对话框里输入提示词,随时改变视频的走向。

于是我在颅内模拟了一个,该女子假意嘎油(咸鱼注:东北话溜达)在日本街头,实则是准备对安倍晋三进行正义执行,最后被哥斯拉从法院救走的故事。

用PixVerse R1做了一下,生成出了下面这个作品。

和目前市面上流行的Sora 2、Veo 3不一样,PixVerse R1确实能做到近乎实时生成。

在输入提示词的5秒之内,画面就能随即改变。

而且不是硬切,画面是连续的。

但该说不说,问题很多。

比如这个画面虽然连续,但变化并不丝滑,甚至我觉得都不如叠化转场。

在短片中有一个情节,是我让这个女主角打车前往法院,并进入法院内部。

结果这个出租车直接幻影坦克显形了,法院建筑也平地起高楼了。

之前我怎么不知道日本基建这么速度?

再比如,人一多就乱套。

当我给女主角委派了山上彻也支线任务,整个画面就完全崩溃了。

我输入两段提示词:

「安倍晋三从天而降,挡住了女子的去路;女的掏出一把机关枪,扫射安倍晋三。」

生成的这玩意有人能看懂不。

男的一出现,女的就掉线,但最后男的直接变身女的了,这里面引战成分太多我没法思考了。

但总的来讲,这已经不是人物一致性能不能保证的问题了,这连人物是不是一个性都没法保证了。

再再比如我最不懂得一点,就是这个女主角永远在走路,永远Citywalk永远热泪盈眶😭

不管是遭受了邪恶公审:

还是偶遇了路上猛然出现的哥斯拉:

乃至于被核废水给袭击了之后:

姐们都是假装一切都未曾发生,把走路作为方法。

且和出现的一切都不发生任何关系,保持清冷感。

哪怕我明确发布指令,跪下来求女主角停下来,她也是师承是枝裕和,步履不停,永远在路上。

好似迷失东京了一般。

就这让我陷入深思:如果你的实时生成,就是把一个元素像贴图一样扔进来,和角色也不产生交互,也没推进任何剧情,这对视频到底有什么意义?

因为我看到很多博主说,这个PixVerse R1能无限流探索,能玩跑团,我诚心发问,你们是咋用它跑团的?

主角就一直走,看到NPC也不说话,遇到伙伴也不接收,学了技能也不用,最后见到boss也不打,boss也不打他,就一直走。比走线的都爱走。

家人们这不是跑团,这是暴走团。

至于什么人物走形、字体乱码,我觉得这都是产品初期的小问题,日后肯定是会不断优化。

但上面这三点是真让我用起来很难受的。

这时候有人要说了,你用评判传统AI视频的方式来对PixVerse R1指指点点,是扬短避长,是不讲武德搞偷袭。

因为呢,咱PixVerse R1可不是简单的AI视频模型,人家是世 · 界 · 模 · 型。

啥叫世界模型?说实话我之前没有仔细研究过,搜了一下发现这词处于话语权争夺阶段,各个山头都有自己的说法和产品。

像李飞飞的Marble和Google做的Genie 3,是生成那种可拓展可操纵的3D世界。

英伟达的世界模型属于toSi项目,生成视频给机器人看,用来训练自动驾驶汽车啥啥的。

PixVerse R1呢,则更像是Odyssey-2的路数,就是先限定一个主题,然后生成无限的连续的的视频,中途还能输入提示词随时修改。

Odyssey-2的界面

我也用了下Odyssey-2,发现它的问题是,随着视频生成,角度越来越仰,人物越来越大,画面也越来越疯狂,就跟做梦一样。

他们自己估计也知道,所以在官网亲自找补说,咱们这产品就是用来模拟你的实时梦境的。

用户直接一拳打在棉花上。你这都是梦了我还有啥说的,同一个世界模型同一个梦想呗。

但Odyssey-2这种越往后视频越没法看的问题,是此类实时互动视频产品的通病。

就是随着视频的不断生成,本来不起眼的小问题和预测会不断累积,导致视频越长越走形。

PixVerse R1的画质比Odyssey-2好了不少,但在这个问题上没什么改进。

我打开一个叫Moonwalk的模板,试图在里面击碎美国登月的谎言。

一开始画面还挺流畅自然。

到了三四分钟的时候,背景的星空直接像素化了,疑似地球流浪了黑客帝国情景再现了。

越往后越没法看这事,PixVerse官网的报告里倒是也承认了。

PixVerse R1或许是为了把这方面的影响减到最低,对自己使用了大记忆清除术。

具体而言,画面里这个主角,无论你是让他跑还是跳,让他换衣服还是摘眼镜,是变性还是变形,5秒之内都会回到原样。

且无论当我尝试在画面中增加任何人物动物地形建筑之后,它确实会生成,但5秒之内也会全部消失。

然后回到原点,开始漫无目的地行走,等待下一个指令。

咋说呢,之前上面不是提到了好几个流派的世界模型,它们虽然产物不同,但核心点是统一的,就是要既能实时交互,又保持逻辑上的持续性。

或者至少得朝这个方向努力,不然咋能称之为一个世界。

PixVerse R1在实时交互这方面,确实是做的不错的。

但在持续性这方面,它直接通过强行回到起点这个行为,把需要解决的麻烦绕过去了。

对吧,咱不是没给你生成这个那个的,也不是对后面没影响,只是它自己消失不见了,咱也不知道咋回事,但咱这个模型是持续的无限流的一直生成到世界末日的。

这叫耍赖,兄弟。

你这不就是硬把自己往世界模型这个概念上凑,想通过跟网友之间的信息差弯道超车曲线救国吗?

看现在这个全网盛赞的状态,这招还可以。

最后还是中肯地说一下,PixVerse R1有自己的优点。

比如它确实好玩。用别的视频模型的时候总有一种要生成个什么杰作的上班心态,用PixVerse R1就是纯生成,发狠了忘情了不管结果了,就纯逗自己玩,挺有乐子的。

而且如果它非得说自己是世界模型,那它还是个少有的咱老百姓能上手用的世界模型,这真世界大同了。

但是在视频生成能力还处于从夯到拉排行榜的NPC这个阶段的时候,就开始捣鼓世界模型,是不是有点没学会走就开始急着跑,没好好跑就开始炒了呢?

(本文封面由ChatGPT 生成,纯人工写作)

文章来自于“葬AI”,作者 “罗子马”。

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0